本文是NeurIPS 2022入选论文Rethinking Lipschitz Neural Networks and Certified Robustness: A Boolean Function Pespective 的解读。该论文在NeurIPS 2022上荣获Oral Presentation(排名前1.7%)。该论文由北京大学王立威教授课题组完成,其中作者张博航为北京大学智能学院2019级博士生;作者姜度为北京大学智能学院2022级博士生;作者贺笛为北京大学智能学院助理教授。

本文从理论角度系统探究了深度学习领域的核心问题:是否能够从模型层面出发,设计出具有天然对抗鲁棒性的神经网络?

对于基本的L无穷鲁棒性问题,本文揭示了Lipschitz神经网络的表达能力与其拟合布尔函数能力之间的深刻联系。从这一角度,本文首先指出了标准Lipschitz神经网络表达能力的本质缺陷,并进一步探究了近期所提出的新型网络结构(如L无穷网络)背后的深层次机理。最后,本文提出了一个鲁棒性神经网络的统一框架,称为SortNet(排序网络),该网络结构在CIFAR-10、ImageNet等多个数据集上均取得了SOTA的表现。

论文: https://arxiv.org/abs/2210.01787

一、对抗鲁棒性背景介绍

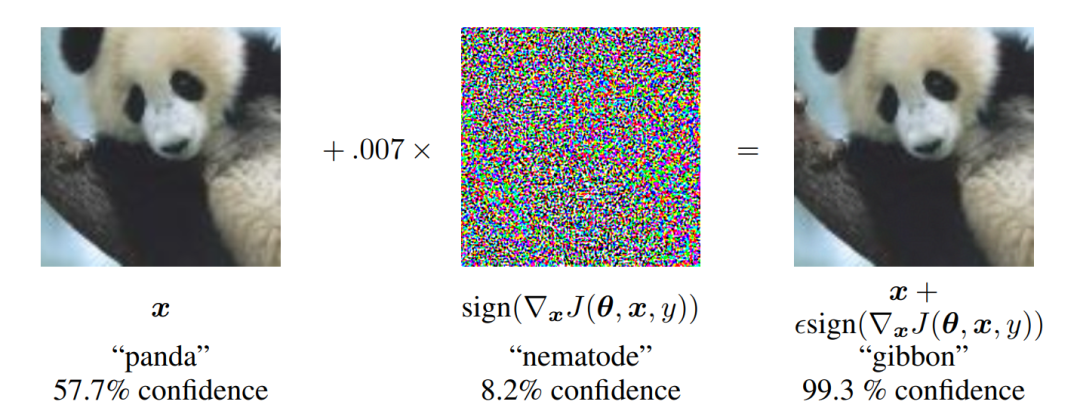

众所周知,深度神经网络在实际应用中存在着一个严重的缺陷——不具有鲁棒性(robustness) 。例如,对于标准的分类任务,尽管ResNet等现代神经网络已经能够在ImageNet等数据集上取得卓越的表现,但往往对输入图片加上一个人眼看不见的微小扰动,就足以让网络预测出完全错误的结果。我们把扰动后的图片称为对抗样本(adversarial example)。对抗样本的广泛存在对深度学习的安全性和可靠性造成了严峻的挑战,并制约了其在自动驾驶、医疗等领域的应用前景,成为了悬在深度学习头顶的一把达摩克里斯之剑。

上图中,右边的熊猫图片是由左边的图片叠加一个微小扰动得到,然而神经网络却将其错误预测成了长臂猿。

那么为什么神经网络的鲁棒性很差呢?其核心原因在于,将神经网络看成一个从输入到输出的函数时,该函数的Lipschitz常数过大。具体而言,Lipschitz性质从数学上刻画了神经网络输出随输入扰动变化剧烈的程度。因此,如果我们能够设计Lipschitz常数受限的神经网络,便自然获得了可证明的鲁棒性(certified robustness)。

然而,本文的理论结果表明,简单地限制神经网络的Lipschitz常数往往会损害模型的表达能力(即拟合数据的能力)。用数学的语言来说,我们所要研究的核心问题是:如何设计Lipschitz常数受限的神经网络,同时仍具备足够的表达能力,可以拟合任意Lipschitz连续函数?本文将系统回答这个问题。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢