OpenAI发布的聊天机器人ChatGPT着实是火出圈了,上知天文、下知地理,不仅理性、也有感性,写一篇800字的作文都不用打草稿的。

但ChatGPT的「故事续写」遵循逐词生成的线性逻辑,跟人类的写作方式相去甚远,注定了ChatGPT只能是一个写作助手,无法成为真正的AI作家。

最近田渊栋博士团队在EMNLP'22上发布了一个基于大规模语言模型的故事生成器Re3(Recursive Reprompting and Revision)框架,通过设计prompt让模型生成一致性强的故事,完全不需要微调大模型。

论文链接:https://arxiv.org/pdf/2210.06774.pdf

代码链接:https://github.com/yangkevin2/emnlp22-re3-story-generation

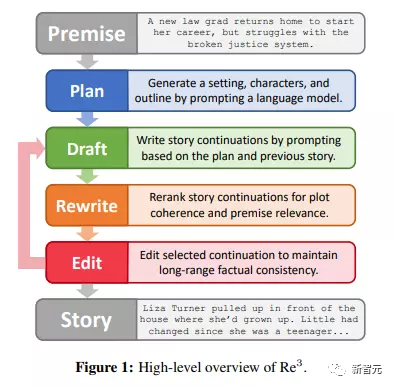

Re3框架没有采用语言模型的逐词生成的线性逻辑,而是改用层次化生成方式:先在Plan阶段生成故事角色,角色的各种属性和大纲,然后在Draft阶段给定故事大纲和角色,反复生成具体的段落,这些具体段落由Rewrite阶段筛选,挑出与前一段落高度相关的生成段落,而丢弃关系不大的(需要训练一个小模型),最后在Edit阶段修正一些明显的事实错误。

作者表示,相比语言模型毫无道理的逐词生成,迭代修改的思路更符合人类作家写作的一般方式。

从最后的效果来看,与当前其它的文本生成算法比较,Re3写出来的故事长很多,最长的故事有7500个词,人来看的话需要看半小时左右。不夸张的说,比其它的方案要长10倍以上。

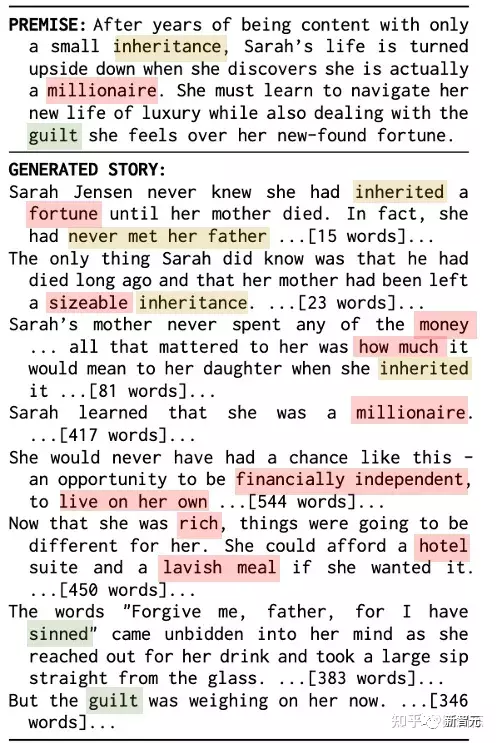

最关键的是,Re3生成的文本相当自洽,至少不会出现主要角色突然换人,或者文风突变这种情况,前后的线索也能对上一些,也没有其它方案经常出现的陷入无限文字循环的情况。

Re3生成的小说,全篇近3000词,连贯性不错

与直接从同一基本模型生成的类似长度的故事相比,人类评估人员判断Re3的故事中有更多的故事具有连贯的总体情节(增加14%),并且与给定的初始前提相关(增加20%)。

尽管如此,Re3目前相比人类作家仍然差得很多,主要问题在于人物没有动机,情节安排毫无规律,细节杂乱无章,更不用谈行文的步调、节奏或是主旨,读起来会比较累。

作家一般讲究「草蛇灰线,伏笔千里」,人物的重要细节和举动,场景中带有情绪色彩的描绘,都有可能成为下一步故事发展的决定性因素,更不用说人物间错综复杂的关系和出乎意料的情节展开。这些高阶写作能力,AI现在还远远无法做到。

文章的第一作者Kevin Yang是加州大学伯克利分校的四年级博士生,主要研究兴趣为结构化设置下的可控自然语言文本生成,如利用可控生成的结构化方法来改善长篇文本的一致性。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢