还记得今年9月,ONNX Runtime项目(ONNX社区流水线核心组件)正式提供对华为昇腾硬件平台的支持,成为ONNX Runtime支持的首个面向端、边、云全场景的国产推理训练AI硬件平台后端。

正式版v1.13.0预计年底发布。

这意味着在此前昇腾主动适配ONNX模型的同时,从2023年开始,ONNX社区版本发布流程中,将开始逐步原生支持昇腾硬件平台,通过开源社区共建大幅降低用户和厂商的成本,实现生态创新共赢。

ONNX社区简介

ONNX (Open Neural Network Exchange),是由LF AI & Data Foundation[2]发起并维护的一种AI模型格式,用于在各种深度学习训练推理框架之间转换的一个通用表示格式。

而ONNX Runtime是微软发起的基于ONNX模型格式的推理运行时框架,目前已是ONNX社区流水线的核心组件,以及ONNX运行时的事实标准。

根据官方数据,目前有超过25款AI框架支持ONNX模型格式,并且ONNX和ONNX Runtime的落地使用组织或企业分别超过50和25家。

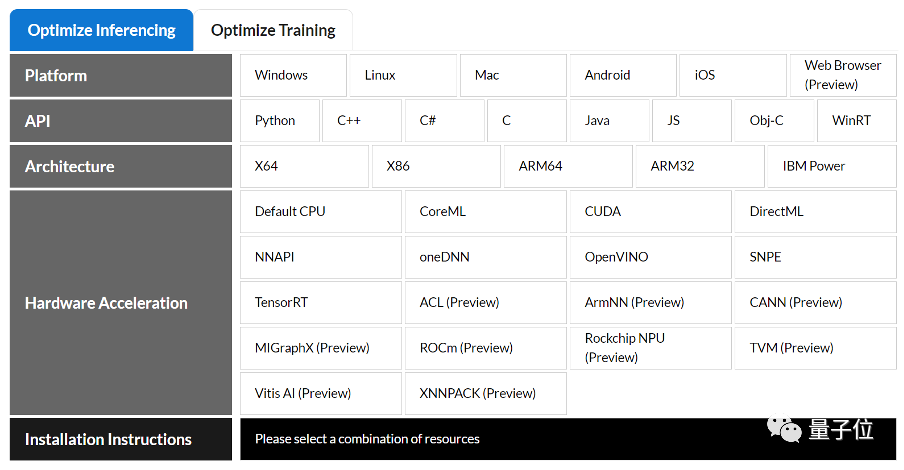

△最新ONNX Runtime的生态全景图

ONNX Runtime北向支持多种开发语言,包括Python,C,C++,C#,Java,js等;南向支持多种运行后端(Execution Provider,包括但不局限于CPU、CUDA、CoreML),使用ONNX Runtime,用户可以基于多种语言快速无缝在多种后端上直接运行ONNX模型,且不再需要额外的开发适配工作。

相关链接:

[1]https://github.com/microsoft/onnxruntime/pull/12416

[2]https://lfaidata.foundation

[3]https://github.com/onnx/models

[4]https://github.com/learningbackup/ai/blob/main/ascend/CANN%20Development%20Guideline.md

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢