最近一段时间,以扩散模型为代表的生成模型越来越能逼真地生成图像和视频,一方面是一群人的狂欢,这是AI的进步,另一方面却是另一群人的担忧,这是AI的危险。

AI技术可以造福人类,当然也可以用来作恶。

社交媒体上的视频造假已经让大家不再坚信“眼见为实”,而金融领域的人脸伪造则成为必须面对的系统性威胁。

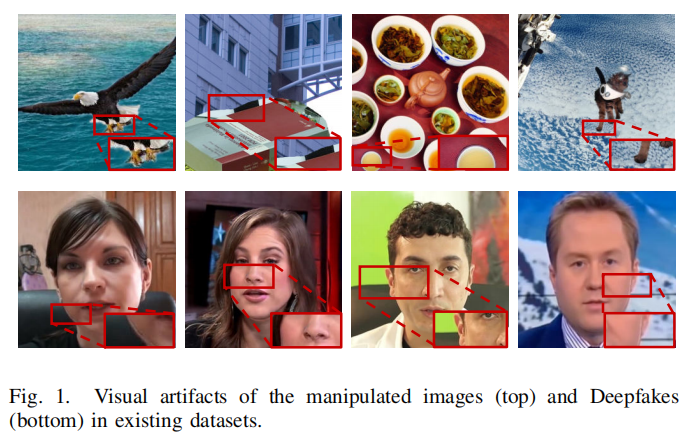

可以看到,经过编辑后的图像整体表现还算比较自然,但仔细放大,还是有一些不和谐的痕迹。

所以面向多媒体数据的篡改(Tampering ,偏向于多媒体内容的编辑修改)和人脸伪造(Deepfake ,偏向于对多媒体数据中人脸部分的编辑修改)检测技术越来越重要了,成为研究社区不得不讨论的话题。

那么,AI可以打败AI吗?

今天向大家推荐一篇新出的论文『Fighting Malicious Media Data: A Survey on Tampering Detection and Deepfake Detection』,作者参考了377篇文献,系统性综述了篡改与人脸伪造检测领域的相关概念、数据集、技术分类与未来趋势。

-

论文地址:https://arxiv.org/abs/2212.05667

作者来自复旦大学与马里兰大学。

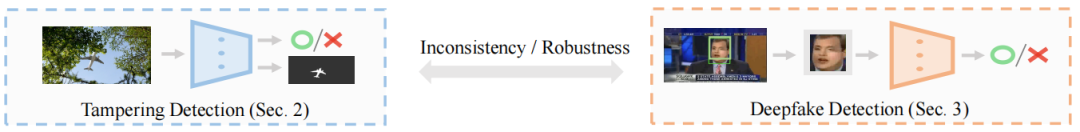

▲篡改检测与人脸伪造检测技术示意图

可见,篡改检测(Tampering Detection)要对“整幅图片”进行判断是否经过篡改,如果有的话,以Mask的形式将篡改部分标识出来。

而人脸伪造检测(Deepfake Detection)是对“人脸区域”进行分类,给出是否是经过人为编辑伪造的。

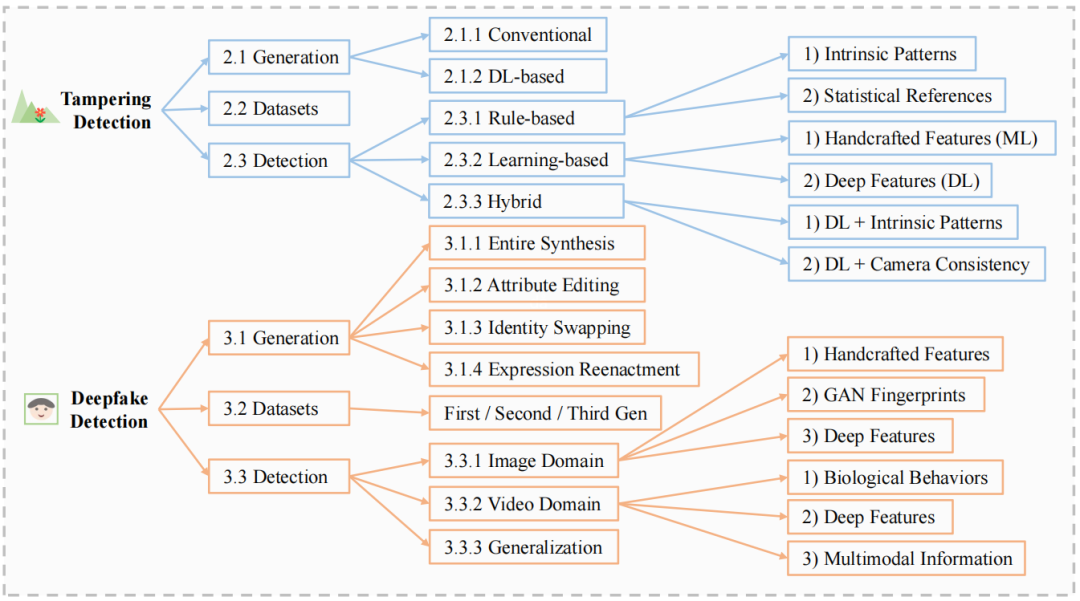

▲论文总结的相关技术纵览

其中 Genetation(生成) 指篡改与伪造技术,Detection(检测)是指相关检测技术。First/Second/Third Gen指第一代、第二代、第三代数据集。

▲图像篡改的三种模式

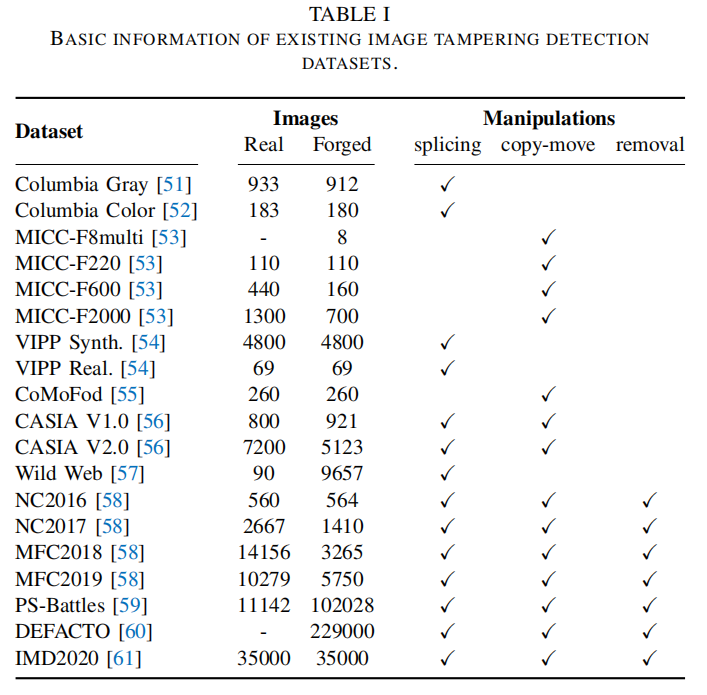

作者列出了篡改检测相关数据集:

从统计数据看,年份越近的数据集,数量越大,人工编辑的模式越多。

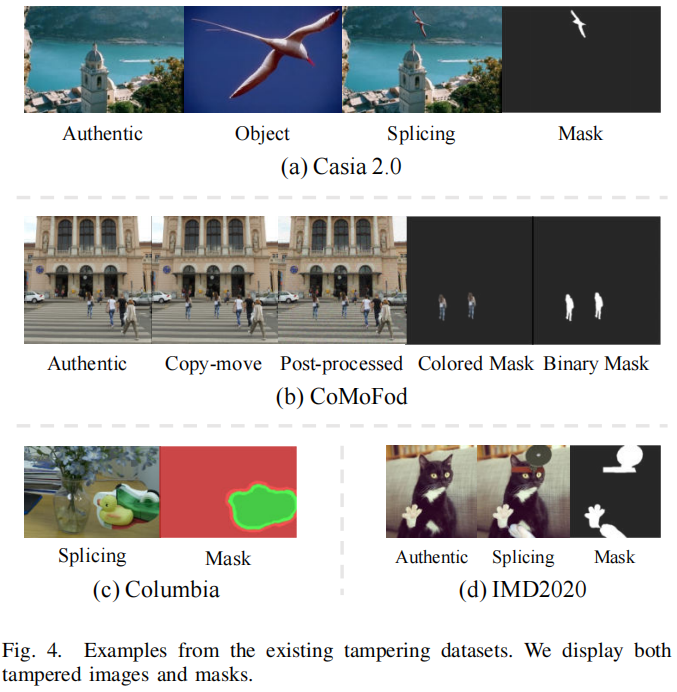

▲相关数据集展示

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢