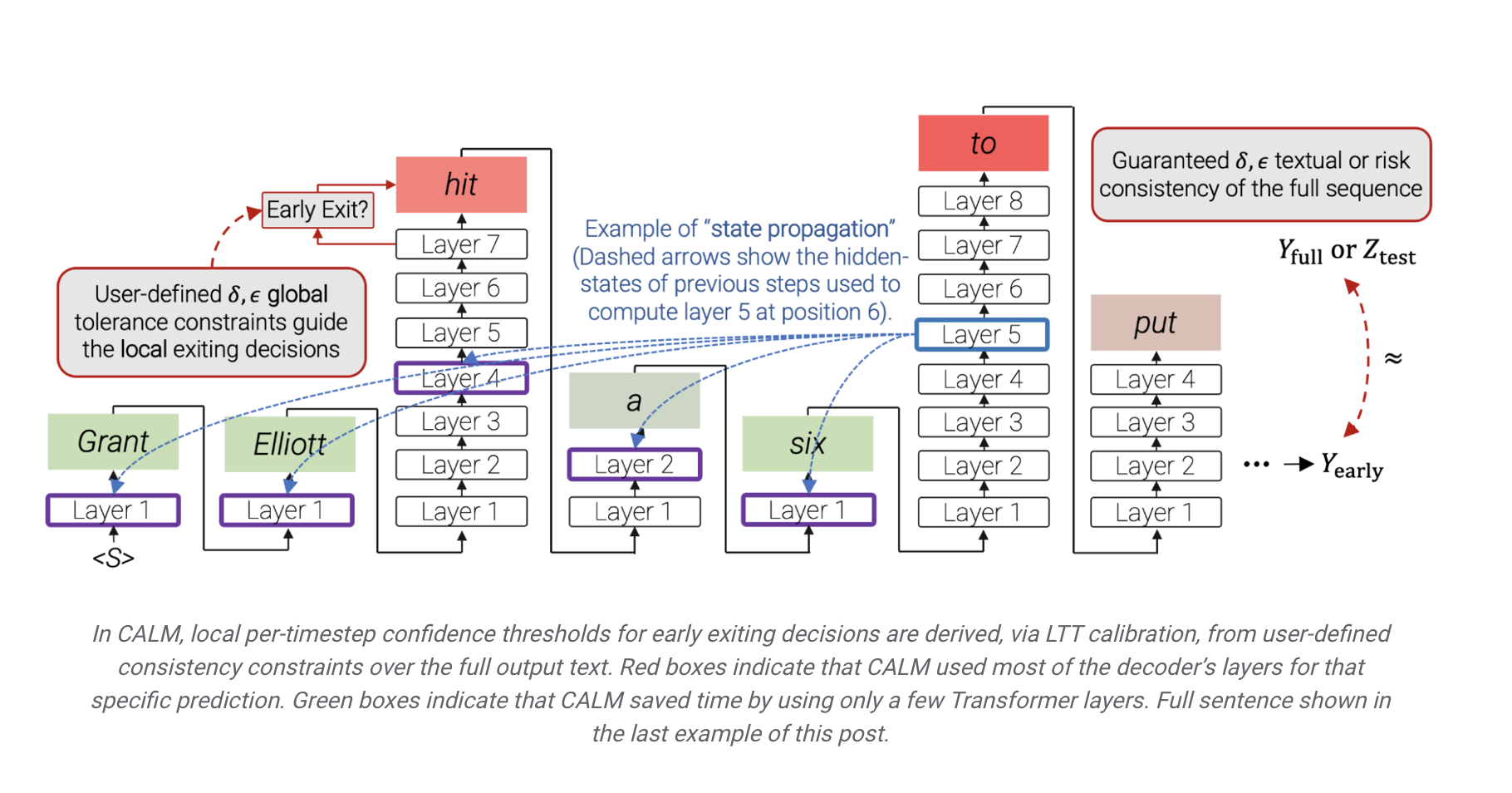

谷歌研究研究科学家Tal Schuster 在NeurIPS 2022 发表了 Confident Adaptive Language Modeling(CALM)模型,通过提高推理时效率来加速语言模型(LM)的文本生成,其原理是“直觉认为某些下一个单词的预测比其他单词更容易”。当前 LM 为所有预测投入相同数量的计算能力,而 CALM 将计算资源动态分布在生成的时间步长上,允许模型在足够自信时提前退出计算序列。

论文地址 https://arxiv.org/abs/2207.07061

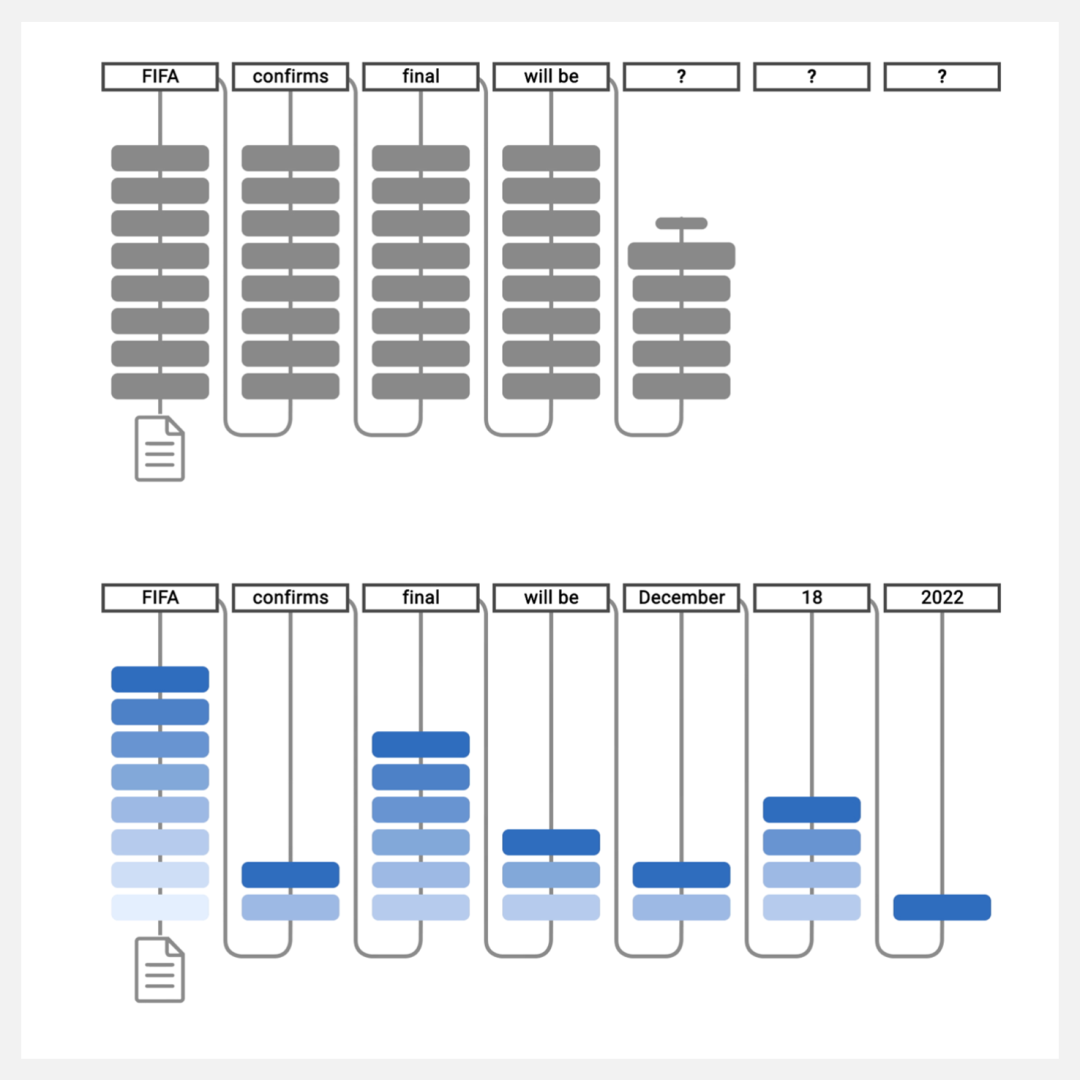

如下图所示,使用常规语言模型(上方)和 CALM(下方)生成文本。CALM试图做出早期预测。一旦足够自信(深蓝色调),它就会跳过并节省时间。通过选择性地将更多的计算资源分配给更难的预测,CALM 可以更快地生成文本,同时保持输出质量。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢