深度学习随着大数据的不断产生在日常生活生产中发挥着愈来愈重要的作用。针对视频分析的深度学习方法更是随着各类大型数据集和大型预训练模型的推广,以及在安防、自动驾驶、智慧医疗等领域的广泛应用,而有了深刻且大幅的发展。但是,当前深度视频分析仍然极度依赖大型带标签的训练数据集进行模型训练和检测。在进行对模型效果检测的时候,我们常假定我们的测试集的数据分布与我们训练集的数据分布是高度相似甚至是一致的。

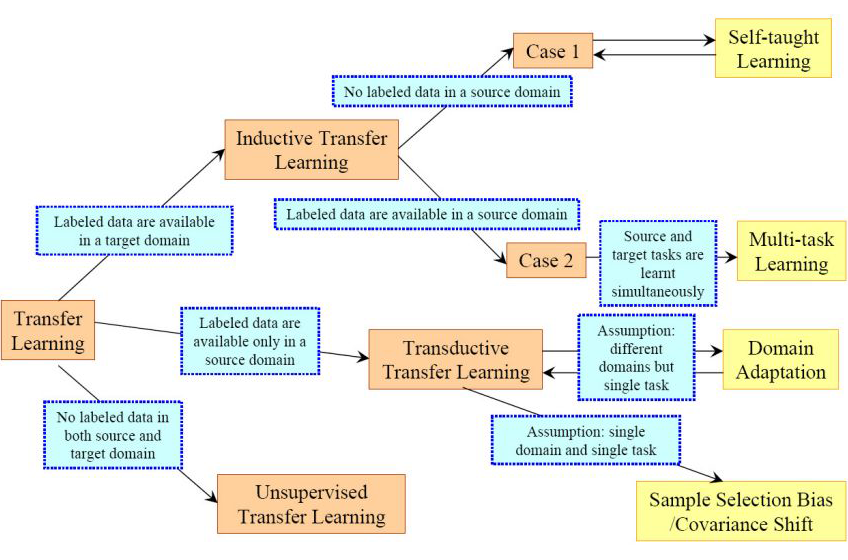

然而这种假定在实际模型应用中往往并不成立。从大型数据集组建的训练集(或源域)与从实际生产生活数据中组建的测试集(或目标域)往往有着不可忽略的差异(即域分布差异)。域分布差异导致在源域训练的模型在目标域上的表现差强人意,进而无法被运用到实际数据和实际场景中。为了解决由于域分布差异带来的对模型表现的负面影响,深度域适应任务被提出。

其旨在通过一定的方法找到源域与目标域之间的相似之处,降低源域与目标域之间的域分布差异,实现域间分布对齐,从而使一个在源域上训练的深度模型能被更好的运用在目标域上,或者说能使一个深度模型将其在源域中获取的只是迁移并运用在目标域中,增强模型的可迁移性及泛化能力。同时,由于数据标注极耗人力与物力,在实际应用中往往能获取的更多是无标签的数据。所以,我们在这里更多讨论的是当目标域是无标签的情况,即深度无监督域适应任务。

当前,对深度无监督域适应任务的研究已经在图像领域有着诸多成果,并仍然是当前的热门研究课题之一。但是对于深度视频无监督域适应任务的研究却少得多。究其原因,可以归结为视频所蕴含的信息非常繁杂,既包括每一帧的静态空间信息,也包括了横跨数帧甚至贯穿整个视频的动态动作信息。除此之外,视频也还包括各种模态的信息,比如环境声、人物语言等等。在带来更多信息的同时,每一类信息亦会导致更严重的域分布差异。

也正因为域分布差异会产生于包括静态空间信息的各种模态的信息,当前的各种仅针对空间信息域分布差异而设计的域适应方案无法被有效的直接应用于解决视频的域分布差异问题,也就无法被用于深度视频无监督域适应。我们针对深度视频无监督适应进行了深入的研究,并提出了全新的方案与全新的数据集,希望能进一步推动深度视频无监督域适应任务的发展。在本文中我们会对这个方案以及我们所提出的数据集进行介绍

与此同时,最基础的深度视频无监督域适应任务设定中对域适应的场景做出了诸多假定和限制,比如限制源域与目标域的标签必须是一致的(或者说在同一个标签空间下)。这些假定和限制可能与日常生产与生活应用不符,大大降低了所提出的域适应方案的实用性。

为此,我们也对深度视频无监督域适应中各种更实用的场景进行了研究。这些更实用的场景都对原有的最基础的设定进行了修改和松绑, 使其更符合现实应用的可能情况,提高了所提出的域适应方案的实用性。在本文中我们会对我们所研究的各类更实用设定下深度视频无监督域适应任务及其所对应的数据集进行介绍 [2][3]

另外,当前深度视频无监督域适应任务大多以动作识别作为下游任务。本文中所介绍的方法也都以动作识别作为下游任务以判断深度视频无监督域适应方案的效果。需要指出的是目前也有研究基于其他视频下游任务比如视频目标检测和语义分割。我们在对深度视频域适应的综述及其对应的汇总库(见下面链接)进行了介绍,欢迎大家查阅。

论文标题:

Video Unsupervised Domain Adaptation with Deep Learning: A Comprehensive Survey

https://arxiv.org/abs/2211.10412

https://github.com/xuyu0010/awesome-video-domain-adaptation

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢