在ICML 2023 Call For Papers 的Ethics部分一开始就是这样的段落:

Authors and members of the program committee, including reviewers, are expected to follow standard ethical guidelines. Plagiarism in any form is strictly forbidden as is unethical use of privileged information by reviewers, ACs, and SACs, such as sharing this information or using it for any other purpose than the reviewing process. Papers that include text generated from a large-scale language model (LLM) such as ChatGPT are prohibited unless these produced text is presented as a part of the paper’s experimental analysis. All suspected unethical behaviors will be investigated by an ethics board and individuals found violating the rules may face sanctions. This year, we will collect names of individuals that have been found to have violated these standards; if individuals representing conferences, journals, or other organizations request this list for decision making purposes, we may make this information available to them. Details of this guideline will be published on the website.

翻译(基于Google Translate+人肉修订):

程序委员会的作者和成员,包括审稿人,都应遵守标准的道德准则。严禁任何形式的剽窃,严禁审稿人、AC 和 SAC 以不道德的方式使用特权信息,例如共享此信息或将其用于审稿过程以外的任何其他目的。禁止论文包含从语言大模型 (LLM)(例如 ChatGPT)生成的文本,除非这些生成的文本作为论文实验分析的一部分呈现。所有涉嫌不道德的行为都将由道德委员会进行调查,被发现违反规则的个人可能会受到制裁。今年,我们将收集被发现违反这些标准的个人姓名; 如果代表会议、期刊或其他组织的个人出于决策目的要求此列表,我们可能会向他们提供此信息。本指南的详细信息将在网站上公布。

这一与时俱进的规定,在Twitter上引发热议。

NLP领域知名的学者、巴伊兰大学教授 Yoav Goldberg 截图转发,对这种看门人性质的条款表示认可。

而AI伦理专家Margaret Mitchell(之前在Google,现在Hugging Face)的看法不同:

If the language model is also included as an **author** then it should be fair game. Without that, using an LLM is a form of plagiarism: write the work you take credit for and don't take credit for work you don't write.如果语言模型也作为**作者**包含在内,才是公平的游戏。否则,使用大模型就是一种剽窃形式:你写论文获得承认,不是你写的,就不应该为此获得承认。

Yoav Goldberg对此回应:

it is not an author, its a tool.

它(大模型)不是作者,只是工具。

Mitchell回应:

You sound confident but you are incorrect if you're implying it's not a tool composed of authored content by authors.

(她的意思是,大模型其实是基于其他作者的作品生成内容的,不是单纯的工具)

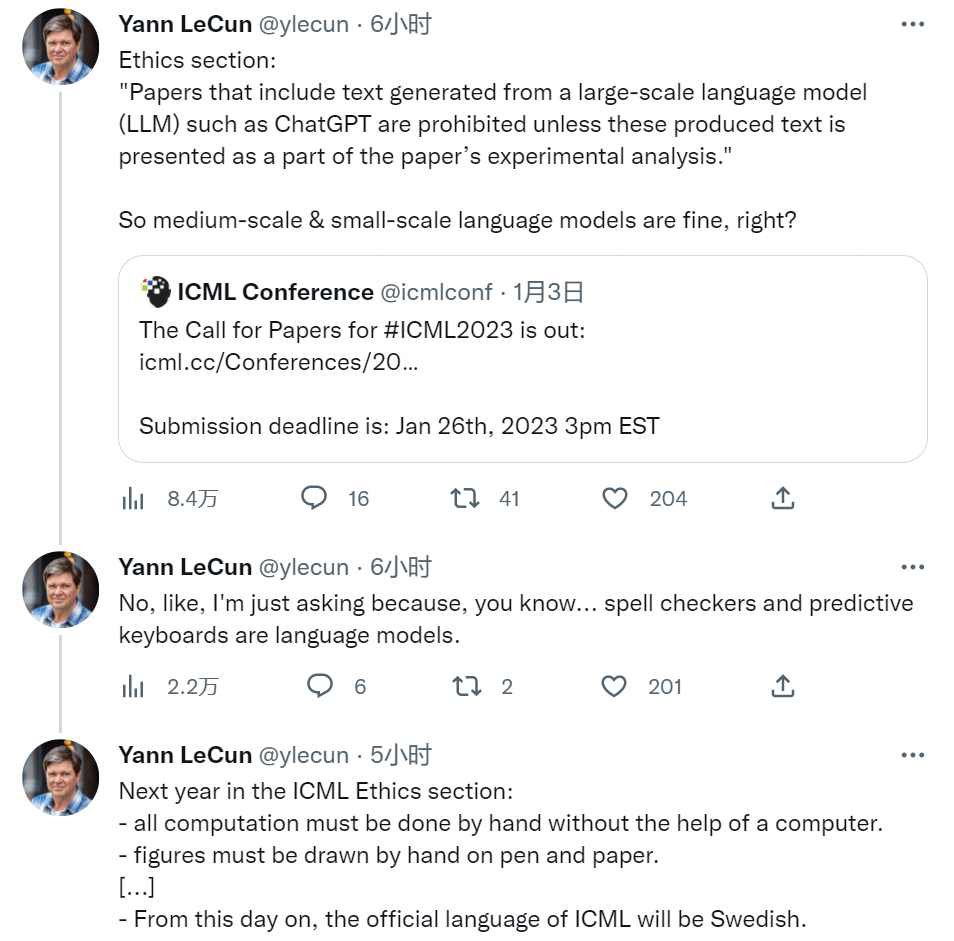

在Twitter上非常活跃的Yann Lecun当然也不会错过这一热点话题,他连发了三条:

很有意思的归谬法:大模型不行,那中小模型就行咯?不是这意思,那拼写检查软件和有预测功能的键盘也是语言模型哦……然后,明年投稿指南会变成这样:

- 所有计算都必须在没有计算机帮助的情况下手工完成。

- 图形必须用笔和纸手绘。 [...]

- 从今天起,ICML 的官方语言将是瑞典语。

在这之前,有学生在利用ChatGPT代写论文,弗曼大学哲学助理教授 Darren Hick 在 Facebook 上发布了如何找到作弊学生的过程,结果该学生这门挂科了这个课程。但目前还没有任何有关这类事件的处理标准。

目前检查是否为ChatGPT生成同团队开发了 GPT 检测器https://huggingface.co/openai-detector/它使用与 ChatGPT 生成响应相同的方法来分析文本,可以计算文本是由 GPT 技术生成的可能性。

大家对此怎么看?欢迎评论。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢