论文标题:Understanding Ensemble, Knowledge Distillation and Self-Distillation in Deep Learning

论文链接:https://openreview.net/forum?id=Uuf2q9TfXGA

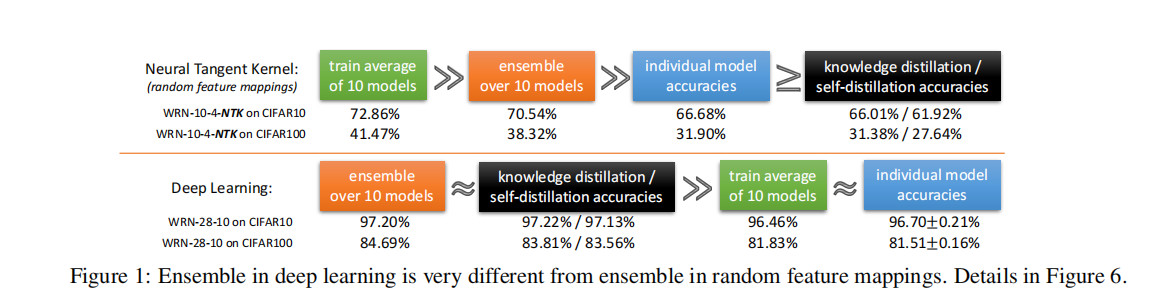

我们正式研究了深度学习模型的集成如何提高测试精度,以及如何使用知识蒸馏将集成的卓越性能提炼到单个模型中。 我们考虑具有挑战性的情况,其中集成只是几个独立训练的神经网络的输出的平均值,这些神经网络具有相同的架构,使用相同的算法在相同的数据集上进行训练,并且它们仅在使用的随机种子上有所不同 初始化。 我们表明,深度学习中的集成/知识蒸馏与传统学习理论(例如提升或 NTK)的工作方式非常不同。 我们开发了一种理论,表明当数据具有我们称为“多视图”的结构时,独立训练的神经网络的集合可以证明可以提高测试准确性,并且这种卓越的测试准确性也可以证明被提炼到单个模型中 . 我们的结果揭示了集成如何以一种完全不同于传统定理的方式在深度学习中工作,以及“暗知识”如何隐藏在集成的输出中并可用于蒸馏。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢