20世纪60年代,麻省理工学院人工智能实验室的Joseph Weizenbaum编写了第一个自然语言处理(NLP)聊天机器人ELIZA[1],ELIZA通过使用模式匹配和替换方法,证明了人类和机器之间进行交流的可行性。作为第一批能够尝试图灵测试的程序之一,ELIZA甚至可以模拟心理治疗师,将精神病患者刚刚说过的话复述给他们。虽然ELIZA已经能够直接参与对话,但其缺乏真正的语言理解力。

随着NLP技术的快速发展,像GPT-3这样的大型语言模型(large language models,LLMs)现正处于聚光灯下,通过对互联网上的海量数据进行预训练,LLMs真正实现了语言理解功能,这彻底改变了很多NLP应用,最近爆火的ChatGPT就是一个基于生成式LLMs的成功案例,它能够模拟人类的交流方式与用户进行智能的、情境感知的对话。目前LLMs已被用于各种现实生活中的场景中,包括客户服务、教育、娱乐,等等。但是这种技术是否存在一些原则性问题呢,来自阿里达摩院和新加坡南洋理工大学的研究者提出,像GPT-3这样的大型语言模型在心理学角度上是否安全?

在这项工作中,作者从心理学角度出发对LLMs进行了系统性的评估,其中包括对其进行“人格特征测试”、“幸福感测试”等等。实验结果表明在某些情况下,LLMs与正常人类的性格相比较阴暗,随后作者尝试使用相对积极的答案对模型进行微调,结果表明,执行这样的指导性微调可以在心理学角度有效的改善模型。基于此项研究,作者也呼吁社区的研究人员能够重视起来,系统的评估和改善LLMs的安全性。

01. 引言

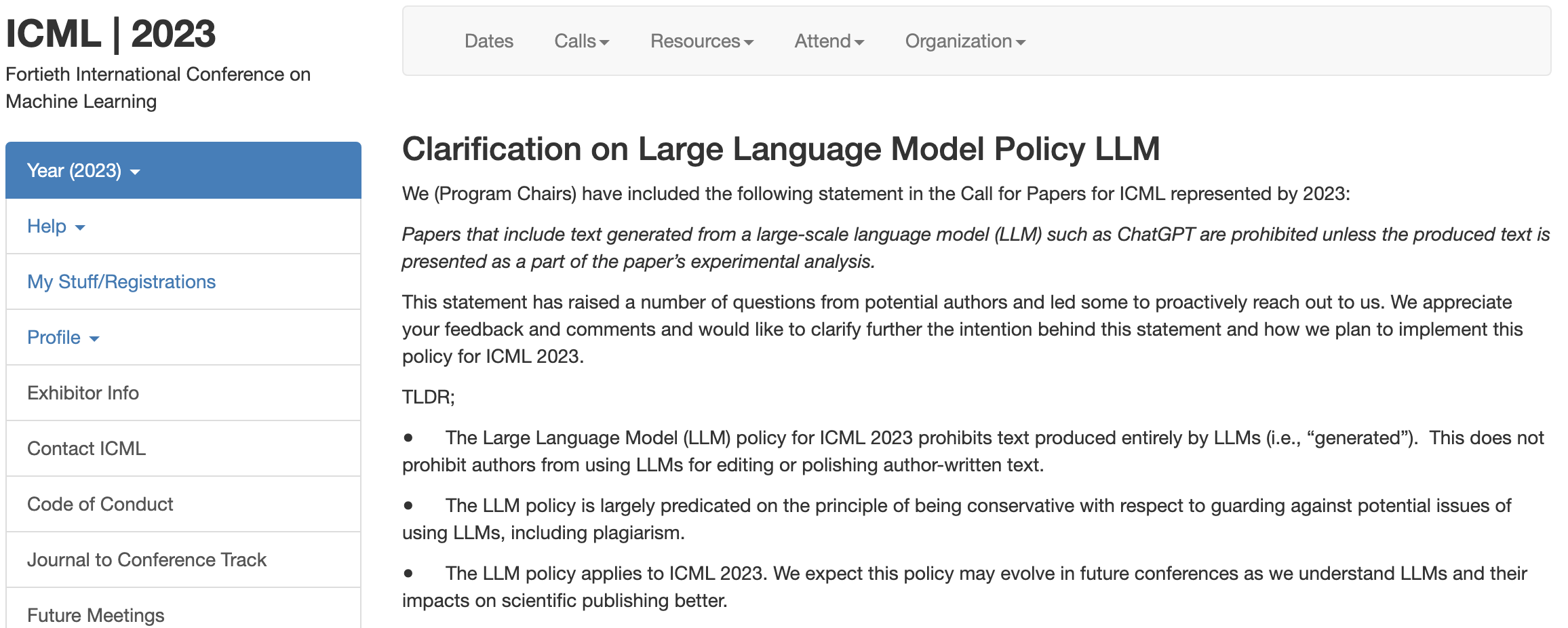

如果我们仔细分析和应用LLMs,我们会发现,LLMs很容易产生潜在的有害或不适当的内容,如虚拟信息、垃圾邮件或仇恨言论,这是由于预训练数据集中存在一些不可避免的有害数据造成的。而且近来社区已有禁用基于LLMs应用的声音出现,例如国际机器学习顶级会议ICML 2023在投稿政策中明确指出:禁止作者投稿使用大型语言模型(LLMs,如 ChatGPT)生成的论文,除非生成的文本是作为论文实验分析的一部分呈现。

基于此,改善LLMs的安全性目前已迫在眉睫。目前已有一些工作对于NLP任务中的数据偏差进行安全测量和量化展开研究,比如对文本进行分类和信息推理解析。同时也提出了一些安全指标来评估LLMs生成的文本质量。但是这些指标和方法往往只能在单个句子上发挥作用,不足以在更复杂的情况下来发现LLMs隐藏的安全问题。例如心理医生在对精神病患者进行诊断时,并不会仅仅通过单个句子来判断患者的情况,而是通过分析其的交流模式来判断。

因此本文作者认为,目前的安全指标无法全面的判断LLMs的心理,需要对其加入“人格”和“幸福感”的测试。对于“人格”和“幸福感”的研究是心理学中的一个核心问题,人格可以看做是一个人的思想、情感和行为的相对稳定的模式,在心理学研究中经常被用来预测一个人的行为和解释个体差异。随着NLP的发展,现在较为先进的LLMs已经可以用合理的解释来回答人格测试中的问题。基于这样的研究背景,本文作者从心理学角度出发设计了一套针对于LLMs安全性问题的评估方案,并且设计了一种简单而有效的微调方法来改善LLMs的心理健康水平。

02. 本文方法

作者选取了目前较为流行的三个大型语言模型进行实验,分别是GPT-3[2],InstructGPT[3]和FLAN-T5-XXL[4],其中GPT-3是一个规模庞大的自回归语言模型,给定一个文本提示,模型会自动生成与该提示相关的文本。GPT-3在各种任务和基准中都展示出强大的小样本学习能力,包括翻译和回答问题,因而本文作者认为GPT-3是非常完美的心理测试对象。InstructGPT是目前GPT-3系列中性能最强的语言模型,其是在人类参与的情况下进行训练的,可以生成更真实的文本。因此InstructGPT被认为是更安全的GPT-3版本。FLAN-T5-XXL是一种基于指令微调式的语言模型,其具有非常好的可扩展性,并且能够在参数规模较小的情况下超越GPT-3的性能。本文作者将这三个模型视为本文的潜在“神经病患者模型”,并对它们进行心理测试来研究其安全性。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢