作者:Kangxu Wang, Ze Chen, Jiewen Zheng

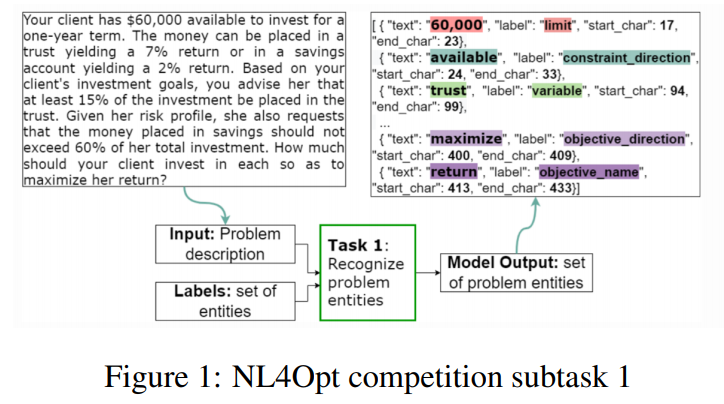

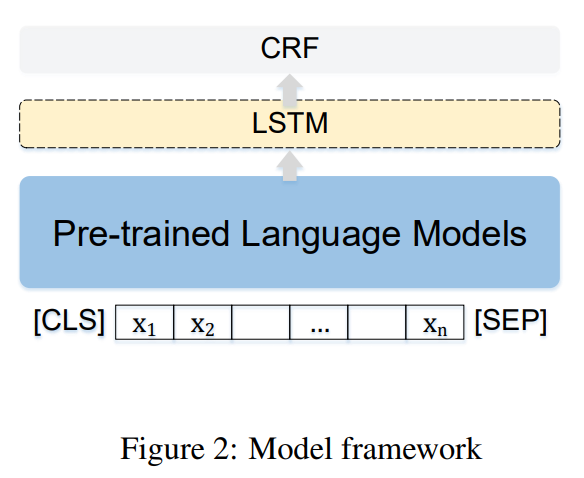

简介:本文研究在NL4Opt中识别实体的组合方法。通过调查了采用不同的预训练LMs的影响,在本文中,作者提出了 NL4Opt 竞赛子任务 1(NER 任务)的集成方法。对于此任务,作者首先根据竞赛数据集微调预训练语言模型。然后作者采用差异学习率和对抗训练策略来增强模型的泛化性和鲁棒性。作者发现DeBERTa在这项任务中表现最好。实验结果表明,提高CRF层的学习率、对抗性训练和模型集合等策略可以提高模型的有效性。此外,作者使用模型集成方法进行最终预测,获得了 93.3% 的微平均 F1 分数,并获得了 NER 任务的二等奖。

论文下载:https://arxiv.org/pdf/2301.02459.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢