来自今天的爱可可爱生活AI前沿推介

[LG] Does compressing activations help model parallel training?

S Bian, D Li, H Wang, E P. Xing, S Venkataraman

[University of Wisconsin-Madison & CMU]

压缩激活是否有助于模型并行训练?

要点:

-

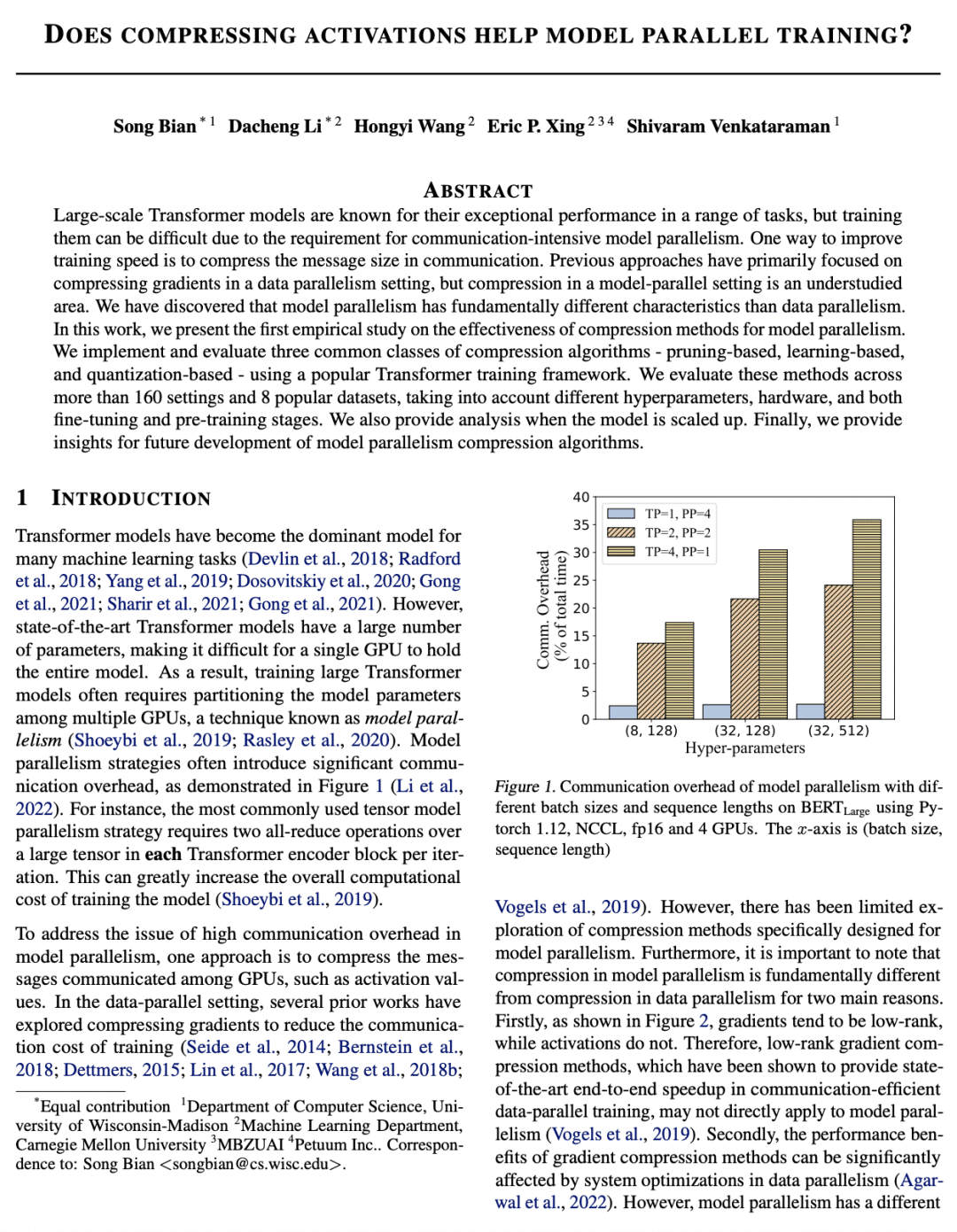

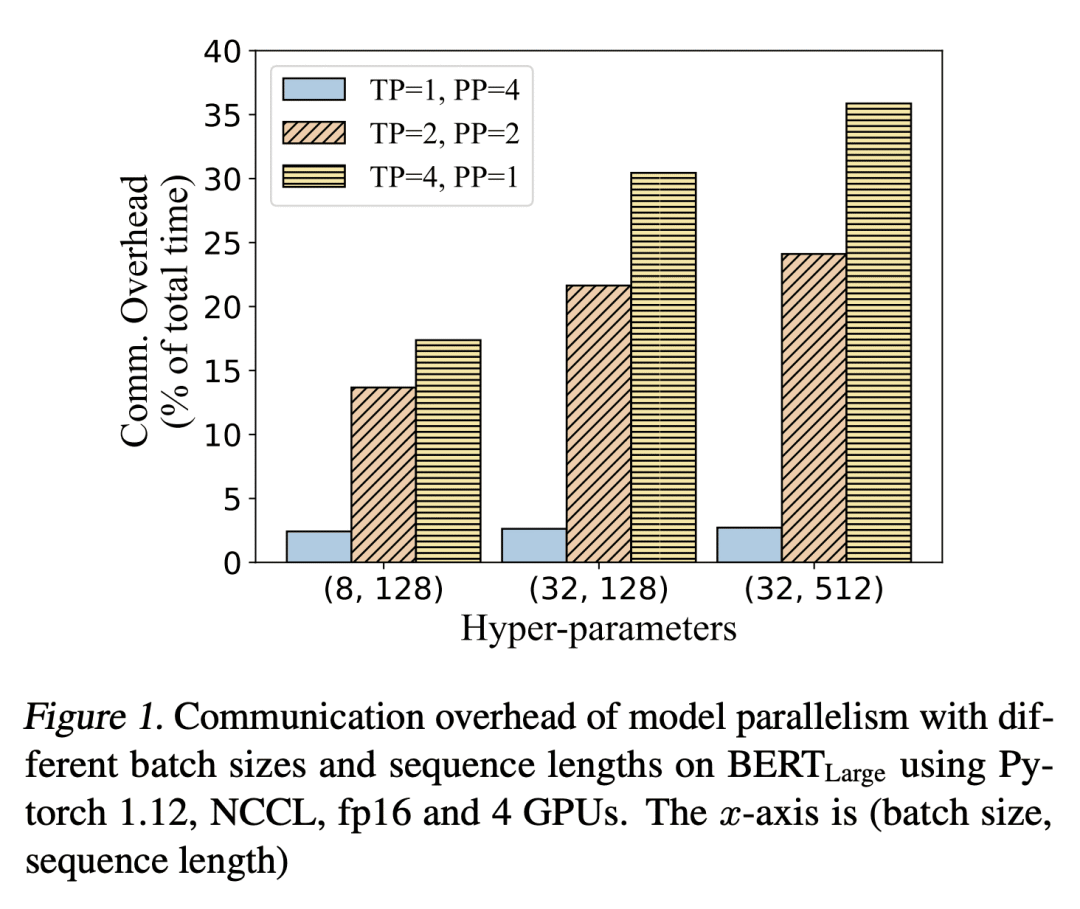

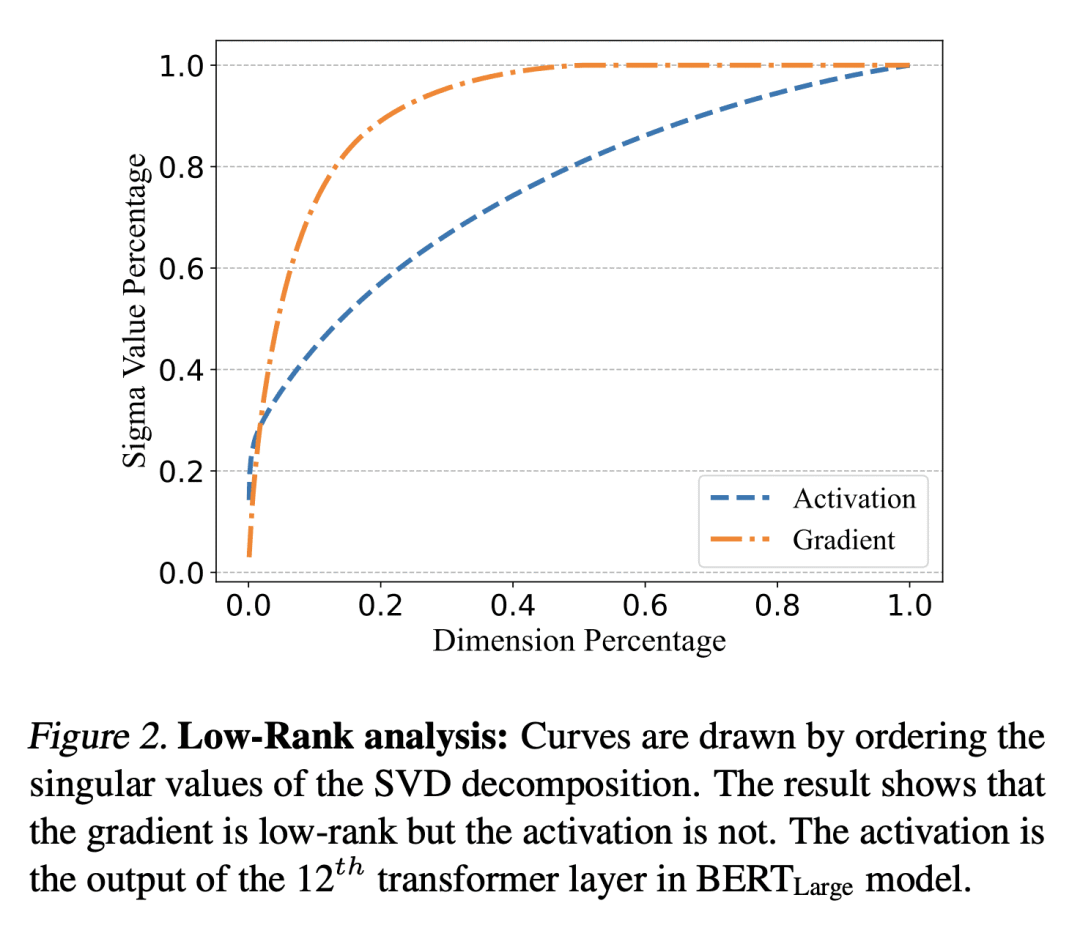

对 Transformer 模型的模型并行压缩方法进行了实证研究; -

实现了几种流行的压缩算法,并集成到现有的分布式训练框架; -

对这些算法在160种不同设置和8个流行数据集中进行广泛评估; -

表明基于学习的压缩算法是对模型并行化的压缩激活来说最有效的方法。

一句话总结:

提出了对 Transformer 模型的模型并行压缩方法的首次实证研究,表明基于学习的压缩算法是对模型并行化的压缩激活来说最有效的方法。

论文链接:https://arxiv.org/abs/2301.02654

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢