来自今天的爱可可AI前沿推介

[CV] Domain Expansion of Image Generators

Y Nitzan, M Gharbi, R Zhang, T Park, J Zhu, D Cohen-Or, E Shechtman

[Adobe Research & Tel-Aviv University & CMU]

图像生成器的域扩展

要点:

-

提出一种新任务——域扩展——来解决如何在保持现有结构和知识的同时,向已训练好的生成模型注入新概念; -

提出一种新方法,通过调整潜空间结构来增加新知识,同时保持原有知识不变; -

提出一种将域自适应方法转化为域扩展方法的简单范式; -

展示了对数百个新域的成功域扩展,说明其优于域自适应方法的优势。

一句话总结:

提出了一个新任务——域扩展——尝试在保持现有结构和知识的前提下,将新概念注入已训练的生成模型。提出一种方法,通过结构化潜空间来扩展模型,使其能够学习新的知识而不破坏原有知识。成功扩展了数百个新域,比传统的领域自适应方法更具优势。

摘要:

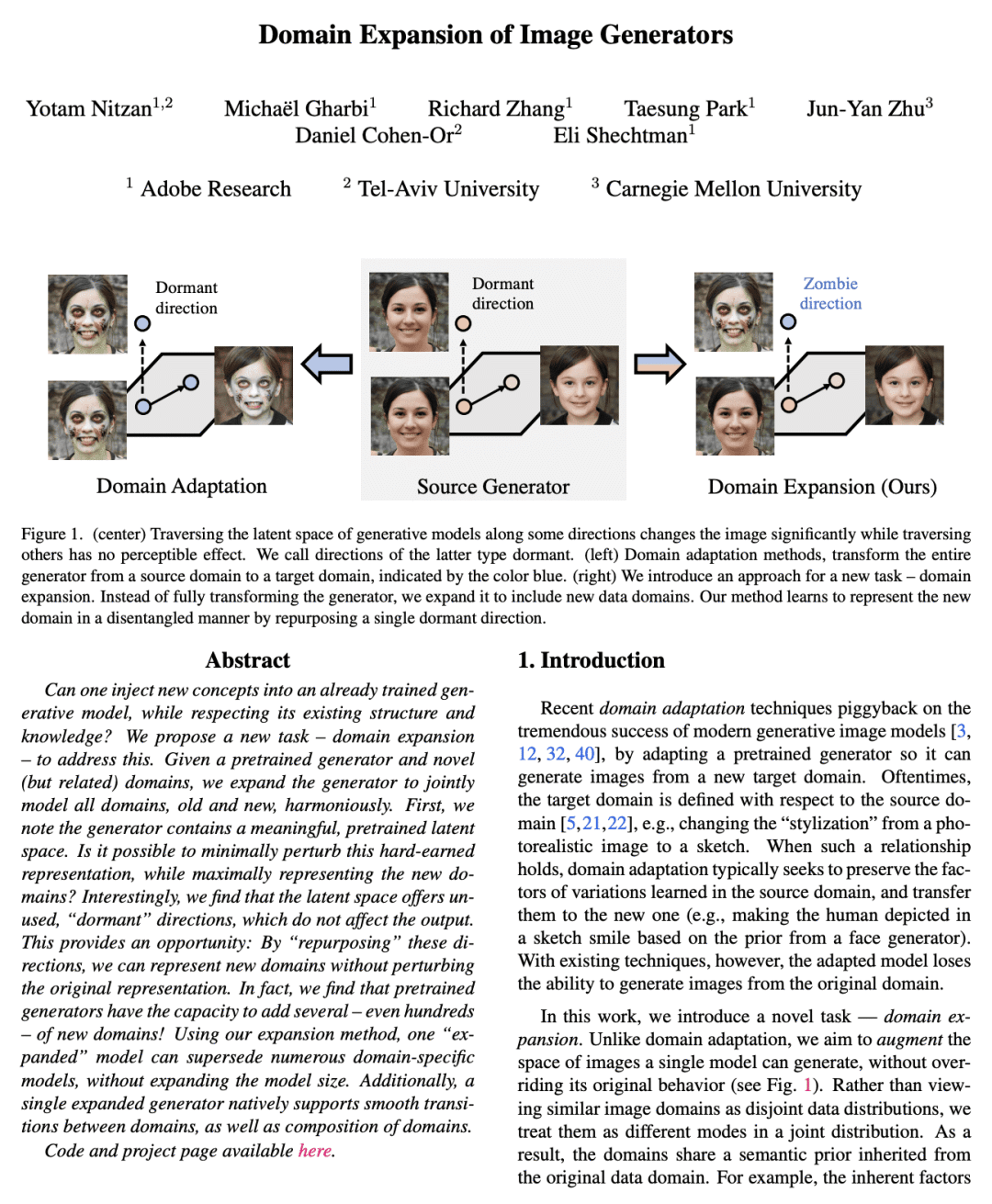

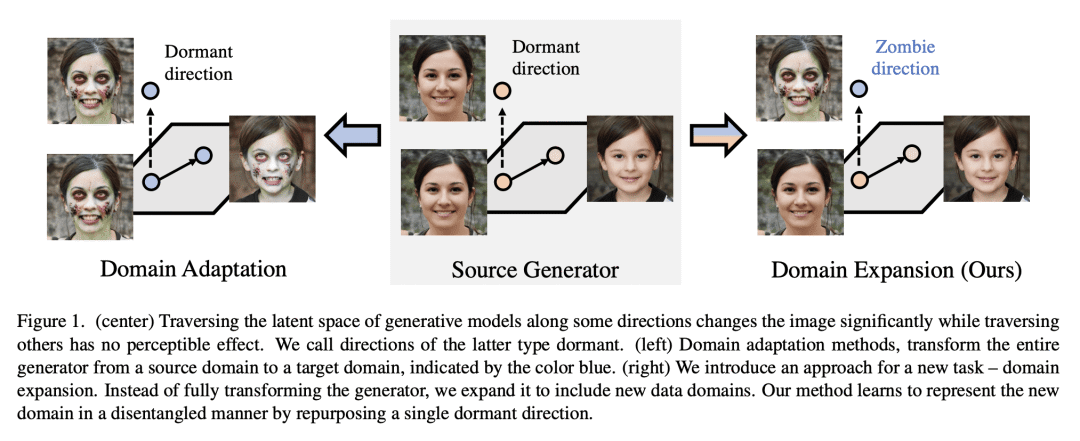

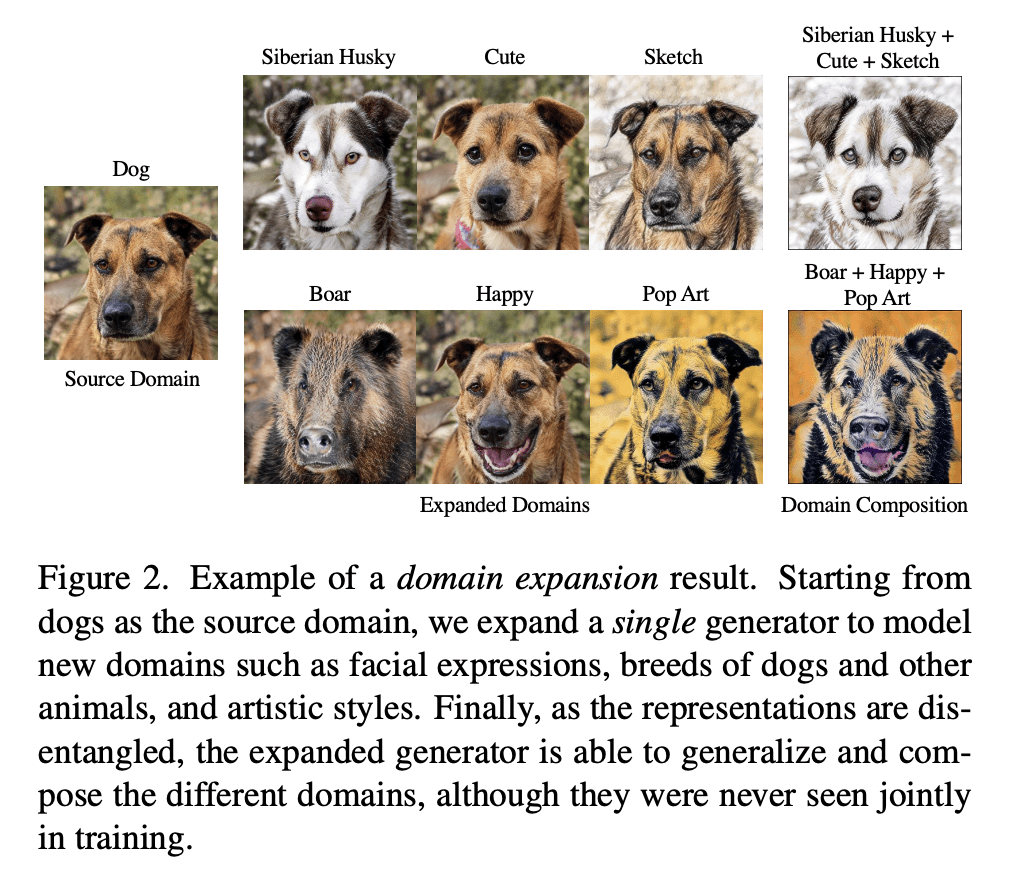

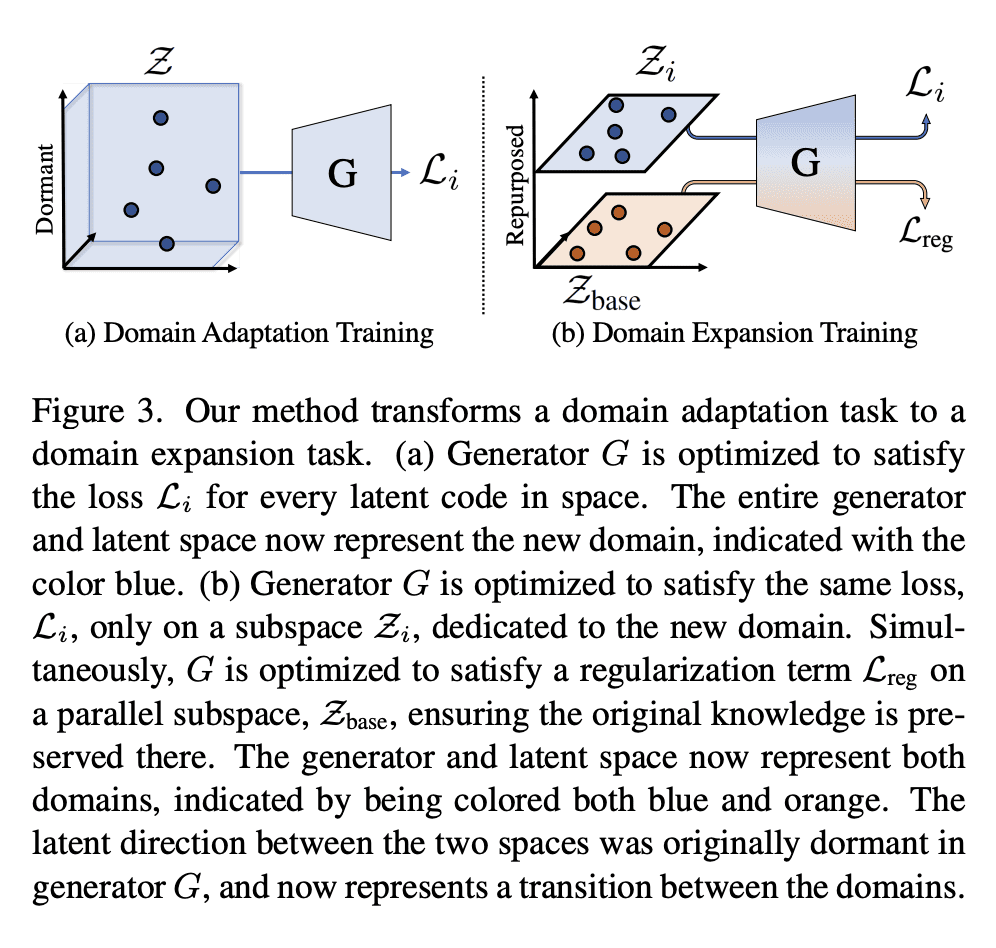

可以在尊重其现有结构和知识的同时,将新概念注入训练好的生成模型中吗?本文提出一项新任务——域扩展——来解决该问题。给定一个预训练的生成器和新(但相关)的域,扩展生成器,以和谐共同建模所有新旧域。本文注意到发生成器包含一个有意义的、经过预训练的潜空间。是否可以最大限度地扰乱这个训练得到的表示,同时最大程度地表示新域?本文发现潜空间提供了未使用的“dormant”方向,其不会影响输出。这提供了一个机会:通过“重新利用”这些方向,就可以在不扰乱原始表示的情况下表示新域。预训练的生成器有能力添加几个甚至数百个新域!使用所提出的扩展方法,一个“扩展”模型可以取代许多特定域模型,而无需扩展模型大小。此外,单个扩展生成器原生支持域之间的平稳过渡以及域的组合。

Can one inject new concepts into an already trained generative model, while respecting its existing structure and knowledge? We propose a new task - domain expansion - to address this. Given a pretrained generator and novel (but related) domains, we expand the generator to jointly model all domains, old and new, harmoniously. First, we note the generator contains a meaningful, pretrained latent space. Is it possible to minimally perturb this hard-earned representation, while maximally representing the new domains? Interestingly, we find that the latent space offers unused, "dormant" directions, which do not affect the output. This provides an opportunity: By "repurposing" these directions, we can represent new domains without perturbing the original representation. In fact, we find that pretrained generators have the capacity to add several - even hundreds - of new domains! Using our expansion method, one "expanded" model can supersede numerous domain-specific models, without expanding the model size. Additionally, a single expanded generator natively supports smooth transitions between domains, as well as composition of domains.

论文链接:https://arxiv.org/abs/2301.05225

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢