【标题】Efficient Exploration in Resource-Restricted Reinforcement Learning

【作者团队】Zhihai Wang, Taoxing Pan, Qi Zhou, Jie Wang

【发表日期】2022.12.14

【论文链接】https://arxiv.org/pdf/2212.06988.pdf

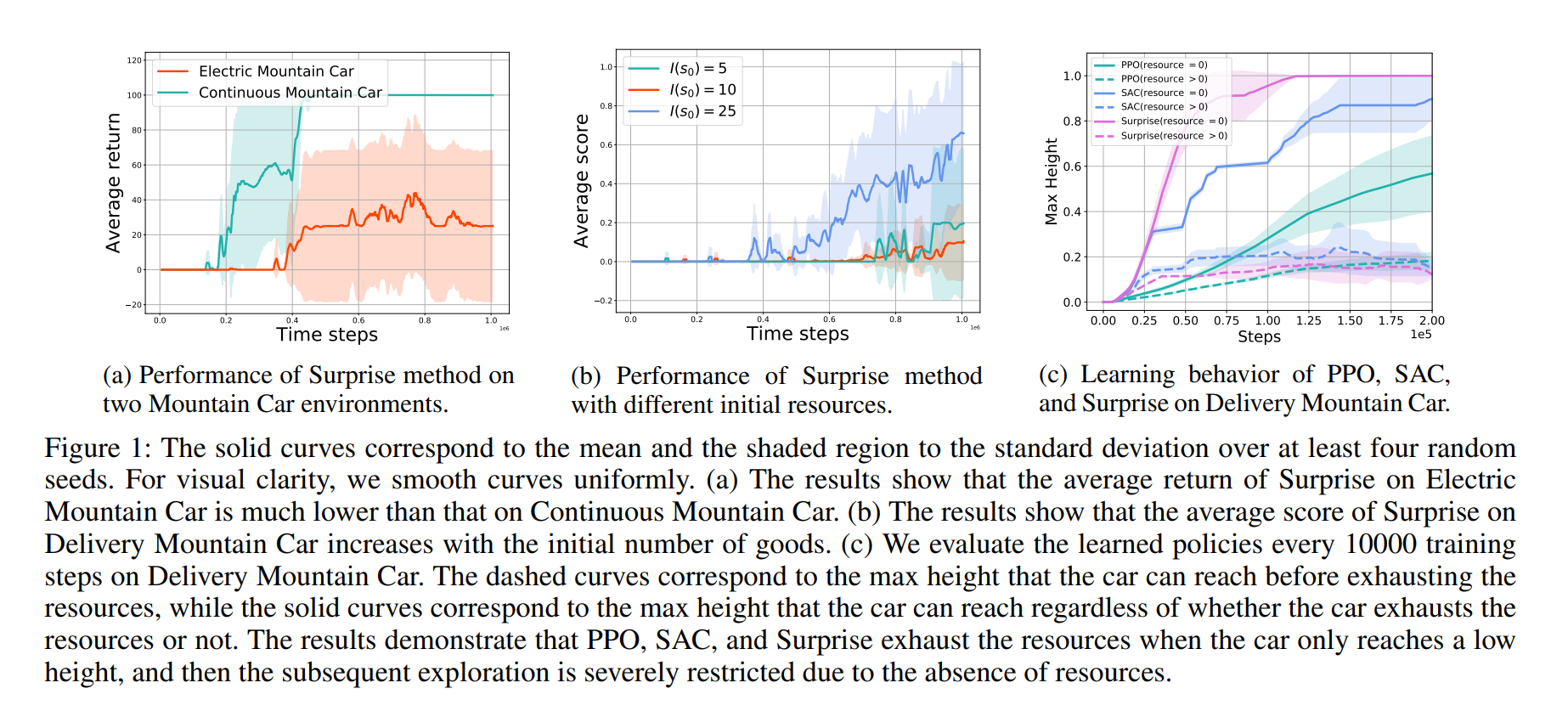

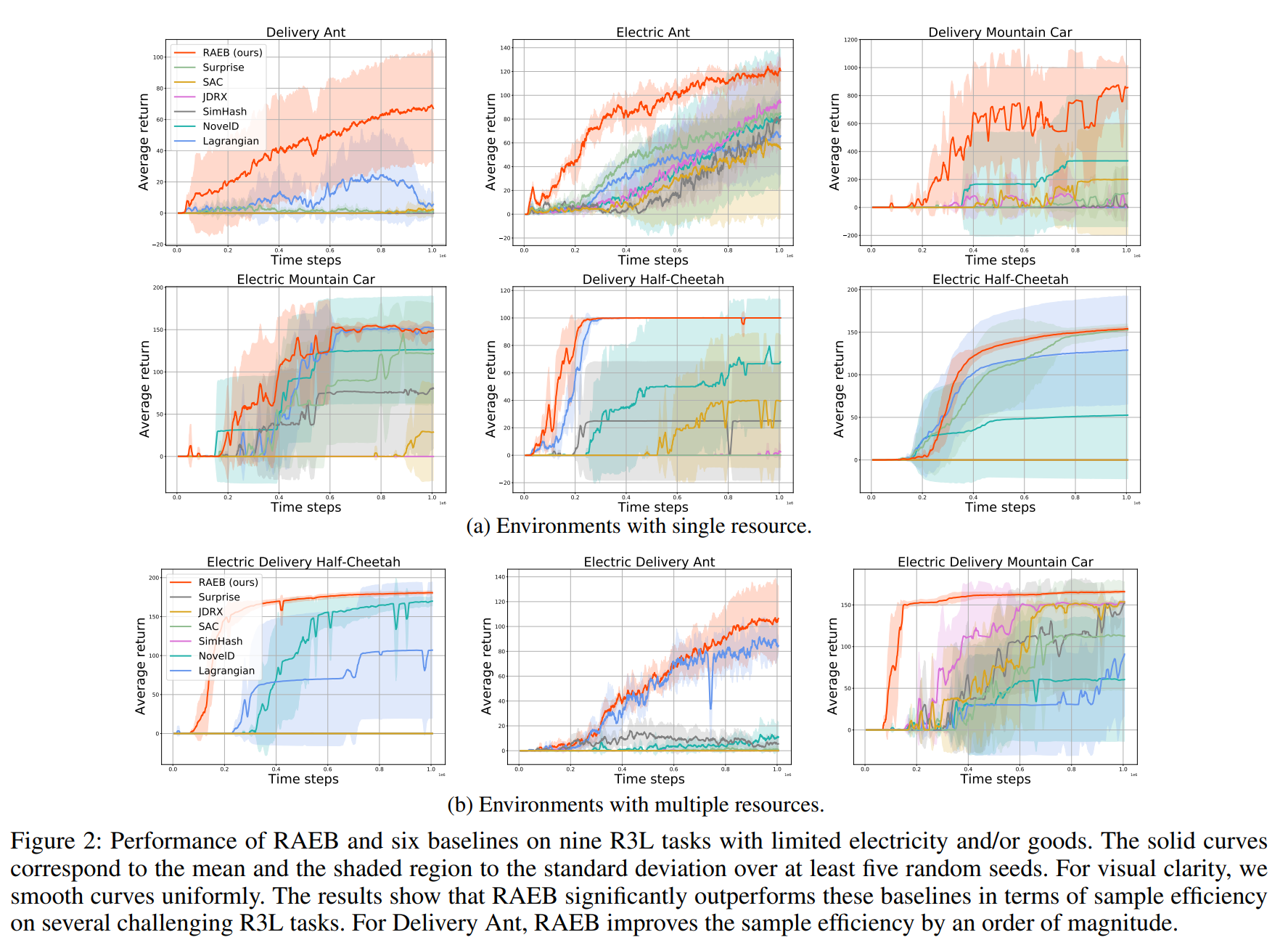

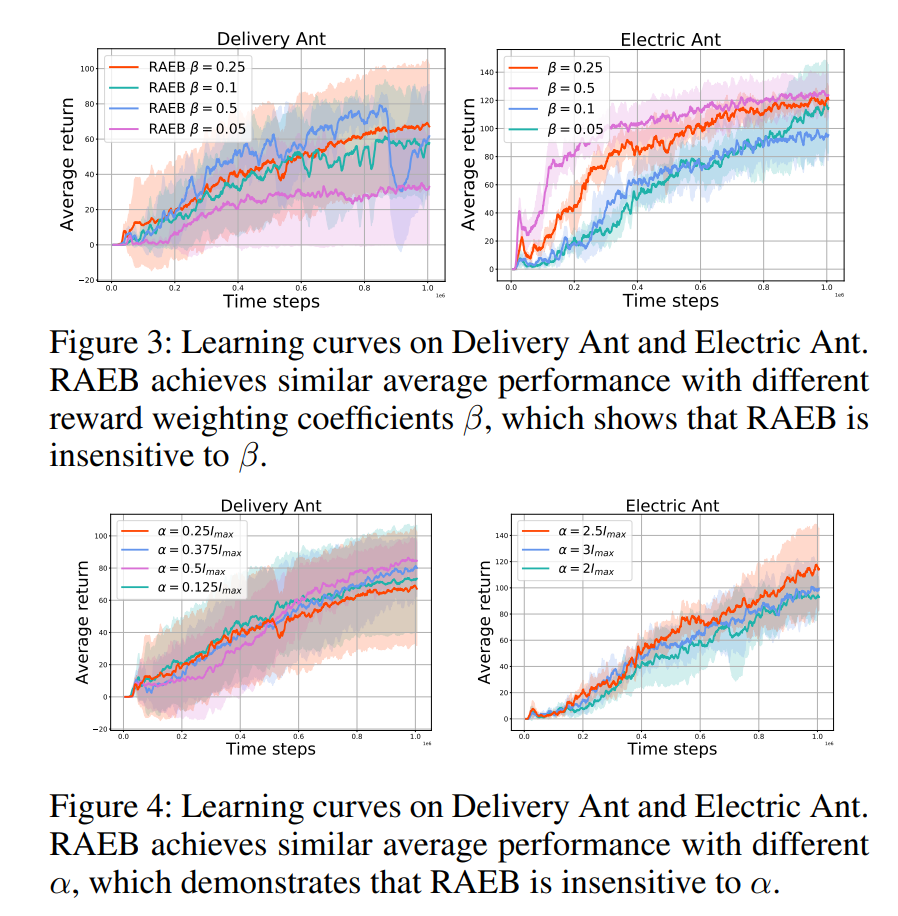

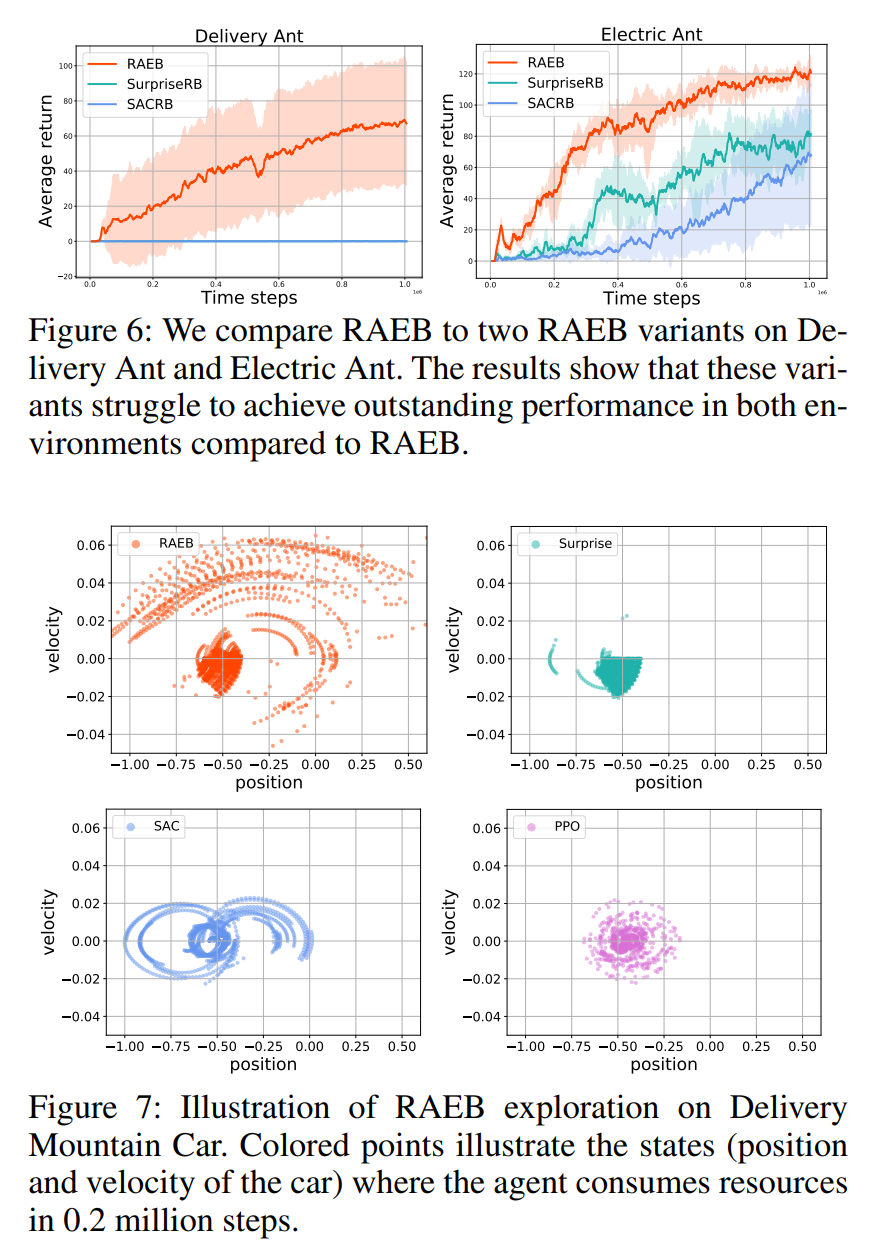

【推荐理由】在强化学习 (RL) 的许多实际应用中,执行动作需要消耗某些类型的资源,这些资源在每一阶段中都无法补充。 典型应用包括能量有限的机器人控制和消耗品的视频游戏。 在具有不可补充资源的任务中,作者观察到流行的 RL 方法(例如 soft actor critic)样本效率低下。 主要原因是,它们往往会很快耗尽资源,因此后续的勘探由于资源的缺乏而受到严重限制。 为了应对这一挑战,本文首先将上述问题形式化为资源受限的强化学习,然后提出一种新的资源感知探索奖励 (RAEB) 以合理利用资源。 RAEB 的一个吸引人的特点是,它可以显着减少不必要的资源消耗试验,同时有效地鼓励智能体探索未访问的状态。 实验表明,所提出的 RAEB 在资源受限的强化学习环境中明显优于最先进的探索策略,将样本效率提高了一个数量级。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢