作者:Mozhgan Talebpour、Alba Garcia Seco de Herrera、Shoaib Jameel

推荐理由:本文被第45届ECIR会议采纳;在过去十年中,主题建模一直是主导的建模范式;主题模型已经被证明可以改善信息检索结果;在当前预训练、大模型的时代背景下,本文聚焦研究语言模型中的哪个组件有助于捕获主题信息。

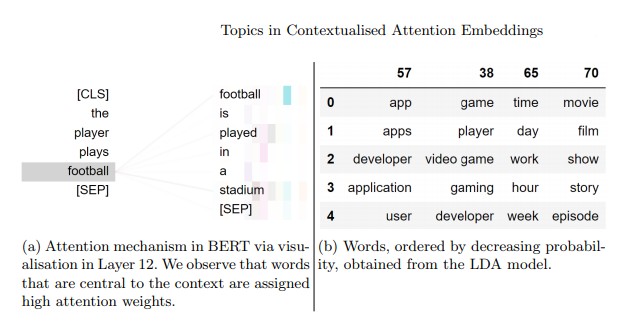

简介:通过预训练的语言模型获得的上下文词向量,编码了已在应用程序中利用的各种知识。这些语言模型的补充是从文本中学习主题模式的概率主题模型。最近的工作表明,对来自语言模型的词级上下文表示进行聚类可以模拟在潜在狄利克雷分配的词的潜在主题中发现的词簇。重要的问题是,当语言模型尚未明确设计为对潜在主题建模时,如何通过聚类在语言模型中自动形成此类主题词集群。为了解决这个问题,作者设计了不同的探测实验。使用 BERT 和 DistilBERT,作者发现注意力框架在建模此类单词主题集群中起着关键作用。作者坚信:作者的工作为进一步研究概率主题模型和预训练语言模型之间的关系铺平了道路。

论文下载:https://arxiv.org/pdf/2301.04339.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢