作者芯片架构师唐杉

这两天正好参与了两个论坛活动,一个关于Chiplet,一个关于稀疏计算。前者是芯片底层技术,后者是AI重要的计算特征,讲完我发现自己的总结中用了非常类似的描述。“___技术给AI系统的优化带来了新的机遇,但___技术的引入并不是免费午餐,可能会对现有的架构和编程模型产生冲击,必须认真权衡其成本(包括直接成本和增加的软硬件设计的efforts)和产出。而这是个复杂的全系统优化问题,需要相应的设计方法学和工具来支持......”

回头一看,作为架构师(tradeoff师)和长期研究设计方法学(“纸上谈兵”)的人,这段文字可能是对于新技术的引入的一个万金油式的说法。这几年的收获可能是,给了编程模型(决定软件生产力)更多的权重。没有变的是,仍然期待大家能重视设计方法学和工具,尽管这种期待也可能只是由于个人关注点造成的错觉,在现在这个大家都很“着急”的环境没什么实际的意义(AI芯片“软硬件协同设计”的理想与实践)。

如果说在AI System领域今年印象最深的事情是什么(除了我们自己的产品发布外),排第一位的应该是Pytorch 2.0的发布,这可能是我关注AI Compiler几年来对于这项技术发展最重要的一个事件。对于AI Compiler来说,Pytorch 2.0设定了一个比较清晰的发挥空间,不多不少(有待观察),可以更聚焦在自己的任务上,绝对是个多赢的事情。这里感慨一下,距离我在18年组织MLIR的学习讨论,已经快5年了,MLIR仍然在路上(“编译器与IR的思考: LLVM IR,SPIR-V到MLIR”)。任何新技术从一个好的想法到真正解决问题,确实需要时间和机遇。Chris Lattner终于自己干了,希望Modular不辜负大家的期待吧。

另一个和AI System密切相关的大事件当然是AI算法的突破,stable diffusion和chatGPT的冲击范围已经完全突破了技术人的圈子,其深度和广度应该不亚于当年的AlphaGo。题图是stalbe diffusion 2模型生成的,光线效果好很多,甚至可以在prompt里面描述“global illumination, volumetric light, radiant light”,而且效果还不错,但控制性变化很大,很多老版本模型上表现很好的prompts都会翻车。chatGPT的表现也不是完美的,我们仍然看到很多令人啼笑皆非的答案。对于这些大模型来说,好用但“不理解”“不受控”的问题仍然没有很好解决。

另一个挑战就是训练和部署的代价。很自然,它们已经成为AI System最关注的场景。在开篇说的两个论坛上,大家已经在讨论如何利用模型的稀疏性(“Transformer加速:稀疏注意力加速器调研”)以及利用Chiplet技术提供的芯片能力来加速这两个模型了。LLM无疑是未来几年AI领域的主题,一个更值得思考的问题则是,LLM是否真能形成one for all能力,如果是的话,是否会出现LLM machine来取代现在的计算机?一个非常高度定制的专用加速器 + 一个非常通用的模型(可以参考,“专用AI芯片的『更高』使命”),来解决效率和通用性这两个矛盾的问题。训练好这个模型之后,实现各种任务不再需要“编程”,只需要问出合适的问题(prompt engineering)(甚至可以设计AI模型)。这个可能就是软件2.0(The end of programming)的概念的终极版本吧。

去年还有一个进步明显的领域,就是RISC-V。香山项目开源项目(【香山双周报】20230109期)在高性能CPU上的努力和进展大家都看得到;Jim Keller在tenstorrent开源的Ocelot: The Berkeley Out-of-Order RISC-V Processor with Vector Support,则展示了RV在AI芯片中作为基础处理器模板的模式。我之前做专用处理器时间比较长,RV出来之前,大家有各自的基础模板,做软件工具和生态有很大挑战,限制了其应用范围。而RV可以说已经是自带软件生态,在其基础上进行定制和扩展,软硬件的工作量要少很多,能玩的领域也就大多了。我在17的文章“自己动手设计专用处理器!”里就谈过的这种玩法。

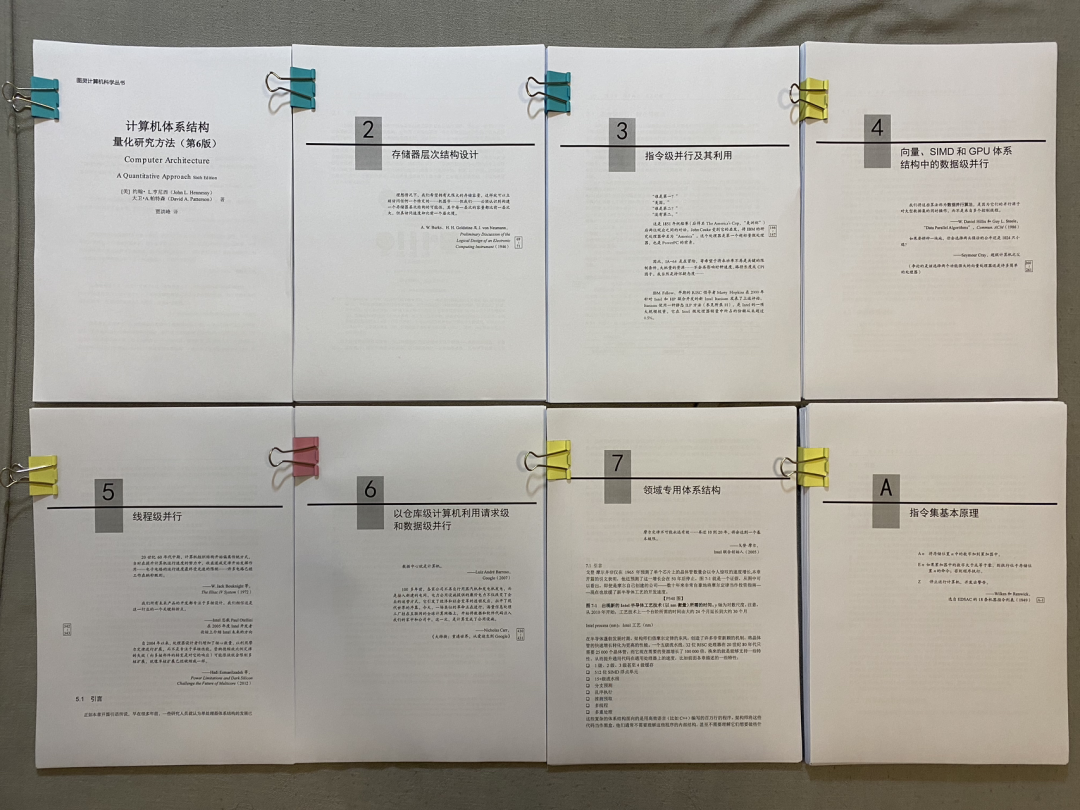

最后一个印象比较深的事情更个人一些,就是体系结构经典书籍《计算机体系结构:量化研究方法(第6版)》中文版的正式出版。我参与这本书的审校还是在21年的春节,也是当时一个人过年的主要娱乐活动。当时保留的这张照片,是不是有点《编舟记》的感觉。

去年翻译了一下《计算机体系结构发展史》,这一系列文章,算是去年对经典的致敬,适合假日阅读。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢