作者:Malte Ostendorff, Georg Rehm

推荐理由:在跨语言预训练领域,本文提出一种新的渐进式迁移学习方法,以高效地(训练工作量减少了50%以上)训练大型语言模型。

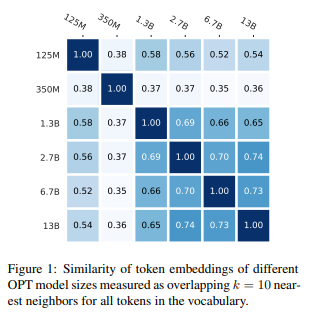

简介:大多数 Transformer 语言模型主要针对英文文本进行预训练,限制了它们对其他语言的使用。随着模型规模的增长,英语与其他计算和数据资源较少的语言之间的性能差距进一步扩大。因此,需要更节省资源的训练方法来弥补可用资源较少的语言的差距。为了解决这个问题,作者提出了一种称为 CLP-Transfer 的跨语言和渐进式迁移学习方法:该方法将模型从源语言迁移到新的目标语言,其中预训练模型是公开可用的(例如英语)。与之前专注于两种语言之间的跨语言迁移的工作相反,作者将迁移扩展到模型大小。给定一个源语言的预训练模型,作者的目标是在目标语言中使用相同大小的模型。作者不是从头开始训练模型,而是利用目标语言中的较小模型,但需要的资源少得多。然后根据源语言和目标语言的重叠词汇,使用小型模型和源模型来初始化较大模型的标记嵌入。所有剩余的权重都从源语言的模型中重用。这种方法优于单一的跨语言迁移,与随机初始化相比,可以节省高达 80% 的训练步骤。CLP Transfer只需要原始令牌计数的50%(GPT-2)甚至20%(BLOOM);这相当于训练工作量减少了50%或80%。这种减少,降低了在低资源环境中训练大型语言模型的障碍!

论文下载:https://arxiv.org/pdf/2301.09626.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢