论文标题:A Survey on Efficient Training of Transformers

论文链接:https://arxiv.org/abs/2302.01107

作者单位:蒙纳士大学

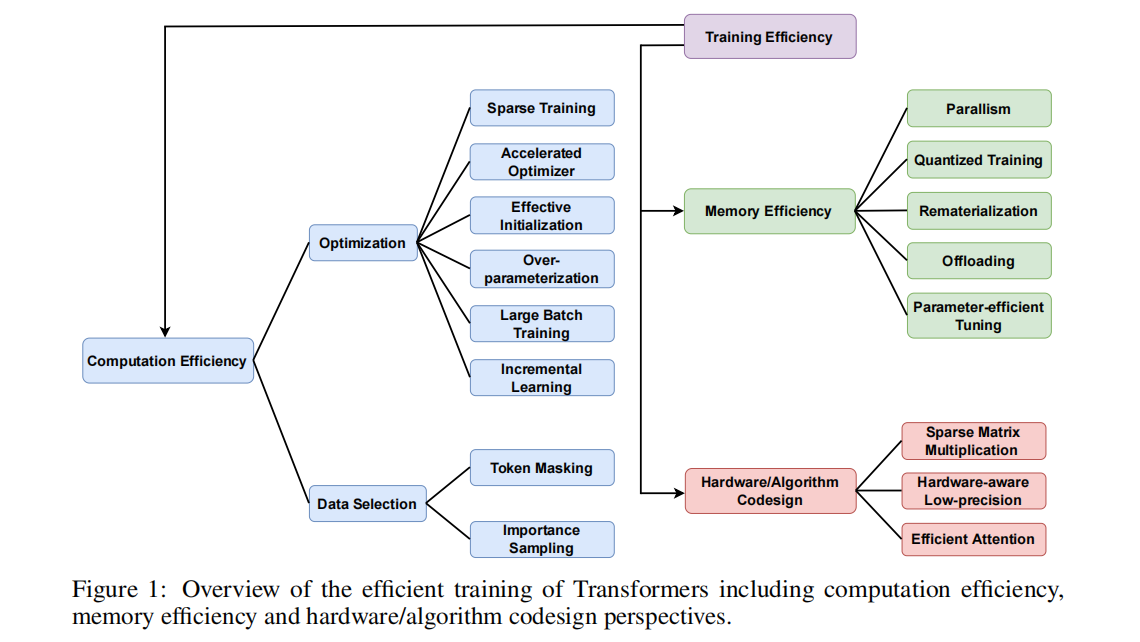

Transformers 的最新进展伴随着对计算资源的巨大需求,凸显了开发高效训练技术的重要性,以便通过有效利用计算和内存资源,使 Transformer 训练更快、成本更低、准确度更高。 本综述首次系统概述了 Transformer 的高效训练,涵盖了加速算法和硬件方面的最新进展,重点是前者。 我们分析和比较了在训练期间为中间张量节省计算和内存成本的方法,以及硬件/算法协同设计技术。 我们最后讨论了未来研究的挑战和有前景的领域。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢