本文来自爱可可的推荐

推荐理由:可以通过自我训练来调用各种工具,比如比如计算器、数据库查询、搜索引擎等。

Toolformer: Language Models Can Teach Themselves to Use Tools

T Schick, J Dwivedi-Yu, R Dessì, R Raileanu, M Lomeli, L Zettlemoyer, N Cancedda, T Scialom

[Meta AI Research]

论文地址:https://arxiv.org/abs/2302.04761

Toolformer是一个自监督的语言模型,在不牺牲其语言建模能力的情况下提高其在下游任务中的表现。

要点:

-

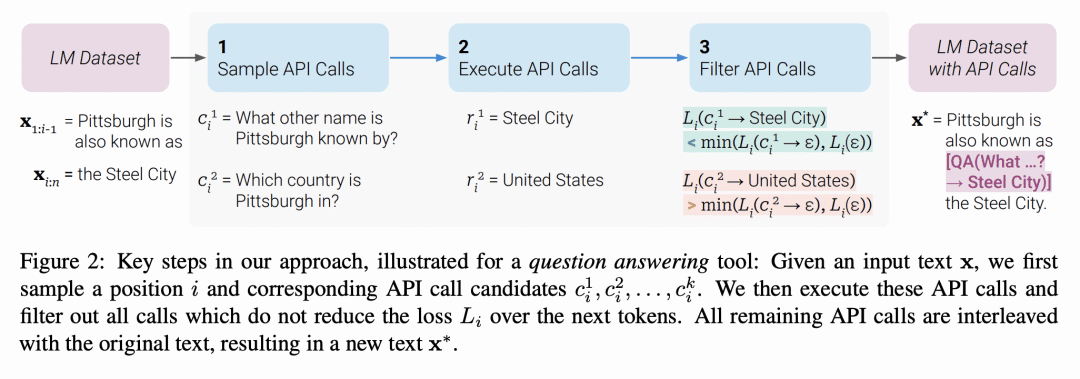

提出一种叫做 Toolformer 的新语言模型,可以通过简单的 API 以自监督方式学习使用外部工具; -

Toolformer 在各种下游任务中提高了零样本性能,可以与较大的模型竞争,而不牺牲其核心语言建模能力; -

展示了 Toolformer 可以学习使用一系列的工具,包括一个计算器、一个问答系统、两个不同的搜索引擎、一个翻译系统和一个日历。

语言模型(LM)在解决新任务方面表现出非凡的能力,特别是在规模以上。矛盾的是,它们在基本功能方面很吃力,比如算术或事实查询,而在这些方面,更简单、更小的模型却很出色。本文展示了 LM 可以通过简单的 API 教自己使用外部工具,并实现两个世界的最佳效果。本文提出 Toolformer,一种经过训练的模型,可以决定调用哪些 API,何时调用,传递哪些参数,以及如何将结果最好地纳入未来的标记预测中,以一种自监督方式完成,只需要对每个 API 进行少量的演示即可。本文结合了一系列的工具,包括一个计算器、一个Q/A系统、两个不同的搜索引擎、一个翻译系统和一个日历。Toolformer在各种下游任务中实现了大幅提高的零样本性能,通常与更大的模型竞争,而不牺牲其核心语言建模能力。

Language models (LMs) exhibit remarkable abilities to solve new tasks from just a few examples or textual instructions, especially at scale. They also, paradoxically, struggle with basic functionality, such as arithmetic or factual lookup, where much simpler and smaller models excel. In this paper, we show that LMs can teach themselves to use external tools via simple APIs and achieve the best of both worlds. We introduce Toolformer, a model trained to decide which APIs to call, when to call them, what arguments to pass, and how to best incorporate the results into future token prediction. This is done in a self-supervised way, requiring nothing more than a handful of demonstrations for each API. We incorporate a range of tools, including a calculator, a Q&A system, two different search engines, a translation system, and a calendar. Toolformer achieves substantially improved zero-shot performance across a variety of downstream tasks, often competitive with much larger models, without sacrificing its core language modeling abilities.

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢