三个新兴领域是:

- 数据危机,需要自己生成训练数据来改进和思考。

- 可以自己去查检事实。

- 大规模稀疏专家模型。

作者Rob Toews是Radical Ventures公司的风险投资人,他在文中针对当下语言模型存在的问题,指出了「下一代语言模型」的三个发展方向,并给出了一些科技巨头们正在探索的前沿工作。

Yann LeCun转发了此文章,并表示:现在的大模型搜索永远不会取代谷歌搜索,认为今天的大模型是虚构的。

本文重点介绍了三个新兴领域,这些领域将有助于定义下一代人工智能和大模型创新浪潮。对于那些希望在这个快速变化的世界中保持领先地位的人来说,请继续阅读。

1)可以生成自己的训练数据来提高自己的水平。

考虑人类如何思考和学习。我们从外部信息来源收集知识和观点——例如,通过阅读一本书。但我们也会自己产生新颖的想法和见解,通过反思一个话题或思考我们脑海中的问题。我们能够通过与任何新的外部投入没有直接联系的内部反思和分析来加深我们对世界的理解。人工智能研究的新途径旨在使大型语言模型能够做一些类似的事情,有效地引导自己的智力。今天的大模型摄入了世界上积累的大部分书面信息(例如维基百科、书籍、新闻文章)。如果这些模型一旦经过训练,可以利用他们从这些来源吸收的所有知识来制作新的书面内容,然后将这些内容用作额外的训练数据,以提高自己。

初步工作表明,这种方法可能是可能的,而且是强大的。在最近一项名为“大型语言模型可以自我完善”的研究中,一群谷歌研究人员建立了一个法学硕士,可以提出一组问题,生成这些问题的详细答案,过滤自己的答案以获得最高质量的输出,然后根据精选的答案进行微调。值得注意的是,这导致了各种语言任务的新最先进的性能。例如,该模型在GSM8K上的性能从74.2%上升到82.1%,在DROP上从78.2%上升到83.0%,这是用于评估大模型性能的两个流行基准。最近的另一项工作基于一种名为“指令微调”的重要法学硕士方法,该方法位于ChatGPT等产品的核心。ChatGPT和其他指令微调模型依赖于人工编写指令,但该研究小组构建了一个模型,可以生成自己的自然语言指令,然后根据这些指令进行微调。性能收益是戏剧性的:这种方法将基本GPT-3模型的性能提高了33%,几乎与OpenAI自己的指令调优模型的性能相匹配。

在一项与主题相关的工作中,谷歌和卡内基梅隆大学的研究人员表明,如果一个大语言模型在提出问题时,在回答之前首先背诵对主题的了解,它会提供更准确、更复杂的回答。这可以大致类比为一个人在对话中,他不是脱口而出一个话题想到的第一件事,而是在分享观点之前搜索她的记忆并反思她的信仰。

当人们第一次听到这一研究时,经常会出现概念上的反对意见——这不都是循环的吗?模型如何生成数据,然后模型可以消耗这些数据来改进自己?如果新数据首先来自模型,那么它包含的“知识”或“信号”不应该已经包含在模型中吗?如果我们将大型语言模型视为数据库,存储其训练数据中的信息,并在提示时以不同的组合重现,那么这种反对是有道理的。但是——尽管听起来很不舒服,甚至很怪异——我们最好按照人类大脑的思路构思大型语言模型(不,这个类比当然不完美!)。

我们人类摄取来自世界的大量数据,这些数据以不可思议、无数的方式改变了我们大脑中的神经连接。通过内省、写作、对话——有时只是一觉好觉——然后我们的大脑可以产生以前从未出现在我们脑海中或世界上任何信息来源的新见解。如果我们将这些新见解内化,它们可以让我们更聪明。

鉴于世界文本训练数据可能很快就会用完,大模型可以生成自己的训练数据的想法尤为重要。这还不是一个广为人知的问题,但这是许多人工智能研究人员担心的问题。据估计,世界可用文本数据的总存量在4.6万亿至17.2万亿代币之间。这包括世界上所有书籍、所有科学论文、所有新闻文章、所有维基百科、所有公开可用的代码以及互联网的大部分内容,这些内容都经过了质量过滤(例如网页、博客、社交媒体)。最近的另一项估计表明,总数字为3.2万亿代币。

我们可能远远没有耗尽世界上所有有用的语言训练数据。如果大型语言模型能够生成自己的训练数据,并使用它来继续自我改进,这可能会使迫在眉睫的数据短缺变得无关紧要。

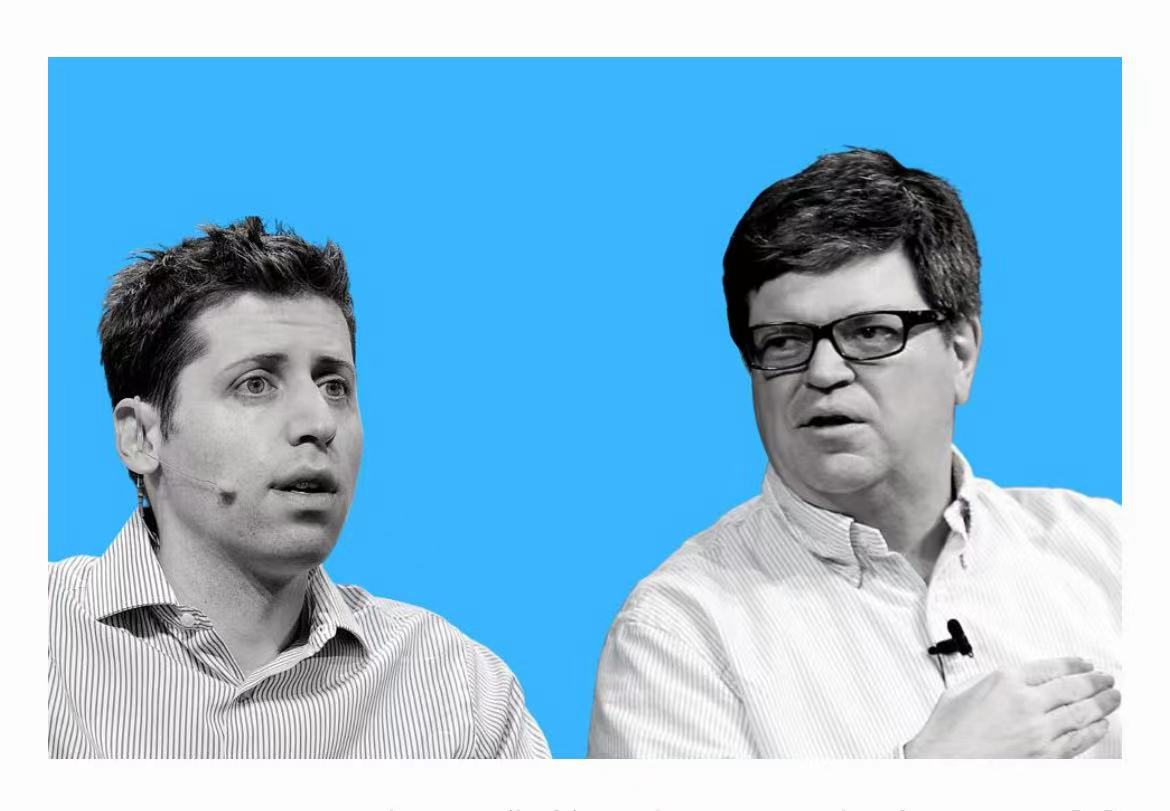

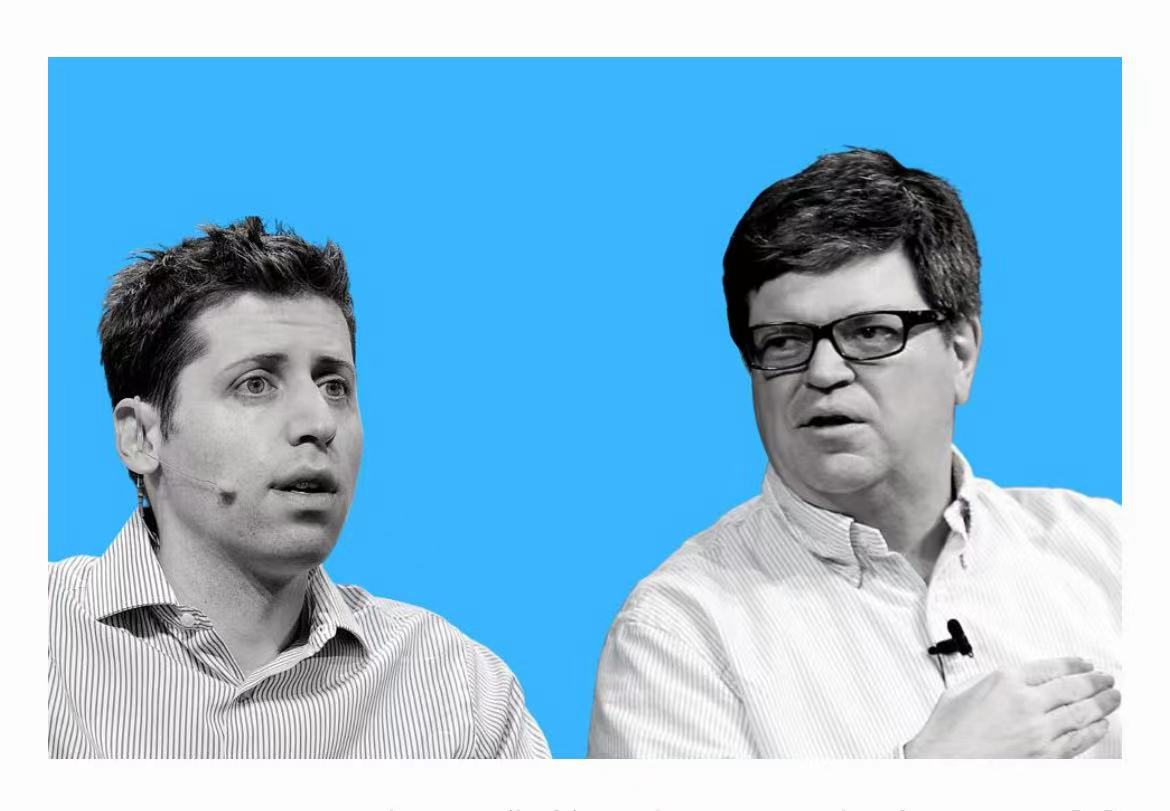

OpenAI首席执行官Sam Altman和Meta AI负责人Yann LeCun

2) 可以自我核实事实的模型。

如今,一个流行的说法是,ChatGPT和像它这样的会话法团即将取代谷歌搜索成为世界首选信息来源,扰乱了曾经拥有霸天的科技巨头,如百视达或柯达,在此之前被打乱了。这种叙事严重过度简化了事情。今天存在的大模型永远不会取代谷歌搜索。为什么不呢?简而言之,因为今天的法兰特法是编造的。尽管大型语言模型非常强大,但它经常产生不准确、误导性或虚假的信息(并自信和令人信服地呈现这些信息)。ChatGPT的“幻觉”的例子比比皆是(正如这些错误陈述所指的那样)。这并不是要单独挑出ChatGPT;今天存在的每种生成语言模型都以类似的方式产生幻觉。

举几个例子:它推荐不存在的书;它坚持数字220小于200;不确定亚伯拉罕·林肯的刺客在暗杀时是否与林肯在同一大陆上;它对贝叶斯定理等概念提供了合理但不正确的解释。大多数用户有时不会接受错误的基本事实的搜索引擎;即使99%的准确性也不足以广泛采用市场。

OpenAI首席执行官Sam Altman本人也承认了这一点,最近警告说:“ChatGPT非常有限,但在某些方面足够好,可以给人留下对伟大的误导性印象。现在依靠它做任何重要的事情是错误的。”问题是否可以通过逐步改进现有架构来解决,或者是否需要对人工智能方法进行更根本的范式转变,以赋予人工智能常识和真正的理解,这是一个悬而未决的问题。深度学习先驱Yann LeCun认为后者。LeCun的相反观点可能是正确的;时间会证明一切。然而,在短期内,一系列有希望的创新至少可以缓解大模型的事实不可靠性。这些新方法将在为广泛的现实世界部署准备大模型方面发挥重要作用。

目前使语言模型更准确的努力有两种相关能力:(1)从外部来源检索信息的能力,(2)为其提供的信息提供参考和引用的能力。ChatGPT仅限于已经存储在其中的信息,这些信息以静态权重捕获。(这就是为什么它无法讨论2021年后发生的事件,当时模型被训练。)能够从外部来源提取信息将使大模型能够访问最准确和最新的可用信息,即使这些信息经常变化(例如公司的股价)。

当然,访问外部信息源本身并不能保证大模型将检索最准确和相关的信息。大模型提高透明度和对人类用户的信任的一个重要方法是引用他们检索信息的来源。这种引用允许人类用户根据需要审计信息源,以便自己决定其可靠性。该领域的重要早期工作包括REALM(来自谷歌)和RAG(来自Facebook)等模型,两者都于2020年发布。随着近几个月对话法学硕士的兴起,该领域的研究现在正在迅速加速。

去年,OpenAI发布了其GPT模型的微调版本,名为WebGPT,该版本可以使用Microsoft Bing浏览互联网,以便对提示做出更准确、更深入的响应。WebGPT像人类一样浏览互联网:它可以向Bing提交搜索查询,关注链接,在网页上上下滚动,并使用Ctrl+F等功能查找术语。当模型在互联网上找到并将其纳入其输出的相关信息时,它会提供引文,以便人类用户可以看到信息来自哪里。

结果令人鼓舞:对于同一查询,WebGPT的回复在56%的时间里比人类受试者撰写的回复更受欢迎,69%的时间比Reddit上评分最高的回复更受欢迎。DeepMind也在沿着这些方向进行研究。几个月前,DeepMind发布了一款名为Sparrow的新模型。与ChatGPT一样,Sparrow是基于对话的;与WebGPT一样,它可以在网上搜索信息,并为其断言提供引用。Sparrow建立在DeepMind早期的重要工作基础上,包括SpaLM、RETRO和GopherCite。

DeepMind研究人员发现,Sparrow的引用在78%的时间里是有帮助和准确的——这表明这种研究方法很有希望,大模型不准确的问题远未解决。包括You.com和Perplexity在内的年轻初创公司最近还推出了大模型驱动的对话搜索界面,能够从外部来源检索信息和引用引用。这些产品今天可供公众使用。法兰法会最大的缺点是他们不可靠,他们顽固地自信地提供不准确的信息。语言模型有望重塑我们经济的每个部门,但在这个问题得到解决之前,它们永远不会充分发挥潜力。预计在未来几个月内会看到该领域的大量活动和创新。

3)大量稀疏的专家模型。

今天最突出的大型语言模型实际上都具有相同的架构。Meta AI负责人Yann LeCun最近表示:“就基础技术而言,ChatGPT并不特别创新。这没有什么革命性的,尽管这是公众对它的看法。只是,你知道,它组装得很好,做得很好。”LeCun的声明引发了许多争议和推特辩论。但简单的事实是,他是正确的,因为任何严肃的人工智能研究人员都不会对此提出异议。

今天所有著名的语言模型——例如OpenAI的GPT-3、谷歌的PaLM或LaMDA、Meta的卡拉狄加或OPT、Nvidia/微软的Megatron-Turing、AI21实验室的Jurassic-1——都是以相同的基本方式构建的。它们是基于自回归、自我监督、预训练、密集激活变压器的模型。诚然,这些模型之间存在差异:它们的大小(参数计数)、训练的数据、使用的优化算法、批处理大小、隐藏层的数量、它们是否经过指令微调等。这些变化可以转化为有意义的性能差异。

然而,在被称为稀疏专家模型的语言模型的有趣不同的架构方法背后,势头正在增强。虽然这个想法已经存在了几十年,但它直到最近才重新出现并开始流行起来。上面提到的所有型号都是密集的。这意味着每次模型运行时,都会使用其每个参数。例如,每次您向GPT-3提交提示时,该模型的所有1750亿参数都会被激活,以产生其响应。但是,如果一个模型只能调用其参数中最相关的子集来响应给定的查询,那该怎么办?这是稀疏专家模型背后的基本概念。稀疏模型的定义特征是,它们不会激活给定输入的所有参数,而只激活那些有助于处理输入的参数。

因此,模型稀疏性将模型的总参数计数与其计算要求解耦。这导致了稀疏的专家模型的主要优势:它们可能比密集模型更大,计算要求更低。为什么他们被称为稀疏的专家模型?因为稀疏模型可以被认为是由一系列“子模型”组成,这些模型是不同主题的专家。根据向模型提供的提示,模型中最相关的专家将被激活,而其他专家则保持不活跃。例如,用俄语提出的提示只会激活一个可以用俄语理解和响应的模型中的“专家”,有效地绕过模型的其余部分。今天所有最大的大模型都是稀疏的。如果您遇到参数超过1万亿的法尔姆,您可以安全地假设它是稀疏的。这包括谷歌的交换机变压器(1.6万亿参数)、谷歌的GLaM(1.2万亿参数)和Meta的专家混合模型(1.1万亿参数)。

Mikel Artetxe说:“人工智能最近的大部分进展来自训练越来越大的模型。”他在辞职共同创立一家隐形大模型初创公司之前领导了Meta对稀疏模型的研究。“例如,GPT-3比GPT-2大100多倍。但是,当我们将密集模型的尺寸翻倍时,我们也会让它慢两倍。稀疏模型允许我们在不增加运行时间的情况下训练更大的模型。”最近对稀疏专家模型的研究表明,这种架构具有巨大的潜力。

GLaM是谷歌去年开发的稀疏专家模型,比GPT-3大7倍,需要少三分之二的能量来训练,需要一半的计算才能进行推理,并在广泛的自然语言任务上优于GPT-3。Meta对稀疏模型的类似工作也产生了类似的有希望的结果。正如Meta研究人员总结的那样:“我们发现稀疏模型可以在计算的一小部分实现与密集模型类似的下游任务性能。对于计算预算相对较小的模型,稀疏模型可以与需要近四倍计算的密集模型相媲天。”稀疏的专家模型的另一个好处值得一提:它们比密集模型更容易解释。可解释性——人类理解模型为什么采取这种行动的能力——是当今人工智能最大的弱点之一。

一般来说,今天的神经网络是无法解释的“黑匣子”。这可能会限制它们在现实世界中的有用性,特别是在医疗保健等高风险环境中,在这些环境中,人类审查很重要。稀疏的专家模型比传统模型更自然地适合可解释性,因为稀疏模型的输出是模型中可识别的离散参数子集的结果——即激活的“专家”。

人类可以从稀疏模型中更好地提取关于其行为的可理解的解释,这一事实可能证明是这些模型在现实世界应用中的决定性优势。稀疏的专家模型今天没有被广泛使用。与密集模型相比,它们不太被理解,在技术上更复杂。然而,考虑到它们的潜在优势,最重要的是计算效率,看到稀疏的专家架构在未来的大模型世界中变得更加普遍,不要感到惊讶。

用Graphcore首席技术官Simon Knowles的话来说:“如果人工智能可以做很多事情,它不需要访问其所有知识来做一件事。这完全是显而易见的。这就是你大脑的工作方式,也是人工智能应该如何工作。如果到明年,有人正在构建密集的语言模型,我会感到惊讶。”

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢