最近,图灵奖得主、Meta首席人工智能科学家Yann LeCun连续发推,不看好ChatGPT为代表的大模型发展。

他先说明ChatGPT缺乏创新,没什么革命性:「过去很多公司和研究实验室都构建了这种数据驱动的人工智能系统,认为 OpenAI 在这类工作中是孤军奋战的想法是不准确的。与其他实验室相比,OpenAI 并没有什么特别的进步。」

在被OpenAI CEO取关后,Yann LeCun再次抨击说,ChatGPT对现实的把握非常肤浅。

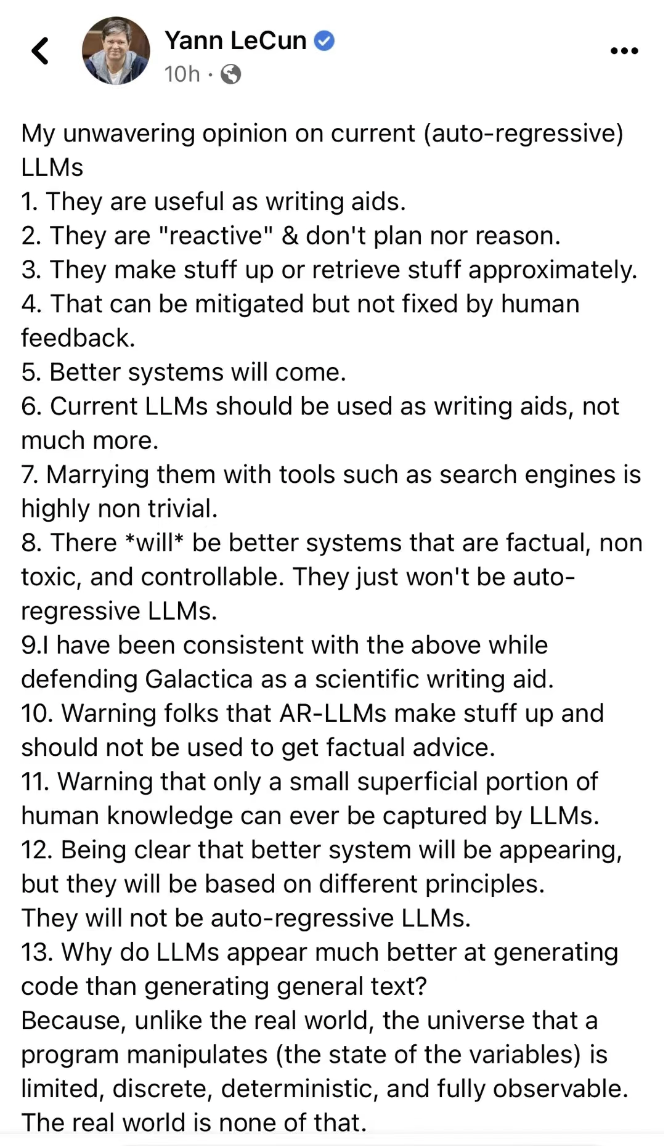

昨天,他在Facebook上又发表了目前他对自回归大模型「非常确凿」的看法:

-

它们作为写作辅助工具是有用的。

-

他们的回复 "被动的",回复没有规划也不主动推理。

-

他们有时候胡编乱造,或者靠检索就回复了。

-

这一点可以通过人类的反馈来改善,但无法解决。

-

未来会有更好的系统会出现。

-

目前仅可作为写作的辅助工具。

-

很难将它们与搜索引擎工具结合起来。

-

未来将会有更好的系统,它们是事实的、相对安全和可控的。他们不会仅仅只依赖自回归LLM。

-

我一直坚持上述观点,同时以Galactica作为科学写作工具。

-

提醒大家,AR-LLMs编造了一些东西,不应该用来获得事实性建议。

-

特别注意LLMs只能捕捉到人类知识的一小部分表面现象。

-

非常明确的是,未来会有更好的系统将会出现,但它们将基于不同的原则。它们不会是自回归LLMs。

-

为什么LLM在生成代码方面似乎比生成一般文本要好得多?与现实世界不同,程序所操纵的宇宙(变量的状态)是模仿的、离散的、确定的和完全可观察的,但现实世界却不是这样的。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢