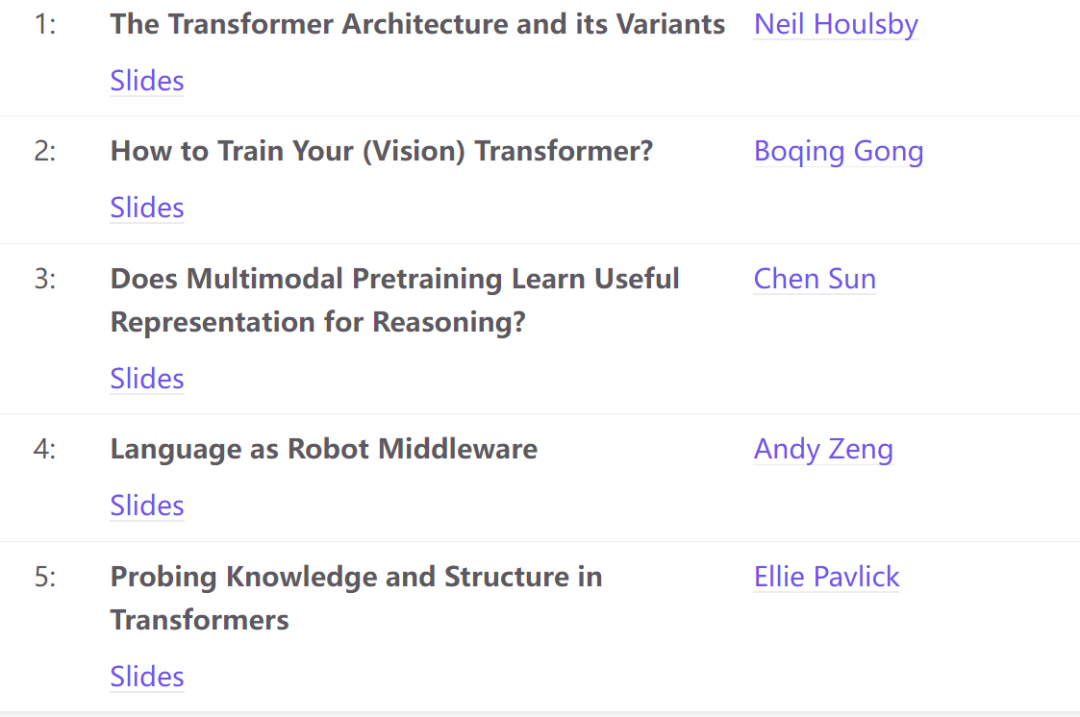

本教程旨在从Transformer架构的角度,分享统一神经架构的令人兴奋的最新进展,这些架构可以处理不同的输入模态,并学习解决不同的任务。其目标是让与会者“了解关于Transformers的一切”。本教程涵盖了基本架构及其最新变体(Neil Houlsby),有效的优化算法(Boqing Gong),多模态学习和机器人领域代表性和新兴的新应用(Chen Sun, Andy Zeng),以及探索和分析训练网络捕获了什么知识的工具(Ellie Pavlick)。

我们设想Transformer成功的基本原则是通用的,该教程将有益于广泛的人工智能研究人员和从业人员。最后,本教程将讨论现有基于transformer方法的局限性,并强调一些未来的研究方向。

我们希望参与者对机器学习和深度学习有基本的了解,包括常用的神经架构和学习方法。计算机视觉、语言理解或机器人研究或应用的实践经验是有帮助的,但不是必需的。

链接:https://transformer-tutorial.github.io/aaai2023/

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢