©PaperWeekly 原创 · 作者 | Nlper

多模态类比推理是一种使用类比和模拟的方法,用于帮助人们理解抽象的概念、解决问题和形成新的知识。在多模态类比推理中,人们通过将一个概念或情境与另一个相似的概念或情境进行比较,来理解和解决问题。这种方法可以帮助人们通过熟悉的概念来理解抽象的概念,并使用自己在这些概念中获得的经验来解决问题。

多模态类比推理在许多领域,如教育、工程、计算机科学和心理学等,都有广泛的应用。它是一种有效的思维工具,可以帮助人们在理解、解决问题和形成新知识时产生创造性的思维。

论文标题:

Multimodal Analogical Reasoning over Knowledge Graphs

http://arxiv.org/abs/2210.00312

https://github.com/zjunlp/MKG_Analogy

https://huggingface.co/spaces/zjunlp/MKG_Analogy

Motivation

类比推理是一种感知和利用两种情况或事件之间的关系相似性的能力,在人类认知中占有重要地位,并且在众多领域例如教育、创造发挥着重要作用。一些学者考虑将类比推理与人工智能进行结合,在计算机视觉和自然语言处理领域都进行了广泛应用。其中,CV 领域将视觉与关系、结构和类比推理相结合,测试模型对于基本图形的的理解和推理能力;NLP 领域通过词语的线性类比来验证模型的文本类比推理能力。

上述任务大多遵循 的形式对深度学习模型的类比推理能力作了初步分析,但都仅限于单模态,没有考虑神经网络是否有能力从不同模态中捕获类比信息。然而,Mayer 认知理论 [1] 指出,人类通常在多模态资源中能表现出更好的类比推理能力,那人工智能模型是否具有这种性质呢?

这篇论文提出了一个基于知识图谱的多模态类比推理任务,任务形式可以形式化为 。本文构建了一个多模态类比推理数据集 MARS 和一个多模态知识图谱数据集 MarKG 作为支撑。

为了评估多模态类比推理过程,本文基于心理学理论的指导,对多模态知识图谱嵌入基线和多模态预训练 Transformer 基线在 MARS 上进行了综合实验。本文进一步提出了一个新型多模态类比推理框架MarT,它可以随时插入任何多模态预训练的 Transformer 模型中,并能产生更好的类比推理性能。

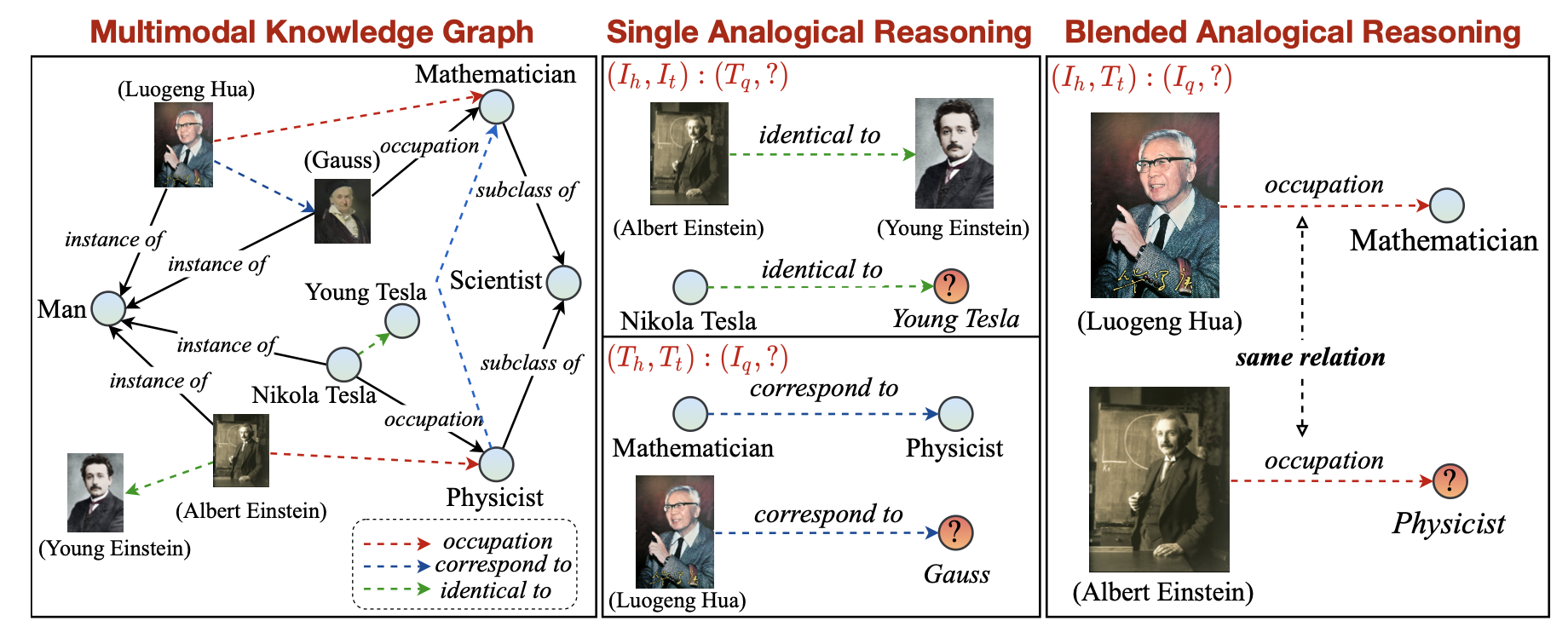

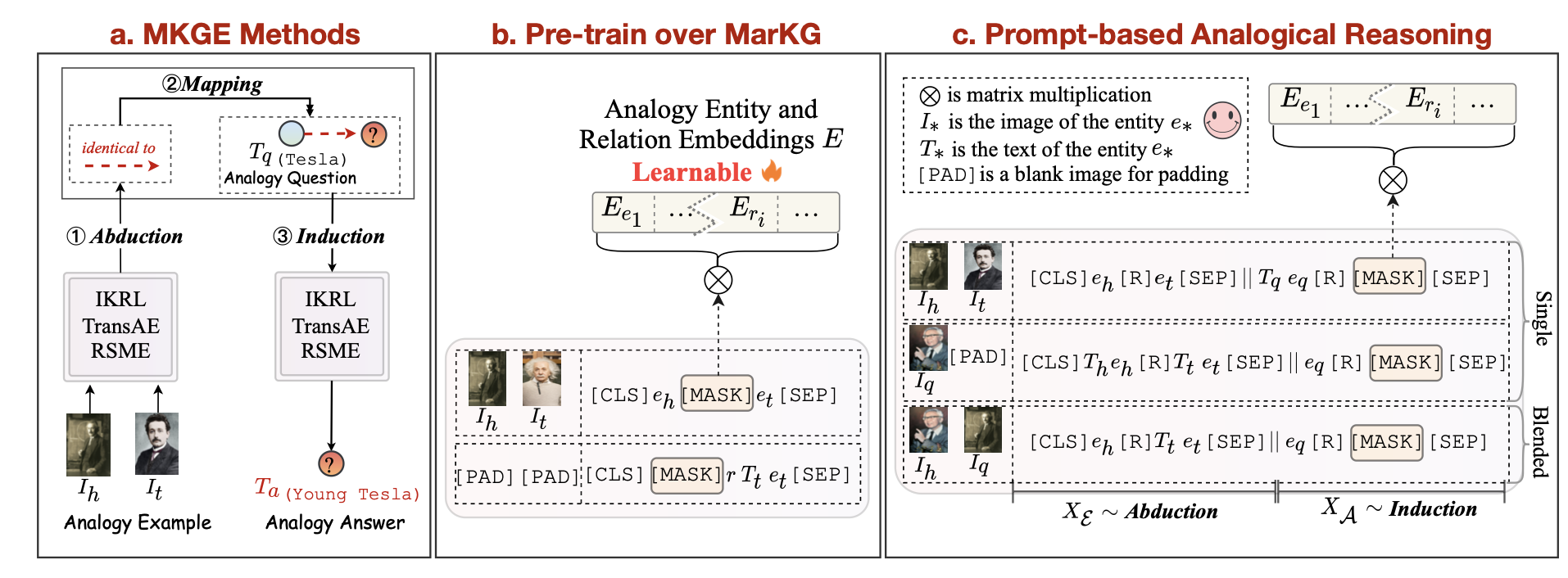

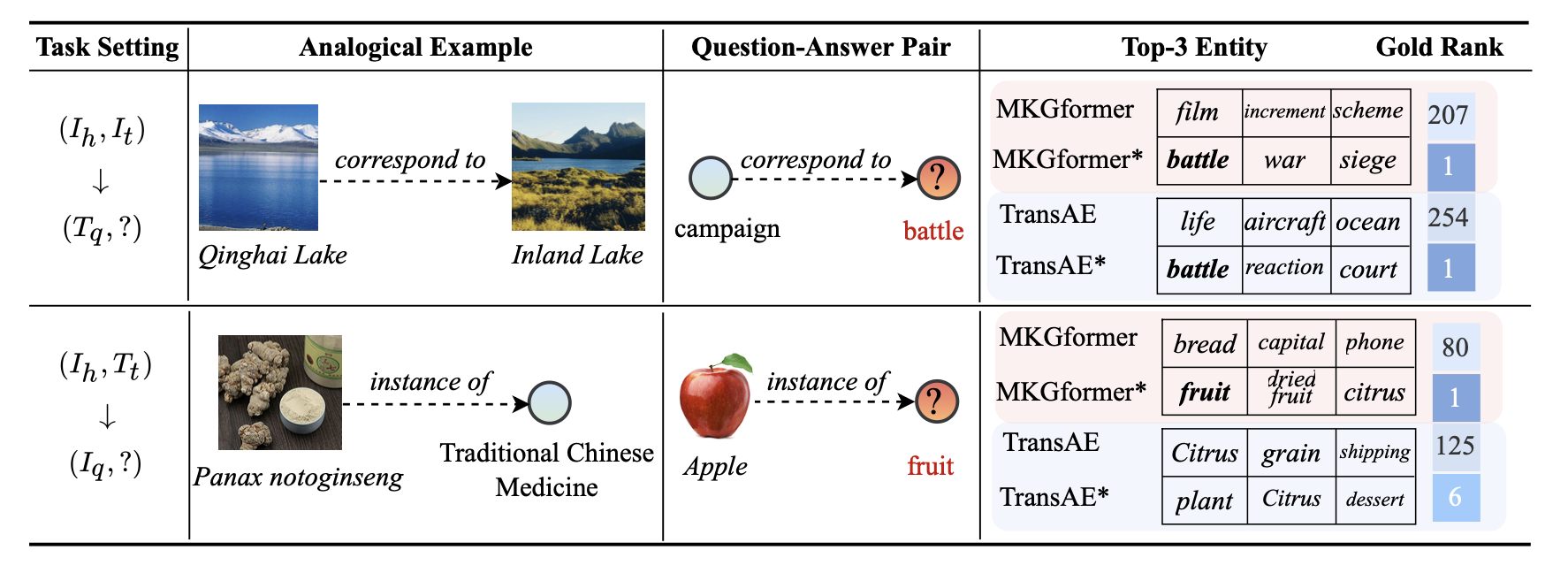

▲ 图1 基于知识图谱的多模态类比推理任务设定示意图

本文提出的多模态类比推理任务如上图所示,类似于没有显示提供关系的链接预测任务,可以被形式化定义为 。其中, 是给定的类比示例, 是问题-答案实体对,类比推理的任务基于背后的知识图谱 G 来预测未知的答案实体。

本文还将任务进一步分为 Single Analogical Reasoning 和 Blended Analogical Reasoning 等两种设定,两种设定的区别在于实体的模态信息不同,Blended 设定下模态信息更为复杂,对推理能力的要求也更高。

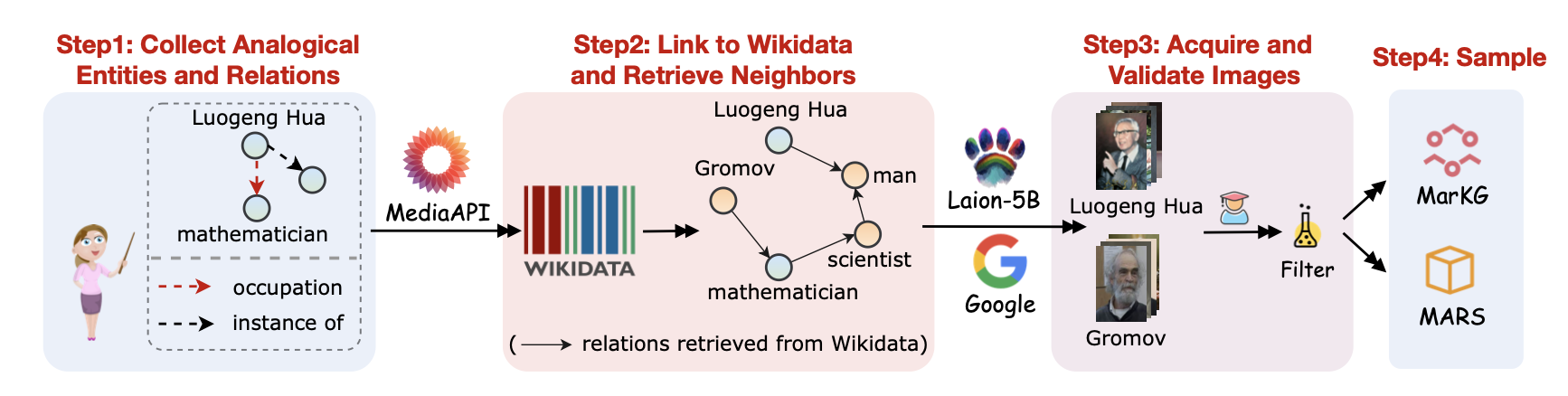

多模态类比推理数据集 MARS 和背后的多模态知识图谱 MarKG 的构建过程如上图所示。首先,从两个文本类比推理数据集 E-KAR 和 BATs 中收集种子实体和种子关系;其次,将这些实体和关系映射到大型知识库 Wikidata 中并进行实体和关系的统一规范化;之后,从 Google 图片引擎以及多模态数据 Laion-5B 中检索实体图片并使用一系列的措施去过滤低质量图片;最后,从中检索高质量的类比数据来构建 MARS 数据集。

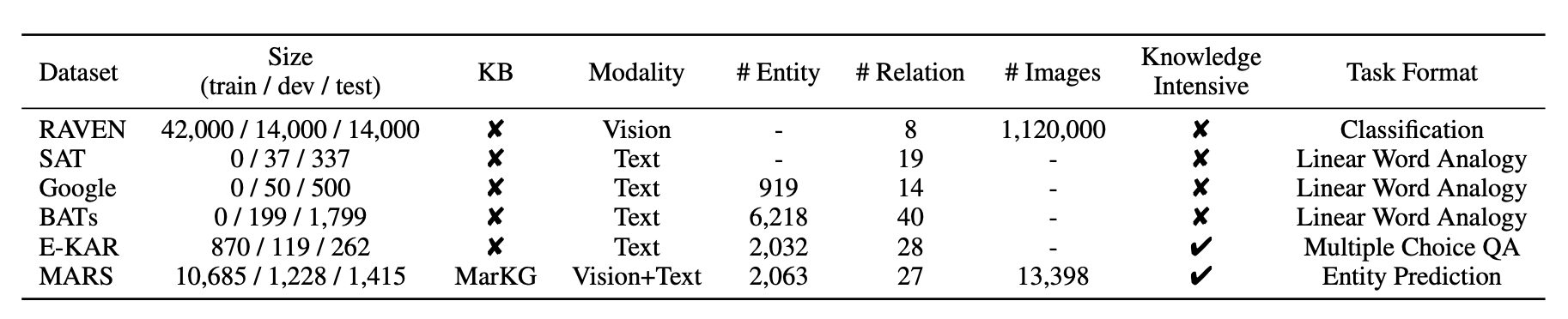

数据的统计情况如上表所示,本文所提出的 MARS 数据集不仅包含了图片和文本等多模态的数据,并且在数据规模上也超过了以往的一些数据集。

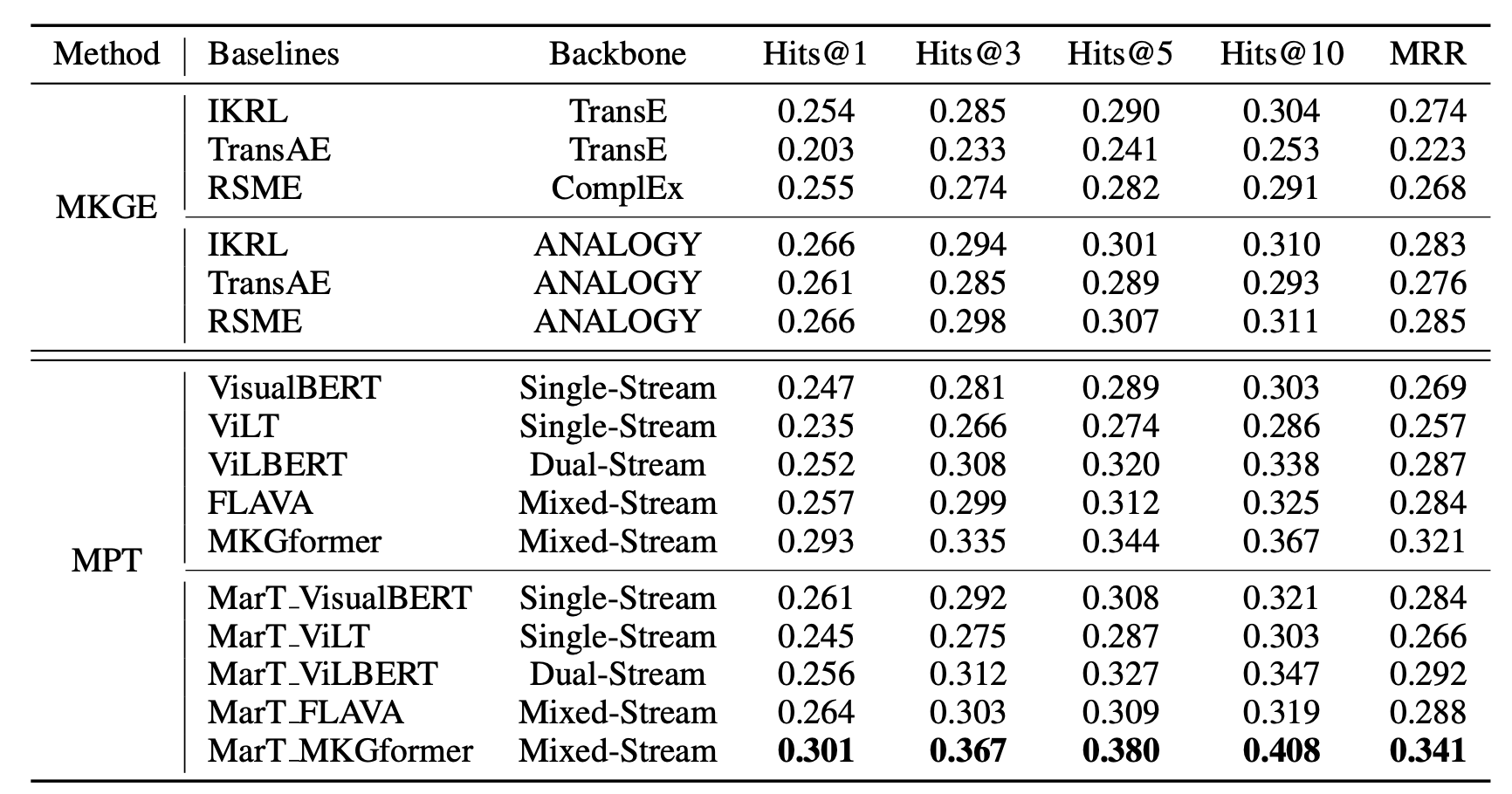

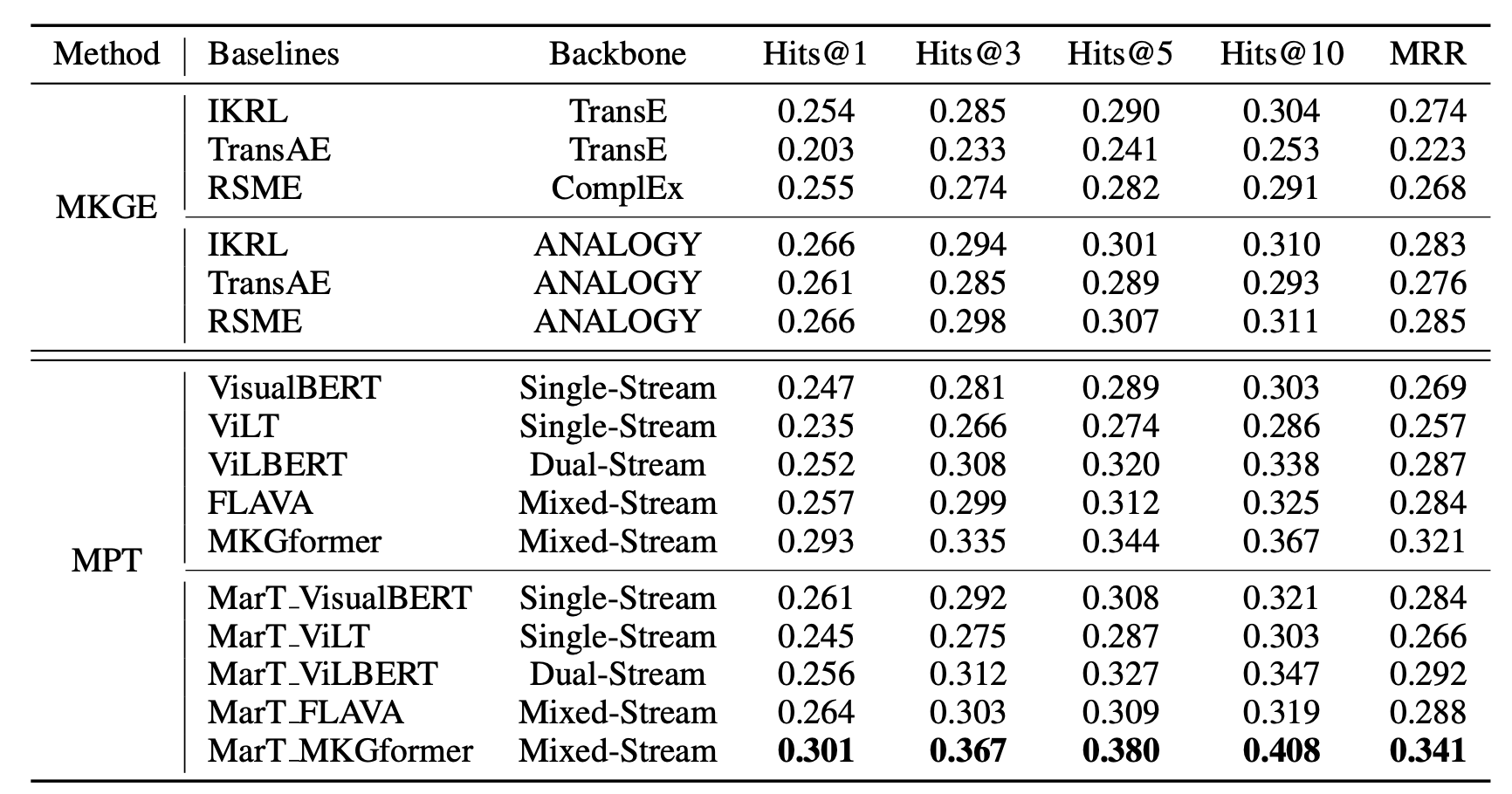

本文在一些基线模型上进行了测试,包括三个多模态知识图谱嵌入模型(IKRL, TransAE, RSME)和五个基于 transformer 的多模态预训练模型(VisualBERT, ViLT, ViLBERT, FLAVA 和 MKGformer)。

4.1 多模态知识图谱嵌入模型

对于多模态知识图谱嵌入模型,本文采用 Pipeline 的方式来求解类比推理问题。包括 Abduction - Mapping - Induction 等三个步骤。其中,Abduction 用来预测类比示例 的潜在关系,Mapping 将预测出的潜在关系映射到类比问题实体上,最后,Induction 步骤用来预测最终的类比答案实体。

4.2 多模态预训练模型

本文将每个实体和关系视为特殊 token 添加到预训练模型的词表中,并使用可学习的向量来进行表示。受 [2] 和 [3] 启发,本文设计了类似于掩码语言建模的掩码实体和关系建模任务来学习这些向量,使其包含实体和关系的信息。

如图 4(b) 所示,首先在 MarKG 数据集上预训练多模态 Transformer 模型。MarKG 数据集中包含了实体的文本描述信息、图片信息以及实体之间的关系信息,这里期望模型可以从这些多源信息中学习到实体和关系的表示。为此,本文设计了一个提示模板,以完形填空的形式让模型预测 [MASK] 对应的实体或关系。此外,本文还为模型提供了实体的不同模态信息,包括文本描述和图片等。

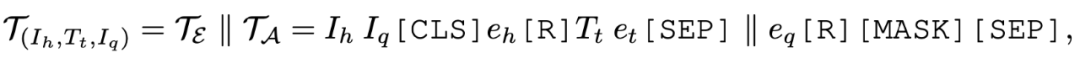

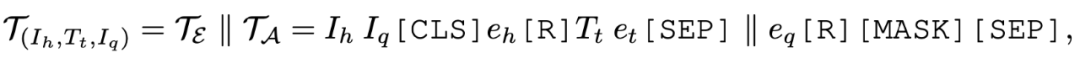

在预训练结束后,采用带有显示结构映射的提示学习类比推理技术,来将预训练 Transformer 模型应用到下游数据集 MARS 上。如图 4(c) 所示,输入分为两部分,|| 左边的部分对应于 Pipeline方式中 Abduction 的步骤,|| 右边的部分对应于Induction 步骤,而 Mapping 步骤在模型内部完成。

使用特殊 token [R] 来代表类比示例实体之间的潜在关系,并将输入中包含的实体 用预训练过程中学习到的实体 embedding 进行替代。最终,通过在特殊 token 词表空间中预测 [MASK] 对应的特殊 token 来得到类比答案实体。

4.3 MarT框架

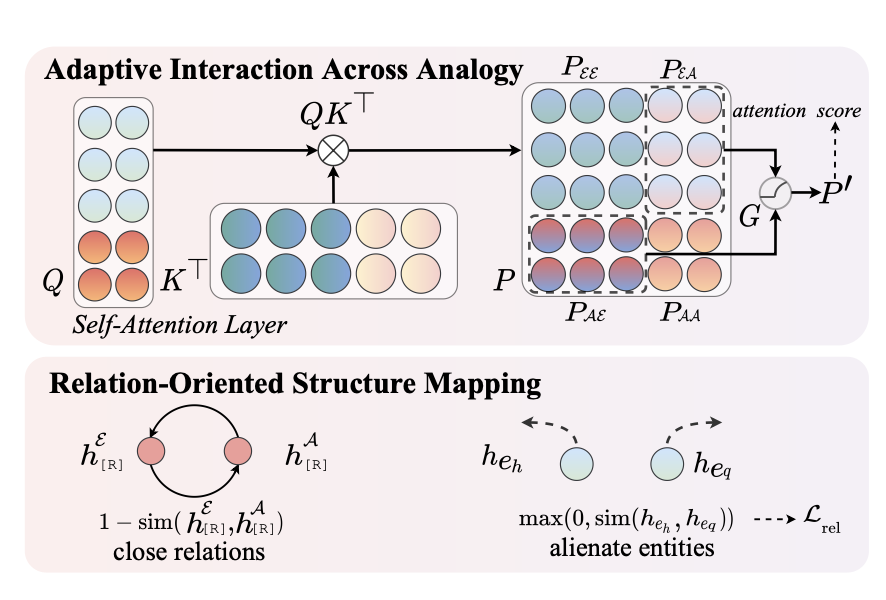

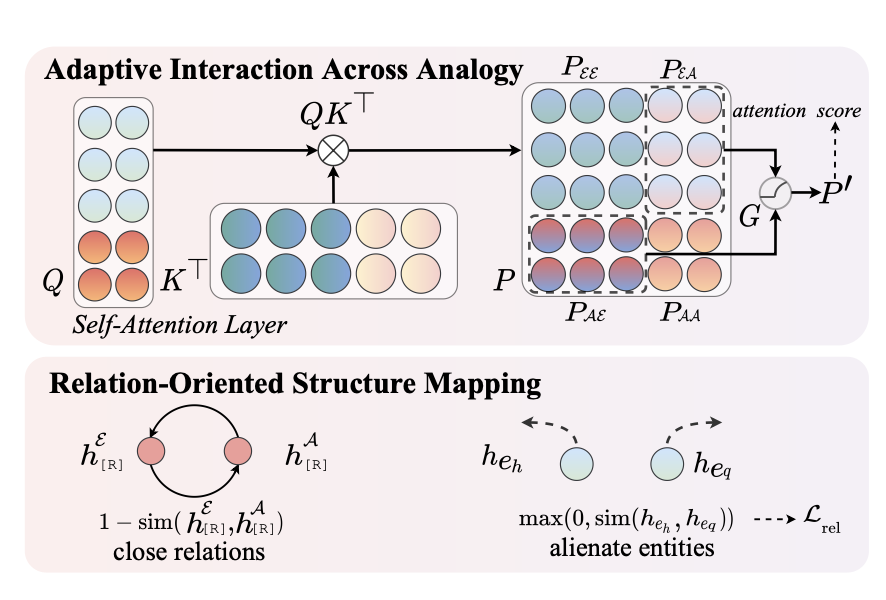

尽管上述方法可以使得预训练 Transformer 模型可以建模多模态类比推理任务,但只是浅层的考虑了 Abduction 和 Induction 步骤,忽略了类比示例与类比问题-答案对之间的细粒度关联。因此,本文进一步提出了用于 Transformer 模型的 MarT 框架,它包含了自适应类比交互和面向关系的结构映射等两个模块。

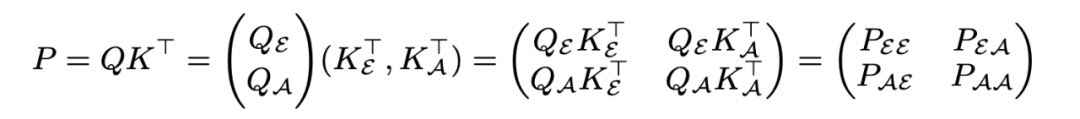

之前通过设计类比提示模板讲类比示例与类比问题-答案对拼接送入的 Transformer 模型,在 Attention 计算时两部分会进行一定程度交互。然而,类比示例对于类比答案的预测至关重要,但反过来类比问题-答案对对于类比示例的建模可能帮助甚微。此外,不同样例中类比示例提供的帮助不同。因此,本文使用自适应关联门来调节 Attention 计算中两部分的交互程度,将 Attention 计算拆解过程进行了拆解:

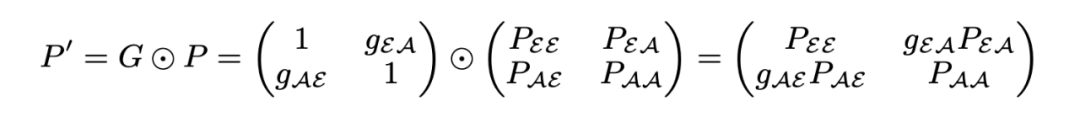

其中, 和 为 intra-analogy attention, 和 为 inter-analogy attention。这里使用门控 G 来控制 iter-analogy attention 的交互:

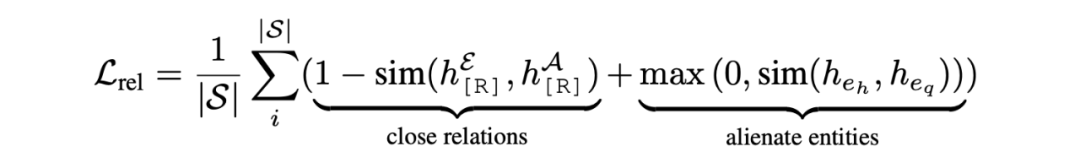

关系映射理论 [4] 指出在类比推理中关系结构的映射要比目标之间的相似性更为重要。例如,电池可以类比为蓄水池是因为它们都存储潜力,而不是它们的形状是圆柱形。受此启发,本文提出了针对类比推理的松弛损失来让模型更加关注关系结构的迁移:

其中, 为类比示例中的特殊 token [R] 在 MLM head 中的隐藏特征, 为余弦相似度计算。

5.1 主要结果

如下表所示,MKGE 的方法和 MPT 的方法在 MARS 数据集上取得了可比的性能;在模型中加入类比模块后,性能都有了大幅的提升,具体表现为 MKGE 方法使用 ANALOGY 作为 Backbone 时 Hit 指标和 MRR 指标都有了明显提升,MPT 方法加入了 MarT 框架后提升也十分显著;MarT_MKGformer 表现出了最优越的性能,原因可能是 MKGformer 是针对多模态知识图谱任务设计的,对此类任务更为敏感。

https://zjunlp.github.io/project/MKG_Analogy/

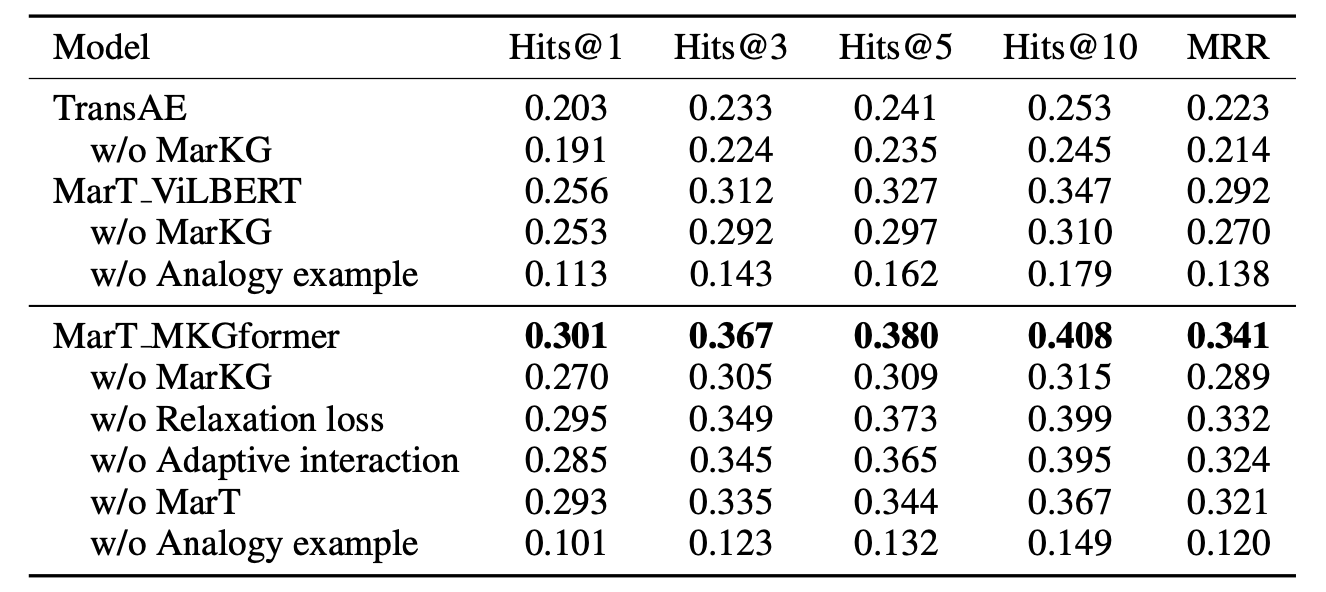

5.2 消融实验

本文对不同模块进行了消融分析,以验证不同模块的有效性:MarKG 可以为模型提供实体和关系的先验知识;类比模块以及类比示例对于类比答案实体的推理至关重要。

5.3 样例分析

样例分析进一步说明原生的模型在多模态类比推理任务中表现是偏弱的,加入类比相关组件可以提高模型性能。

5.4 ChatGPT效果

小编出于好奇在阅读本文的时候拿 ChatGPT 去测试了一下,发现经过指导的大模型具备一定程度的多模态类比推理能力,但当类比的对象比较抽象时也会犯错误。

类比示例是地球对应银河系,正确答案是伦敦对应英国和水对应海洋,ChatGPT 直接回答图片的内容。

在人类智能中,类比是一个很基本的能力,在某种程度上,可以认为是人类智能的源头之一。人们通过将一个概念或情境与另一个相似的概念或情境进行比较,来理解和解决问题。这种方法可以帮助人们通过熟悉的概念来理解抽象的概念,并使用自己在这些概念中获得的经验来解决问题。

本文提出了基于知识图谱的多模态类比推理任务,对此任务进行了形式化的定义并提供了一个多模态类比推理数据集 MARS 和多模态知识图谱数据集 MarKG。在多个知识图谱嵌入模型和预训练 Transformer 模型上的实验表明了这个任务的困难性和可挖掘性。

[1] Multimedia learning. In Psychology of learning and motivation, volume 41, pp. 85–139. Elsevier, 2002.

[2] MEM-KGC: Masked Entity Model for Knowledge Graph Completion With Pre-Trained Language Model. IEEE Access 2021.

[3] Hybrid Transformer with Multi-level Fusion for Multimodal Knowledge Graph Completion. SIGIR 2022.

[4] Structure-mapping: A theoretical framework for analogy. Cogn. Sci. 1983

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢