论文标题:Large-scale Multi-Modal Pre-trained Models A Comprehensive Survey

论文和代码链接:https://github.com/wangxiao5791509/MultiModal_BigModels_Survey

作者单位:鹏程实验室 & 安徽大学 & 北京大学 & 四川大学

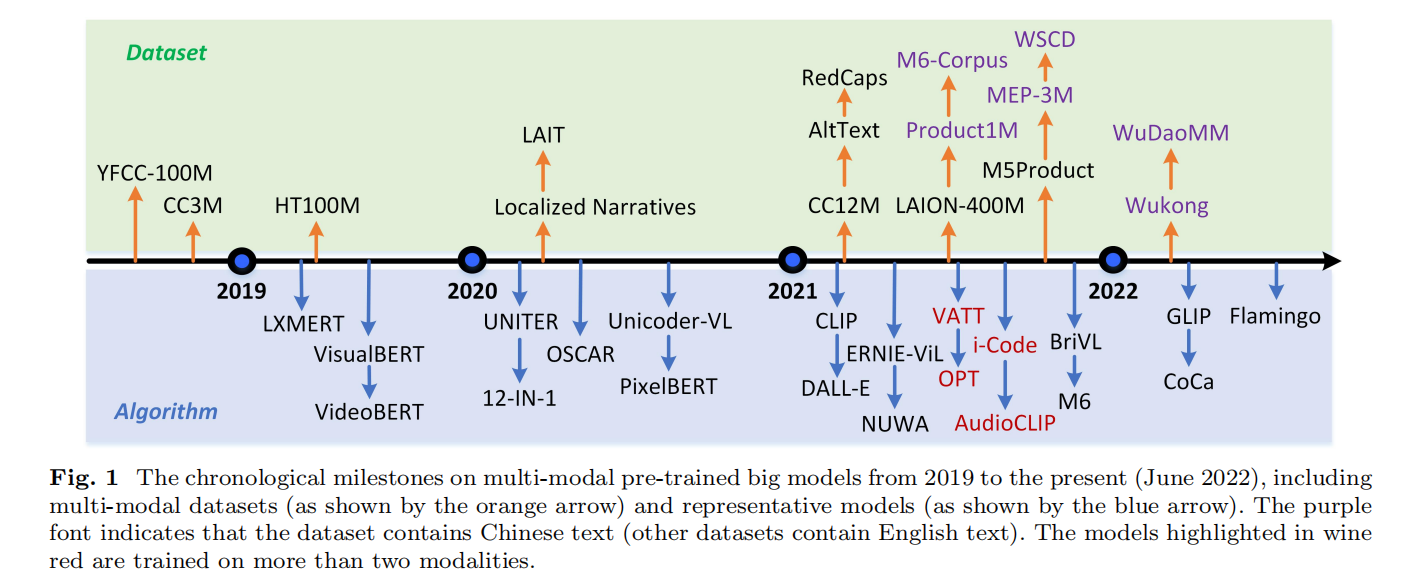

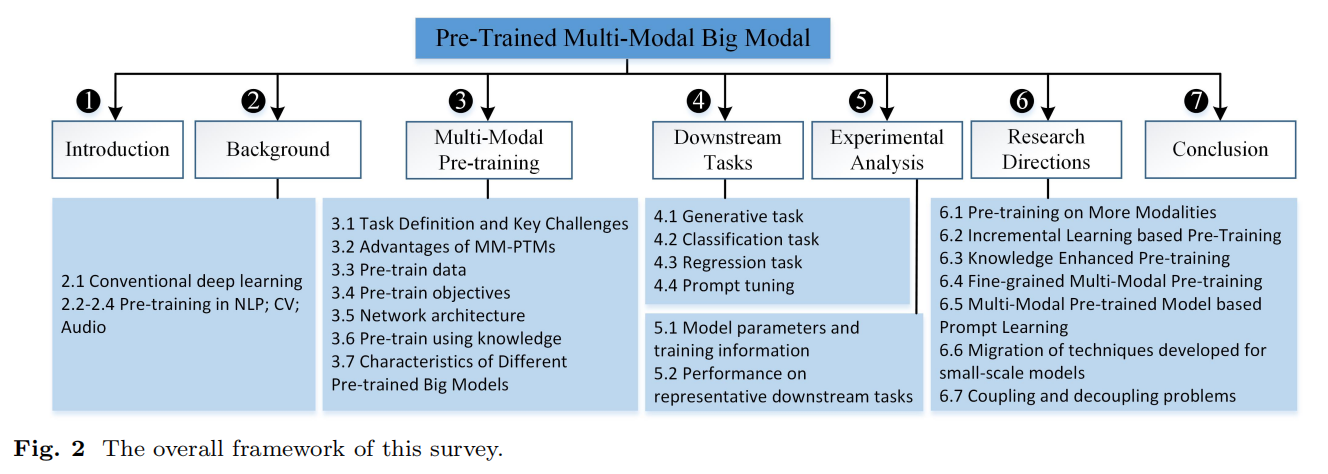

随着对广义深度模型的迫切需求,许多预训练大模型被提出,如 BERT、ViT、GPT 等。受这些模型在单一领域(如计算机视觉和自然语言处理)的成功的启发,多模态预训练大模型近年来也越来越受到关注。 在这项工作中,我们对这些模型进行了全面的调查,并希望这篇论文能够提供新的见解,帮助新的研究人员追踪最前沿的工作。 具体来说,我们首先通过回顾传统的深度学习、自然语言处理、计算机视觉和语音方面的预训练工作来介绍多模态预训练的背景。 然后,我们介绍了多模态预训练模型 (MM-PTM) 的任务定义、主要挑战和优势,并重点讨论了 MM-PTM 的数据、目标、网络架构和知识增强型预训练。 之后,我们介绍了用于验证大规模 MM-PTM 的下游任务,包括生成、分类和回归任务。 我们还对代表性下游任务的模型参数和结果进行了可视化和分析。 最后,我们指出了该主题可能有益于未来工作的可能研究方向。 此外,我们为大规模预训练多模态大模型维护一个持续更新的论文列表。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢