LLaMA,是一个从7B到65B参数的基础语言模型集合。我们在数以万亿计的标记上训练我们的模型,并表明有可能完全使用公开的数据集来训练最先进的模型,而不需要求助于专有的和不可获取的数据集。LLaMA-13B在大多数基准上超过了GPT-3(175B),而LLaMA-65B与最好的模型Chinchilla70B和PaLM-540B相比具有竞争力。

LLaMA: Open and Efficient Foundation Language Models

H Touvron, T Lavril, G Izacard…

[Meta AI]

LLaMA: 开源高效的基础语言模型

要点:

-

LLaMA 是一个开源的基础语言模型集合,参数范围从7B到65B,完全使用公开的数据集在数万亿 Token 上训练; -

LLaMA-13B 在大多数基准上都优于 GPT-3(175B),而体积却小了 10 倍以上,LLaMA-65B 与最好的模型 Chinchilla70B 和 PaLM-540B 相比有竞争力; -

该研究表明,通过完全在公开可用的数据上进行训练,有可能达到最先进的性能,而不需要求助于专有的数据集,这可能有助于努力提高鲁棒性和减轻已知的问题,如毒性和偏见; -

向研究界发布LLaMA模型,可能会加速大型语言模型的开放,并促进对指令微调的进一步研究,未来的工作将包括发布在更大的预训练语料库上训练的更大的模型。

一句话总结:

LLaMA 是开放高效的基础语言模型集合,仅在公开可用的数据集上进行训练,在大多数基准测试中表现优于GPT-3。

与Chinchilla、PaLM或GPT-3不同的是,Meta只用了公开的数据集。如此一来不仅有助于模型开源和复现,而且也证明了无需「定制」的数据集也能实现SOTA。

相较而言,其他大部分模型所依赖的数据,要么不公开,要么没有记录。

与此同时,所有规模的LLaMA模型,都至少经过了1T(1万亿)个token的训练,这比比其他相同规模的模型要多得多。

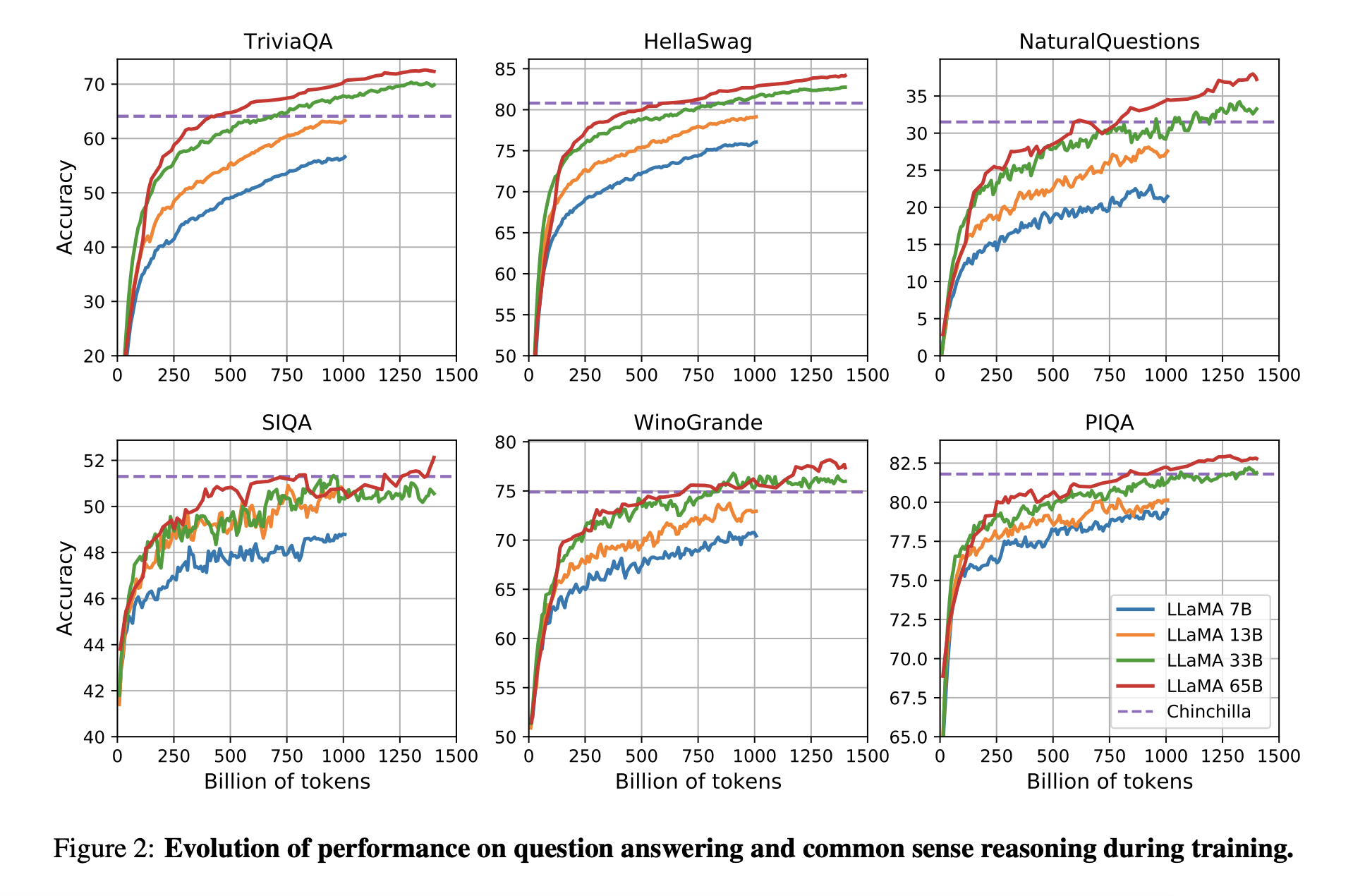

具体来说,LLaMA-65B和LLaMA 33B是在1.4万亿个token上训练的,而最小的模型LLaMA-7B是在1万亿个token上训练的。这种方法的优势在于,在更多的token上训练的较小的模型,更容易重新训练并针对特定的产品使用情况进行调整。

结果评估

在常识推理、闭卷答题和阅读理解方面 ,LLaMA-65B几乎在所有基准上都优于Chinchilla-70B和PaLM-540B。

在数学方面 ,尽管LLaMA-65B没有在任何相关的数据集上进行过微调,但它在在GSM8k上的表现依然要优于Minerva-62B。而在MATH基准上,LLaMA-65B超过了PaLM-62B,但低于Minerva-62B。

值得注意的是,谷歌开发的Minerva模型,是以PaLM语言模型为基础,并采用大量的数学文档和论文语料库对其进行微调。在思维链提示和自洽解码的加持下,Minerva-540B可以在各类数学推理和科学问题的评估基准上达到SOTA。

在代码生成基准上 ,LLaMA-62B优于cont-PaLM(62B)以及PaLM-540B。此外, Meta还尝试使用了论文「Scaling Instruction-Finetuned Language Models」中介绍的指令微调方法。由此产生的模型LLaMA-I,在MMLU上要优于Flan-PaLM-cont(62B),而且还展示了一些有趣的指令能力。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢