MUX-PLMs: Pre-training Language Models with Data Multiplexing

Vishvak Murahari,Ameet Deshpande,Carlos E.Jimenez,Izak Shafran,Mingqiu Wang,Yuan Cao

Princeton University & Google Brain

MUX PLM:带数据复用的预训练语言模型

要点:

1.数据复用是最近提出的一种通过使用有序表示混合同时处理多个实例来提高模型推理效率的方法。先前的数据复用工作只使用任务特定的Transformer,没有任何预训练,这限制了它们的准确性和通用性。

2.在本文中,开发了预训练的多路复用语言模型(MUX PLM),可以在任何下游任务上进行广泛微调。方法包括三阶段训练过程和新颖的复用和解复用模块,以提高吞吐量和下游任务的准确性。

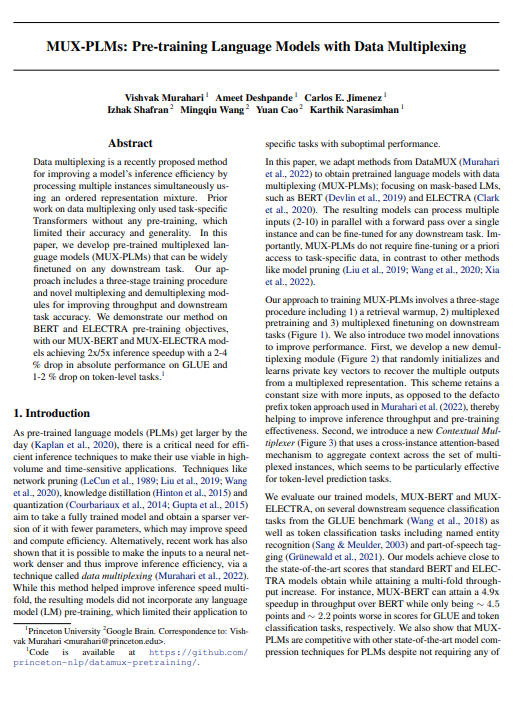

- 训练MUX PLM的方法包括三个阶段,包括1)检索预热,2)多路预训练和3)对下游任务进行多路微调。

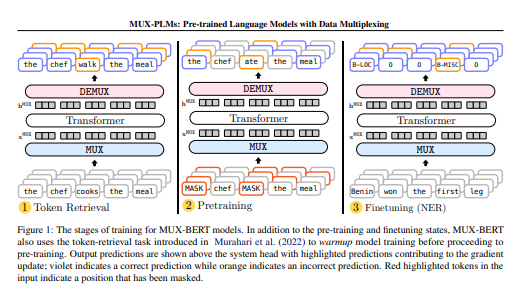

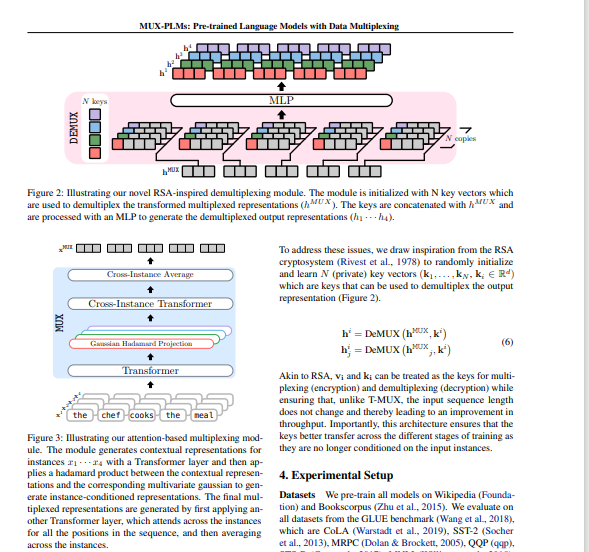

- 我们还引入了两种改进性能的模型创新。首先,我们开发了一个新的解复用模块,它随机初始化和学习私钥向量,以从复用表示中恢复多个输出。与Murahari等人(2022)中使用的事实前缀令牌方法相反,该方案保留了具有更多输入的恒定大小,从而有助于提高推理吞吐量和预训练效率。第二,我们引入了一种新的上下文多路复用器,它使用基于跨实例注意力的机制来聚合多路复用实例集合中的上下文,这似乎对令牌级预测任务特别有效。

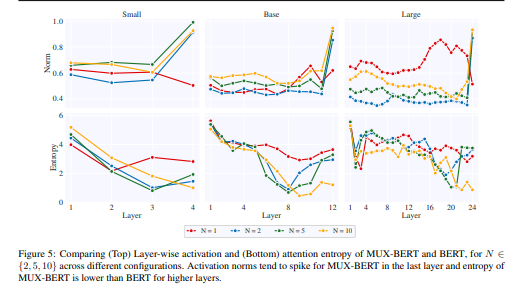

- 评估了我们的训练模型MUX-BERT和MUXELECTRA,基于GLUE基准的几个下游序列分类任务以及令牌分类任务,包括命名实体识别(Sang&Meulder,2003)和部分话语标记(Grünewald等人,2021)。该模型实现了接近标准BERT和ELECTRA模型的最先进分数,同时实现了多倍的吞吐量增长。例如,MUX-BERT的吞吐量可以比BERT提高4.9倍,而GLUE和令牌分类任务的得分分别差约4.5分和约2.2分。文章还表明,MUXPLM与其他最先进的PLM模型压缩技术相比具有竞争力,尽管不需要这些方法使用的任何额外数据。然后,沿着精度效率帕累托前沿比较多路复用模型的不同版本,以证明我们预训练MUX模型的灵活性,这取决于下游应用。最后,我们进行了几项消融研究,并分析了MUX-BERT表示,以提供对数据复用的更多见解。

一句话总结:我们在BERT和ELECTRA预训练目标上演示了我们的方法,我们的MUX-BERT和MUX-ELECTRA模型实现了2x/5x的推理加速,GLUE的绝对性能下降了2-4%,令牌级任务下降了1-2%。[机器翻译+人工校对]

Data multiplexing is a recently proposed method for improving a model's inference efficiency by processing multiple instances simultaneously using an ordered representation mixture. Prior work on data multiplexing only used task-specific Transformers without any pre-training, which limited their accuracy and generality. In this paper, we develop pre-trained multiplexed language models (MUX-PLMs) that can be widely finetuned on any downstream task. Our approach includes a three-stage training procedure and novel multiplexing and demultiplexing modules for improving throughput and downstream task accuracy. We demonstrate our method on BERT and ELECTRA pre-training objectives, with our MUX-BERT and MUX-ELECTRA models achieving 2x/5x inference speedup with a 2-4 \% drop in absolute performance on GLUE and 1-2 \% drop on token-level tasks.

https://arxiv.org/pdf/2302.12441.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢