论文题目:GraphPrompt: Unifying Pre-Training and Downstream Tasks for Graph Neural Networks

代码链接:https://github.com/Starlien95/GraphPrompt

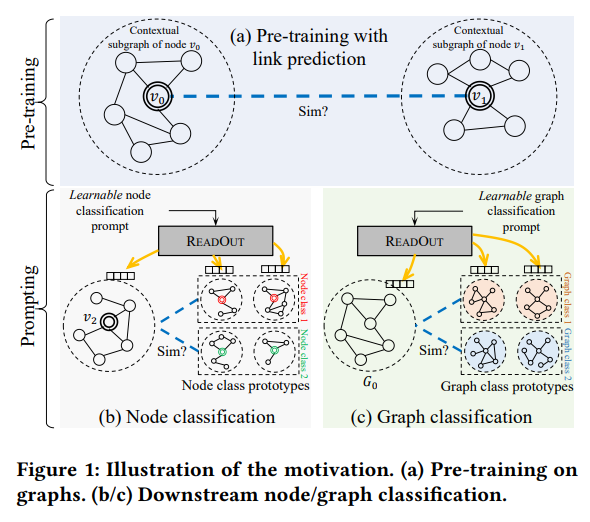

图可以模拟对象之间的复杂关系,从而实现众多网络应用,例如在线页面/文章分类和社交推荐。虽然图神经网络(GNN)已经成为图表示学习的强大工具,在端到端的有监督场景下,GNN 的性能严重依赖于大量有标签的数据。为了减少标签要求,“pre-train,fine-tune”(预训练,微调)和“pre-train,prompt”(预训练,提示)范式变得越来越常见。

特别地,prompt 是自然语言处理(NLP)中fine-tune 的流行替代方案,旨在以任务特定的方式缩小预训练和下游目标之间的差距。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢