随着生成性人工智能模型越来越大、越来越强大,一些科学家主张建立更精简、更节能的系统。

能够产生流畅文本的人工智能系统,如OpenAI的ChatGPT,是科技行业的最新宠儿。但是,当面对需要推理才能回答的数学问题时,这些大型语言模型(LLMs)往往会陷入困境。例如,以这个代数问题为例。

一条平行于y=4x+6的直线通过(5,10)。这条线与y轴相交的点的y坐标是多少?

尽管LLMs有时能正确回答这类问题,但他们更多的时候会出错。在一项早期的推理能力测试中,ChatGPT在面对中学水平的数学问题 "MATH "数据集的样本时,只得到26%的分数(文献1)。

这是可以预料的:给定输入文本,LLM只是根据构成模型训练数据的单词、符号和句子的统计规律来生成新的文本。如果仅仅学习语言模式就能让LLM可靠地模仿数学推理,那就太令人吃惊了。

但早在2022年6月,谷歌创建的一个名为Minerva的法律硕士已经打破了这些预期--在某种程度上。Minerva在MATH数据集的问题上获得了50%的分数,这个结果让一些人工智能(AI)的研究人员感到震惊。

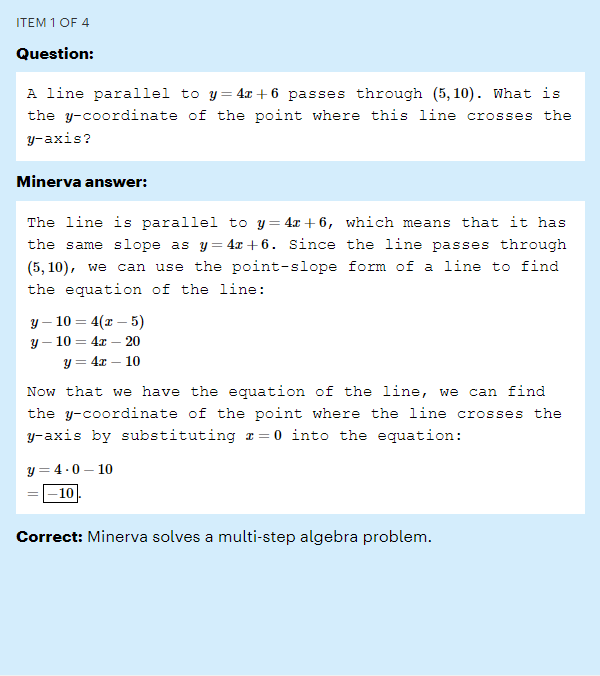

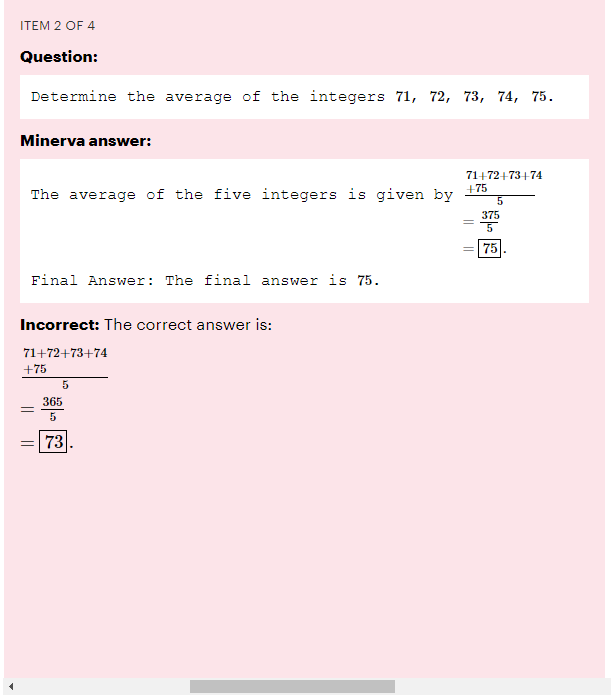

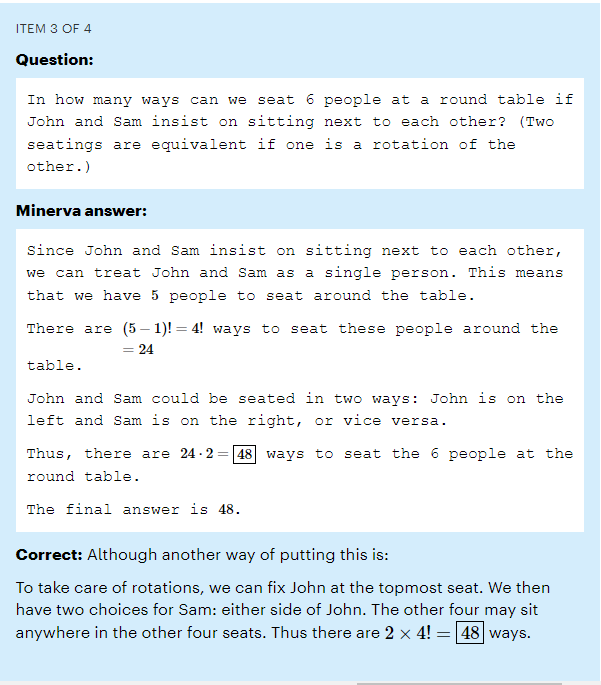

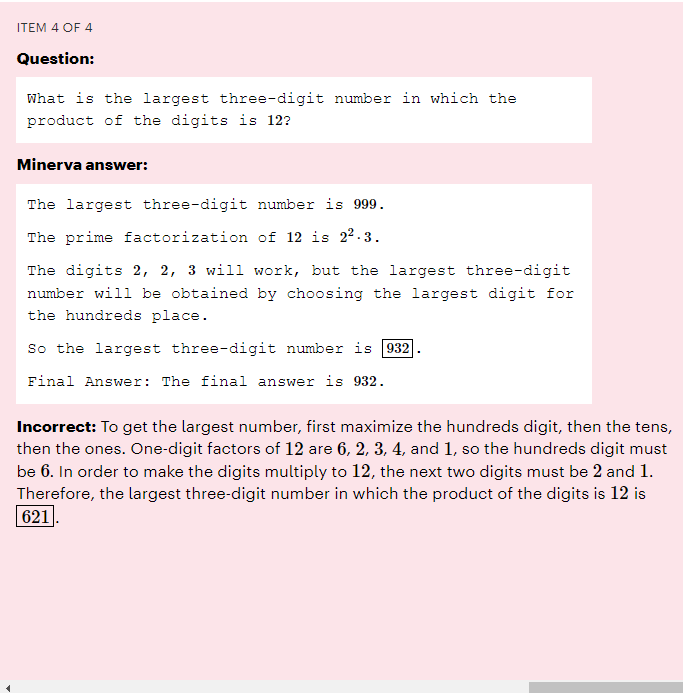

密涅瓦的数学测试

一个名为Minerva的大型语言模型在 "MATH "数据集中的问题上获得了50%的分数,这些问题是中学水平的数学问题。这里有两道它做对了,还有两道它做错了。(更多的例子,请看谷歌研究院的互动探索器)。

测试链接来自:https://ai.googleblog.com/2022/06/minerva-solving-quantitative-reasoning.html

华盛顿州雷德蒙市微软研究院的机器学习专家塞巴斯蒂安-布贝克(Sébastien Bubeck)说:"“社区中的议论纷纷说这真的有点令人震惊"。

Minerva的优势在于它是在与数学有关的文本上进行训练的。但谷歌的研究表明,该模型表现如此出色的另一个重要原因是其庞大的规模。它的规模大约是ChatGPT的三倍。

Minerva的结果暗示了一些研究人员长期以来的怀疑:训练更大的LLM,并给它们提供更多的数据,可以使它们有能力,仅仅通过模式识别,解决那些应该需要推理的任务。如果是这样,一些人工智能研究人员说,这种 "越大越好 "的策略可能提供了一条通往强大人工智能的道路。

但我们有理由怀疑这一论点。LLMs仍然会出现明显的错误,一些科学家认为,更大的模型只是在回答属于其训练数据中的关联范围的查询方面变得更好,而不是获得回答全新问题的能力。

这场辩论现在正在人工智能的前沿领域上演。商业公司已经看到更大的人工智能模型有更好的结果,所以他们正在推出越来越大的LLMs--每一个都需要花费数百万美元来训练和运行(见 "推动更大的人工智能模型")。但这些模型有很大的缺点。除了担心它们的输出不可信,以及它们可能会加剧错误信息的传播之外,它们还很昂贵,并且吸走了大量的能源。

资料来源:改编自Our World in Data和 J. Sevilla等人。arXiv 预印本https://doi.org/10.48550/arXiv.2202.05924 (2022)。

批评者认为,最终,大型人工智能将永远无法模仿或获得技能,使其能够持续回答推理问题。相反,一些科学家说,更小、更节能的人工智能是取得进展的方式--部分是受到大脑似乎学习和建立联系的方式的启发。

大,更大,更好?

ChatGPT和Minerva等LLM是由计算单元(也称为人工神经元)组成的巨大网络,分层排列。一个LLM的大小是以它有多少个参数来衡量的--描述神经元之间连接强度的可调值。训练这种网络包括要求它预测一个已知句子的屏蔽部分,并调整这些参数,使算法在下一次做得更好。

在数十亿个人类写的句子中反复这样做,神经网络就会学习内部表征,模拟人类如何写语言。在这个阶段,一个LLM被称为预训练:它的参数捕获了它在训练期间看到的书面语言的统计结构,包括文本中的所有事实、偏见和错误。然后,它可以在专门的数据上进行 "微调"。

例如,为了制作Minerva,研究人员从谷歌的路径语言模型(PaLM)开始,该模型有5400亿个参数,并在一个有7800亿个标记的数据集中进行了预训练。一个标记可以是一个单词、数字或一些信息单位;在PaLM的案例中,这些标记是从英语和多语言网络文档、书籍和代码中收集的。Minerva是在科学论文和数学相关网页中的数百亿个标记上对PaLM进行微调的结果。

Minerva可以回答这样的提示:30的最大倍数是什么,小于520?LLM似乎在思考这些步骤,然而它所做的只是把问题变成一个标记序列,生成一个统计学上合理的下一个标记,把它附加到原来的序列中,生成另一个标记,以此类推:这个过程称为推理。

谷歌研究人员使用80亿、620亿和5400亿参数的底层预训练的PaLM模型对Minerva的三种规模进行了微调。Minerva的性能随着规模的扩大而提高。在整个MATH数据集上,最小的模型有25%的准确率,中等规模的模型达到43%,最大的模型突破了50%的大关(见图 "更大的聊天机器人在数学方面更好吗?")。

资料来源:改编自参考文献2.

最大的模型也使用了最少的微调数据--它只对260亿个代币进行了微调,而最小的模型则看了1640亿个代币。但是最大的模型花了一个月的时间进行微调,使用的专门硬件的计算能力是最小的模型的八倍,而最小的模型只微调了两个星期。加利福尼亚州山景城谷歌研究院的伊森-戴尔(Ethan Dyer)说,理想情况下,最大的模型应该在更多的代币上进行微调,他是Minerva团队的成员;这可能会导致更好的性能。但该团队认为,计算费用不可行。

缩放法则

最大的Minerva模型做得最好,这与揭示缩放规律的研究是一致的--这些规律制约着性能如何随模型大小而提高。2020年的一项研究表明,当给定三种情况之一时,模型表现更好:更多的参数、更多的训练数据或更多的 "计算"(训练期间执行的计算操作的数量)(文献4)。 性能按照幂律扩展,这意味着它随着参数数量等的某个幂而改善。

然而,研究人员并不确切知道原因。"加拿大蒙特利尔的蒙特利尔大学和米拉-魁北克人工智能研究所的计算机科学家伊琳娜-里什说:"这些规律纯粹是经验性的。

为了获得最好的结果,2020年的研究建议,随着训练数据的翻倍,模型大小应该增加五倍。去年的工作略微修改了这一点。3月,总部位于伦敦的人工智能公司DeepMind认为,最好是同时扩大模型规模和训练数据,在更多数据上训练的小模型比在更少数据上训练的大模型做得更好(文献5)(见图"不同的规模路线")。例如,DeepMind的Chinchilla模型有700亿个参数,在1.4万亿个代币上训练,而其280亿个参数的Gopher模型,在3000亿个代币上训练。在旨在评估LLM所学内容的任务中,Chinchilla的表现优于Gopher。

资料来源:改编自 Our World in Data和 J. Sevilla等人。arXiv 预印本https://doi.org/10.48550/arXiv.2202.05924 (2022)。

Meta Research的科学家们在2月份用他们自己的小参数模型建立了这个概念,该模型被称为LLaMA,在多达1.4万亿个代币上进行训练。研究人员说,130亿个参数版本的LLaMA超过了ChatGPT的先驱GPT-3(1750亿个参数),而650亿个参数的版本则与Chinchilla甚至PaLM竞争(见go.nature.com/3kje2fj)。

去年10月,蒙特利尔麦吉尔大学的Ethan Caballero与Rish等人一起报告说,发现规模和性能之间的关系更加复杂(文献6)。研究人员说,在某些情况下,多个幂律可以支配性能如何随模型大小而变化。

例如,在他们发现的一个符合一般方程的假设情景中,性能先是逐渐提高,然后随着模型的大小而更快地提高,但随着参数数量的不断增加,性能会略有下降,然后再提高。这种复杂关系的特点是由每个模型的具体情况和训练方式决定的。最终,研究人员希望能够在任何特定的LLM被扩大规模时提前预测到这一点。

合理的担忧

山景城谷歌公司的人工智能研究员François Chollet是怀疑论者之一,他认为无论LLM变得多大,它们都不会接近拥有足够好的推理(或模仿推理)能力来可靠地解决新问题。他说,LLM只是通过使用它以前遇到过的模板进行推理,无论是在训练数据中还是在提示中。"它不可能在飞行中对它以前没有见过的东西进行推理。"

LLMs可能能做的最好的事情就是吸纳大量的训练数据,以至于仅凭语言的统计模式就能让他们用非常接近于他们已经看到的答案来回答问题。

然而,Agüera y Arcas认为,LLMs似乎确实获得了一些令人惊讶的能力,而他们并没有接受过专门的训练。他特别指出,测试旨在显示一个人是否具有所谓的心智理论--能够理论化或衡量他人的心理状态。以这个简单的例子为例。爱丽丝把她的眼镜放在抽屉里。然后鲍勃,在爱丽丝不知道的情况下,把眼镜藏在一个垫子下面。爱丽丝会先去哪里找她的眼镜?一个被问到这个问题的孩子正在接受测试,看他们是否理解爱丽丝有自己的信念,而这些信念可能与孩子的认知不一致。

Agüera y Arcas在用谷歌的另一个名为 "对话应用的语言模型"(LaMDA)的LLM进行实验时,发现LaMDA在这种类型的更长时间的对话中反应正确。在他看来,这表明LLM有能力对他人的意图进行内部建模。Agüera y Arcas说:"这些除了预测序列之外什么都不做的模型发展了一系列非凡的能力,包括心智理论"(见 "心智理论")。但他承认这些模型容易出错,而且他也不确定仅靠缩放是否足以进行可靠的推理,尽管它似乎是必要的。

思维理论?

华盛顿州西雅图谷歌研究院的Blaise Agüera y Arcas在博客中谈到了他与谷歌的大型语言模型之一LaMDA的对话。Agüera y Arcas认为这是一个令人印象深刻的交流,在这个交流中,LaMDA似乎能够持续地模拟故事中的两个对话者知道什么和不知道什么--模仿一个明显的思维理论。

Source: Blaise Agüera y Arcas.

然而,即使法学硕士得到了正确的答案,也没有涉及到理解,Chollet说。"当你试图稍微探究一下,就会立刻发现这一切都是空的。ChatGPT没有它正在谈论的模型,"他说。"你在看一场木偶戏,并相信木偶是活的。"

新墨西哥州圣菲研究所研究人工智能系统的概念抽象和类比制作的梅兰妮-米切尔(Melanie Mitchell)说,到目前为止,LLM仍然会犯人类永远不会犯的荒谬错误。这促使人们对在没有护栏的情况下向社会释放LLM的安全性产生了许多担忧。

米切尔补充说,关于LLMs是否能够解决真正的新的、看不见的问题的辩论的一个问题是,我们没有办法全面地测试这种能力。"她说:"我们目前的基准是不够的。"他们没有系统地探测事物。我们还没有真正知道如何做到这一点。" Chollet主张采用他设计的抽象推理测试,称为抽象推理语料库(见图 "更好的人工智能智力测试")。

资料来源:F. Chollet/Lab42 ( https://arc-editor.lab42.global )

规模的问题

在辩论进行的同时,人们已经对大型语言模型的趋势产生了紧迫的担忧。其中一个问题是,训练大型语言模型所涉及的数据集、计算能力和费用限制了它们的发展--因此也限制了它们的研究方向--只有拥有巨大的计算资源的公司才能做到。OpenAI没有确认创建ChatGPT的成本,但其他人根据所涉及的计算估计,预先训练GPT-3(ChatGPT的前身)将花费超过400万美元。由于免费聊天机器人现在所提供的查询数量,OpenAI每个月可能要花费数百万美元来运行ChatGPT。"我们已经深入到这个制度中,"Bubeck说。"只有几家公司的模型大于1000亿个参数。"

各国政府正开始介入,提供可能扩大竞争领域的支持。去年6月,一个由大约1000名学术志愿者组成的国际团队,在法国政府、一家名为Hugging Face的美国人工智能公司和其他机构的资助下,用价值700万美元的计算时间(文献8),训练了一个名为BLOOM的模型,参数约为1750亿。而在11月,美国能源部将超级计算时间授予了里什和她的同事的一个项目,以建立大型模型来研究它们的行为。"我们希望训练一个类似Chinchilla的700亿个参数的模型--不一定是最大的,而是性能扩展更有效的模型,"里什说。

无论谁来建造它们,LLMs也引起了对电力消耗的关注。例如,谷歌报告说,在大约两个月的时间里,培训PaLM花费了大约3.4千兆瓦时。这相当于大约300个美国家庭一年的能源消耗。谷歌在其俄克拉荷马州的数据中心对PaLM进行了培训,它说该中心的运行使用了89%的无碳能源,主要由风能和其他可再生能源提供动力。但是,对行业人工智能模型的调查显示,大多数的训练都是使用主要由化石燃料供电的电网(文献9)。

Chollet担心的是,随着多家公司开始训练和使用更大的模型,它们可能开始吸走更多的电力。"他说:"每个大的科技公司现在都会试图将LLMs部署到他们的产品中,不管这是否是一个好主意。

更聪明和更小?

因此,对于许多科学家来说,迫切需要减少LLM的能耗--使神经网络更小、更高效,以及也许更智能。除了训练LLM的能源成本(虽然很可观,但也是一次性的),推理所需的能源--其中LLM回答查询--会随着用户数量的增加而激增。大型科技公司没有对其模型的使用成本进行评论。然而,Hugging Face透露,当它的BLOOM模型在谷歌云平台上部署了18天,在此期间它回答了230,768个查询(比ChatGPT少很多,后者在2月份达到了每月1亿活跃用户),它平均消耗了1,664瓦特(文献10)。

作为比较,我们自己的大脑比任何LLM都要复杂和大得多,有860亿个神经元和大约100万亿个突触连接。瑞士巴塞尔弗里德里希-米舍尔生物医学研究所的弗里德曼-泽克说,然而,人脑消耗的功率大约在20到50瓦之间。

因此,一些研究人员希望,模仿大脑的某些方面将有助于LLMs和其他神经网络变得更小、更智能、更高效。

大脑整体智能和效率的一个来源可能是它的复发性,或反馈连接。LLMs本质上是 "前馈 "网络。这意味着信息是单向流动的:从输入端,通过LLM的各层,到输出端。大脑的线路是不同的。例如,在人类的视觉系统中,神经元将首先接收视觉信息的大脑区域连接到更远的区域。但也有反馈连接,使信息在神经元之间以相反的方向传递。米切尔说:"在[人类]视觉系统中,反馈连接的数量可能是前馈连接的十倍,"但LLM没有反馈连接。

同时包含前馈和反馈连接的人工神经网络一般被称为递归神经网络(RNN)。这种网络(与前馈的LLM不同)可以辨别出数据中随时间变化的模式。纽约市西奈山伊坎医学院的计算神经科学家卡纳卡-拉詹(Kanaka Rajan)说,这是 "所有自然智能体如何体验世界和学习的根本"。但RNN也有挑战,拉詹说。例如,它们很难训练,而且速度很慢,因此很难将它们扩展到目前LLMs的规模。

大脑高效的另一个原因是,生物神经元大多保持安静--它们只有偶尔的尖峰活动。相比之下,大多数神经网络中的人工神经元被模拟为不断地在活动。研究人员正在研究尖峰的人工神经元(模仿真实的神经元),但很难将训练标准神经网络的算法适应于使用尖峰神经元的网络。不过,使用小型数据集的研究(例如,用于训练识别口语数字的网络的10,000个音频记录)已经表明,具有尖峰神经元的RNN胜过具有标准神经元的RNN,而且在理论上,其计算效率要高三个数量级(文献11)。"在阿姆斯特丹国家数学和计算机科学研究所(CWI)从事该领域工作的Sander Bohté说:"进展迅速,令人印象深刻。

然而,只要这种尖峰网络只是在软件中模拟,它们就不能提供真正的效率提升(因为模拟它们的硬件仍然会消耗能量)。这样的计算元素需要被内置到硬件中,在神经形态芯片上,以实现其好处。

高能效的LLMs

与此同时,研究人员正在试验不同的方法,使现有的LLM更加节能,更加智能。2021年12月,DeepMind报告了一个名为RETRO的系统,该系统将LLM与一个外部数据库相结合。LLM在推理过程中使用从这个数据库中检索的相关文本来帮助它进行预测。DeepMind的研究人员表明,一个75亿个参数的LLM,加上一个2万亿个代币的数据库,胜过参数多25倍的LLM(文献12)。研究人员写道,这是一个 "在我们寻求建立更强大的语言模型时,比原始参数扩展更有效的方法"。

在同一个月,谷歌研究院的科学家们报告了另一种在规模上提高能源效率的方法。他们的通用语言模型,即GLaM,有1.2万亿个参数(文献13)。但这些参数并不代表一个巨大的神经网络;在内部,它们分布在64个较小的神经网络之间,与其他层一起。LLM经过训练,在推理过程中,它只使用两个网络来完成任务;总的来说,LLM在推理中只使用了其一万多亿总参数的8%。据谷歌称,GLaM使用的计算资源与训练GPT-3所需的相同,但由于训练软件和硬件的改进,只消耗了约三分之一的功率。在推理过程中,GLaM使用的计算资源是GPT-3的一半。而且,在相同数量的数据上进行训练时,它的表现优于GPT-3。

然而,为了进一步改进,即使是这些更节能的LLMs似乎也注定要变得更大,占用更多的数据和计算。研究人员将注意观察随着规模的扩大会出现哪些新的行为。"它是否会完全解锁推理,我不确定,"布贝克说。"没有人知道。"

Nature 615, 202-205 (2023)

doi: https://doi.org/10.1038/d41586-023-00641-w

参考文献

-

Frieder, S. et al. Preprint at https://arxiv.org/abs/2301.13867 (2023).

-

Lewkowycz, A. et al. Preprint at https://arxiv.org/abs/2206.14858 (2022).

-

Chowdhery, A. et al. Preprint at https://arxiv.org/abs/2204.02311 (2022).

-

Kaplan, J. et al. Preprint at https://arxiv.org/abs/2001.08361 (2020).

-

Hoffmann, J. et al. Preprint at https://arxiv.org/abs/2203.15556 (2022).

-

Caballero, E. et al. Preprint at https://arxiv.org/abs/2210.14891 (2022).

-

Bubeck, S. et al. Preprint at https://arxiv.org/abs/2105.12806 (2021).

-

Le Scao, T. et al. Preprint at https://arxiv.org/abs/2211.05100 (2022).

-

Luccioni, A. S. & Hernandez-Garcia, A. Preprint at https://arxiv.org/abs/2302.08476 (2023).

-

Luccioni, A. S., Viguier, S. & Ligozat, A.-L. Preprint at https://arxiv.org/abs/2211.02001 (2022).

-

Yin, B. et al. Nature Mach. Intell. 3, 905–913 (2021).

-

Borgeaud, S. et al. Preprint at https://arxiv.org/abs/2112.04426 (2021).

-

Du, N. et al. Preprint at https://arxiv.org/abs/2112.06905 (2021).

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢