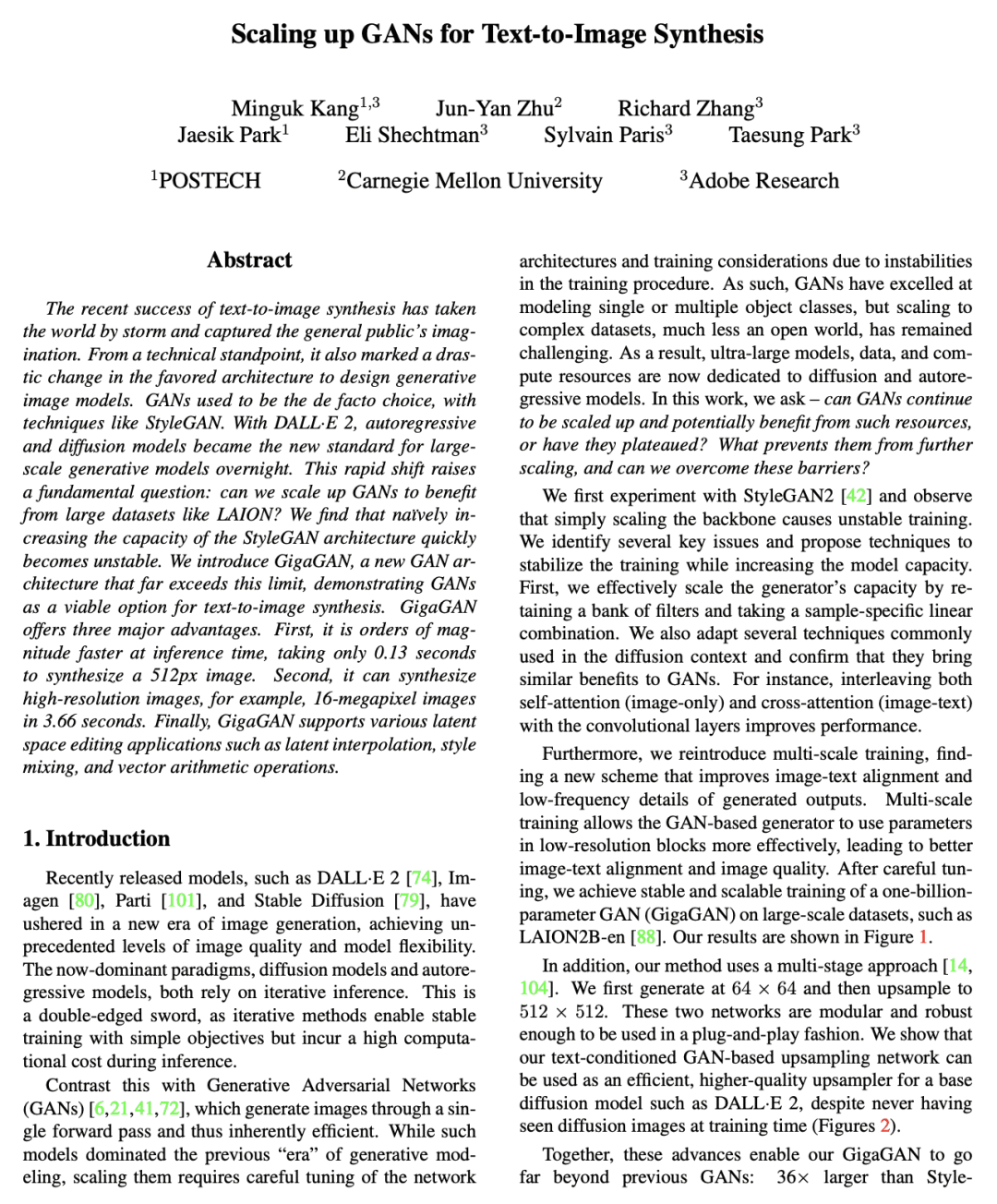

GigaGAN 是一种新的 GAN 架构,能实现文本到图像合成,支持潜空间编辑,并且在推理时间上比之前的方法快几个数量级。

Scaling up GANs for Text-to-Image Synthesis

Minguk Kang, Jun-Yan Zhu,Richard Zhang,E Shechtman, S Paris, T Park

[POSTECH & CMU & Adobe Research]

文本到图像合成GAN的规模提升

要点:

-

GAN曾经是生成式图像模型首选的架构,但随着 DALL-E 2 的发布自回归和扩散模型成了新标准;

-

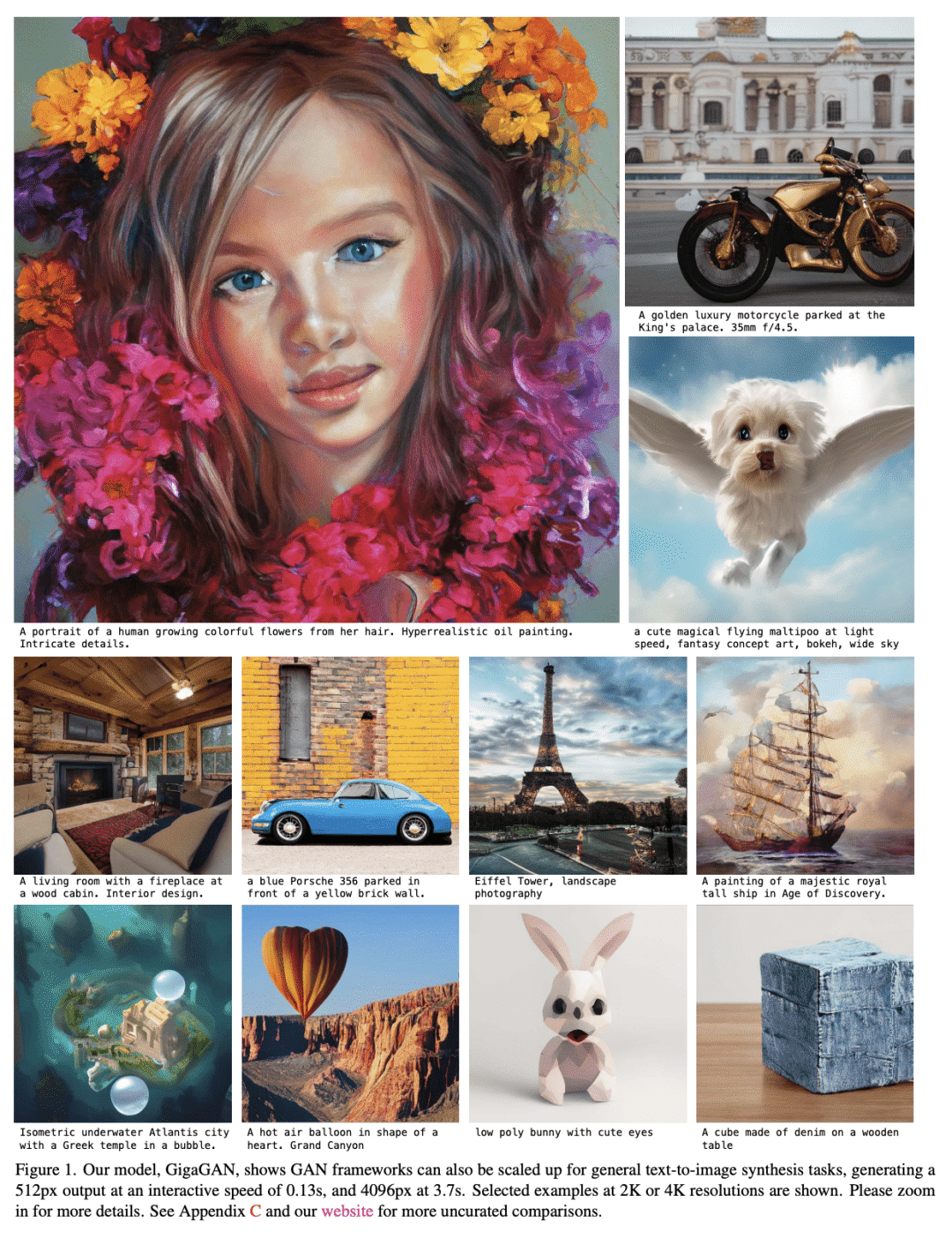

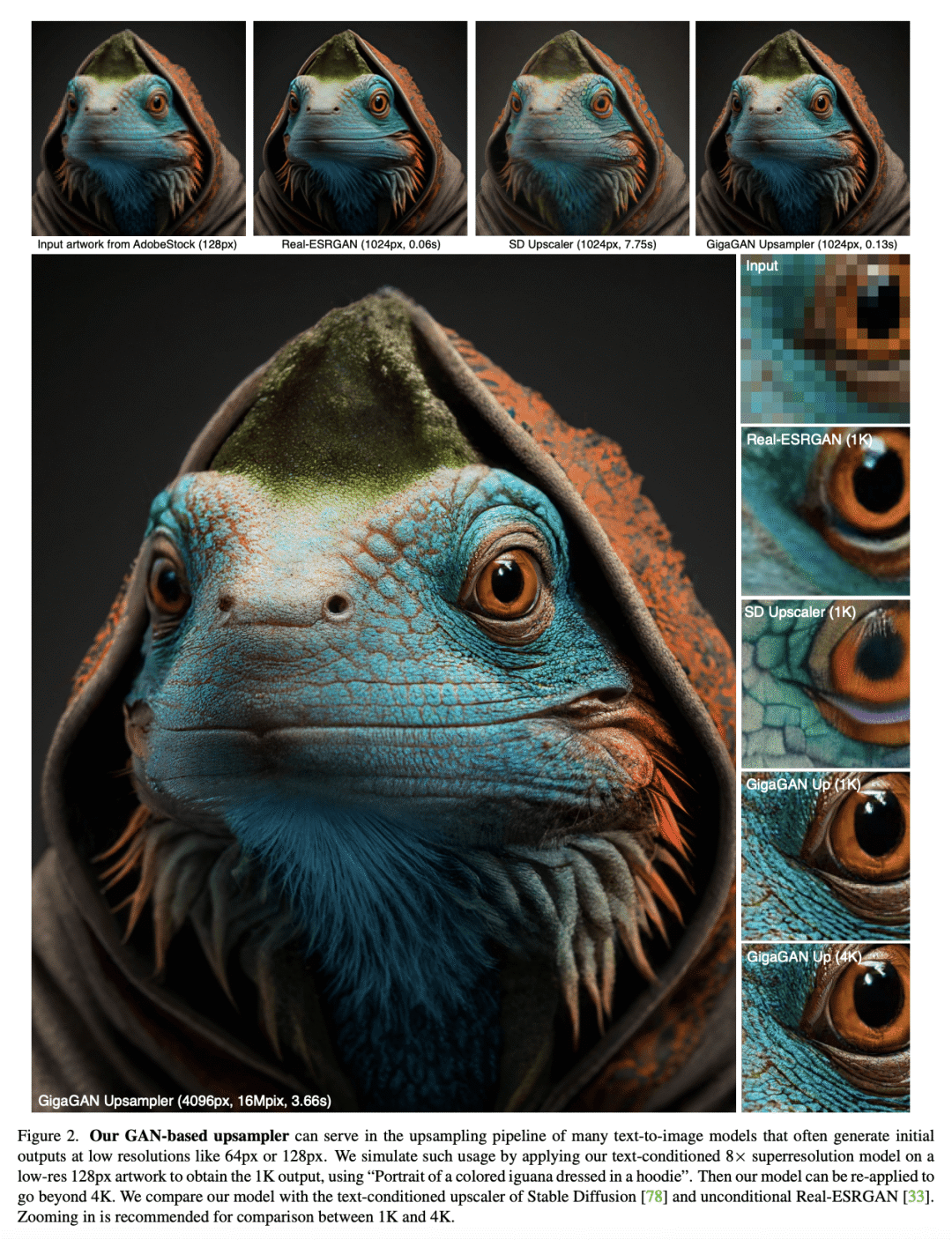

GigaGAN 是一种新的 GAN 架构,可以扩展到实现文本到图像合成的模型规模,并具有三大优势:更快的推理时间、高分辨率的图像合成和潜空间编辑;

-

虽然 GigaGAN 结果的视觉质量还不能与 DALL-E 2 等产品级模型相提并论,但 GigaGAN 已经取得了与自回归和扩散模型相竞争的视觉质量,同时速度快了几个数量级;

-

GigaGAN 为大规模生成模型开辟了一个全新的设计空间,并带来了关键的编辑功能,这些功能在向自回归和扩散模型过渡时变得很有挑战性。

https://arxiv.org/abs/2303.05511

值得注意的是,CycleGAN 的主要作者、曾获 2018 年 ACM SIGGRAPH 最佳博士论文奖的朱俊彦是这篇 CVPR 论文的第二作者。

该研究首先使用 StyleGAN2 进行实验,并观察到简单地扩展主干网络会导致训练不稳定。基于此,研究者确定了几个关键问题,并提出了一种在增加模型容量的同时稳定训练的技术。

首先,该研究通过保留一组滤波器(filter)并采用特定于样本的线性组合来有效地扩展生成器的容量。该研究还采用了扩散上下文(diffusion context)中常用的几种技术,并证实它们为 GAN 带来了类似的好处。例如,将自注意力(仅图像)和交叉注意力(图像 - 文本)与卷积层交织在一起可以提高模型性能。

该研究还重新引入了多尺度训练,并提出一种新方案来改进图像 - 文本对齐和生成输出的低频细节。多尺度训练允许基于 GAN 的生成器更有效地使用低分辨率块中的参数,从而实现了更好的图像 - 文本对齐和图像质量。经过仔细调整后,该研究提出了十亿参数的新模型 GigaGAN,并在大型数据集(例如 LAION2B-en)上实现了稳定和可扩展的训练

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢