论文地址:https://arxiv.org/abs/2303.05510

开源代码:https://github.com/shunzh/Code-AI-Tree-Search

项目网址:https://codeaimcts.github.io/

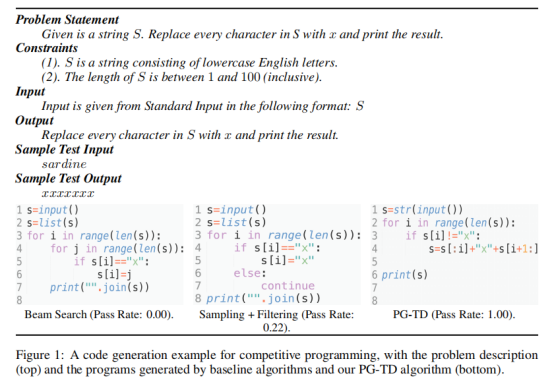

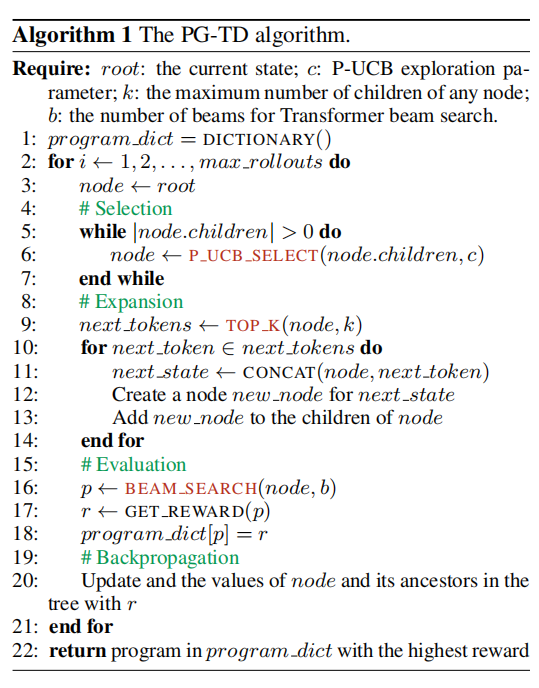

目前基于大语言模型的代码生成框架均依赖解码过程中的搜索或采样算法。尽管这一框架生成的执行程序能够产生较好的Token匹配成绩,但其最终输出却可能是错误的。主要的原因是已有的Transformer解码算法并不是代码生成的最佳选择。因此,文本提出了 Planning-Guided Transformer Decoding算法,该算法利用规划(Planning)算法引导解码阶段的搜索,并约束Transformer生成更精准的可执行程序。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢