【推荐理由】OpenICL是一款全新的开源工具包,用于上下文学习和LLM评估。支持各种最先进的检索和推理方法、任务和零/少样本评估LLM。

标题:OpenICL: An Open-Source Framework for In-context Learning

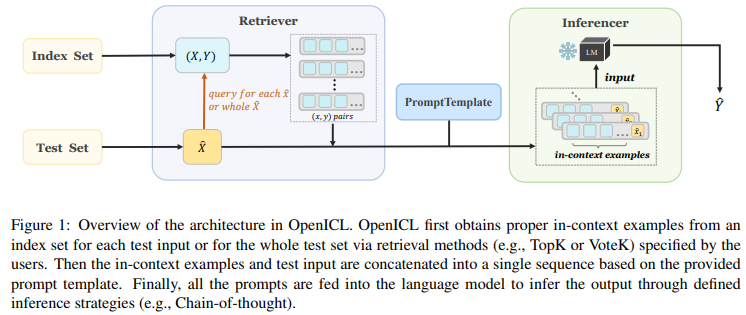

作者:Zhenyu Wu, Yaoxiang Wang, Jiacheng Ye, Jiangtao Feng, Jingjing Xu, Yu Qiao, Zhiyong Wu

[Shanghai AI Laboratory & East China Normal University & Xiamen University & The University of Hong Kong.]

论文链接:https://arxiv.org/pdf/2303.02913.pdf

项目链接:https://github.com/Shark-NLP/OpenICL

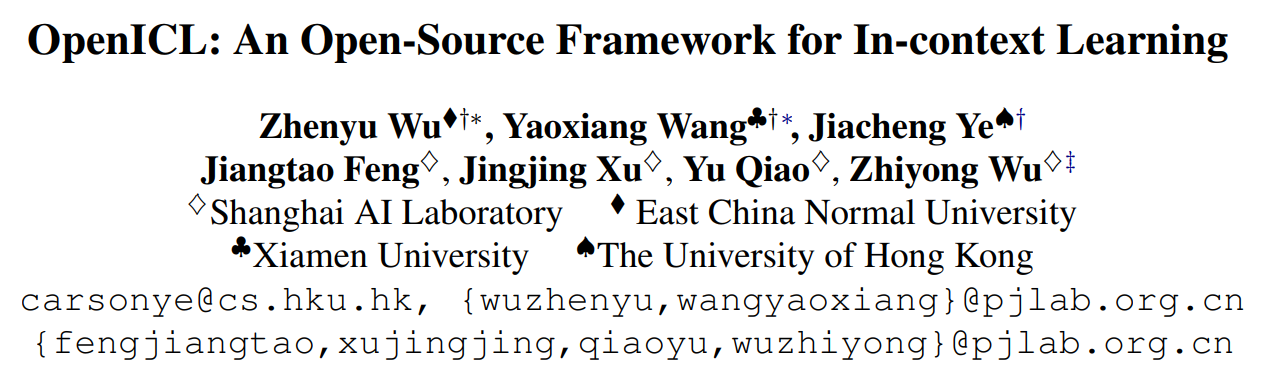

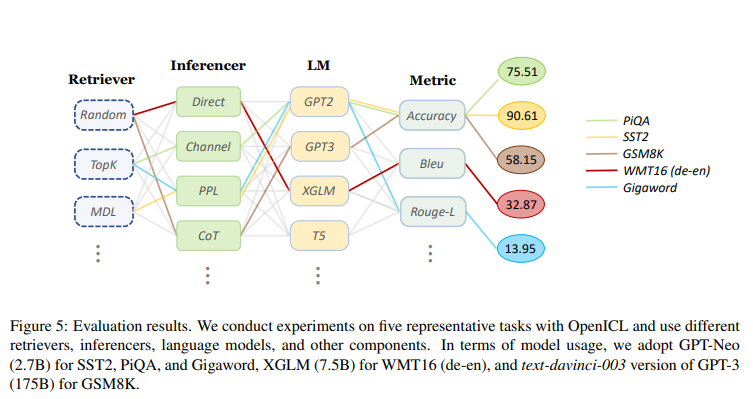

近年来,上下文学习(ICL)已经引起越来越多的关注,并成为大型语言模型(LLM)评估的新范式。与传统的微调方法不同,ICL通过适应预训练模型来处理未见过的任务,而无需进行任何参数更新。然而,由于涉及各种不同的检索和推理方法,以及不同模型、数据集和任务的各种不同的预处理要求,ICL的实现十分复杂。需要一个统一而灵活的ICL框架,以简化上述组件的实现。为了促进ICL研究,本文介绍了OpenICL,一个用于ICL和LLM评估的开源工具包。OpenICL具有高度灵活的架构,用户可以轻松地组合不同的组件来满足自己的需求。它还提供了各种最先进的检索和推理方法,以简化将ICL适应到前沿研究的过程。OpenICL的有效性已经在广泛的NLP任务上得到了验证,包括分类、问答、机器翻译和语义解析。作为一个附带产品,OpenICL是一种高效而稳健的LLM评估工具。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢