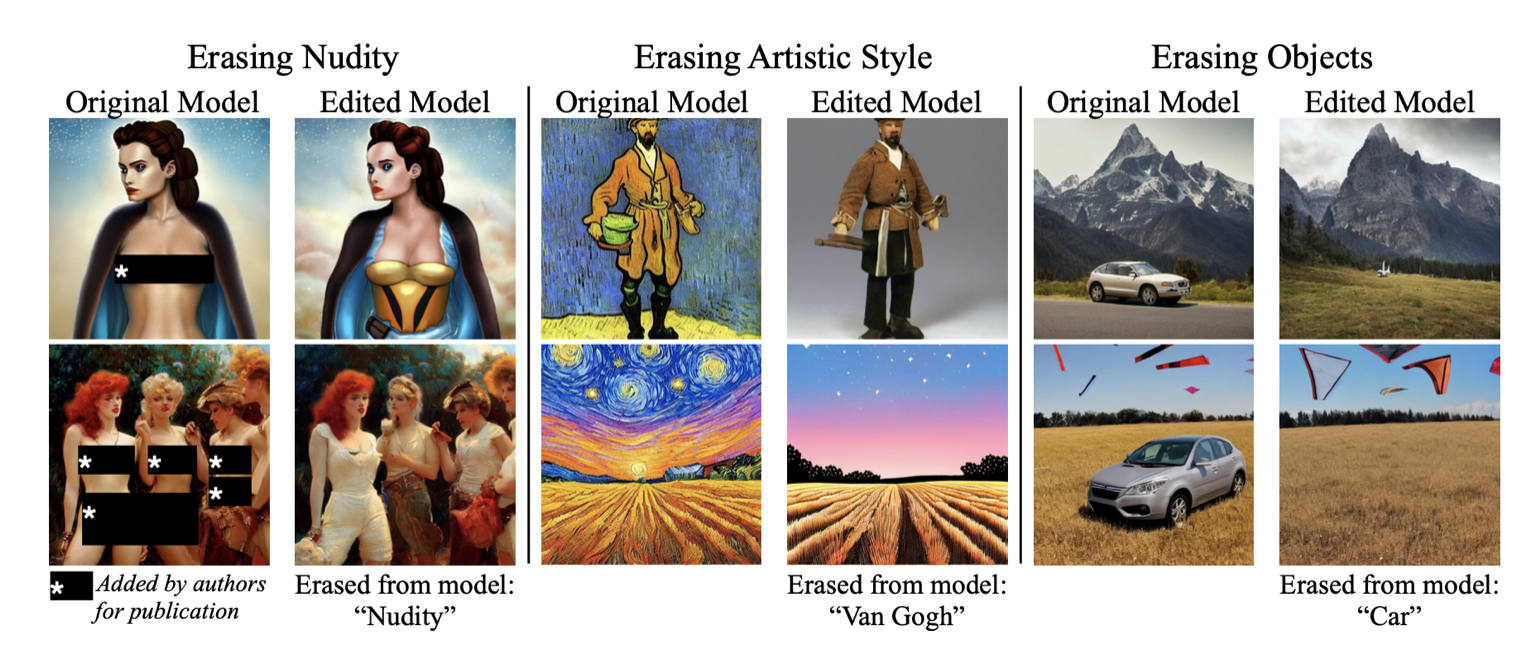

一种可以从预先训练好的扩散模型中抹去一个视觉概念的微调方法,只给出风格的名称,并使用负面的指导作为老师。

Erasing Concepts from Diffusion Models

Rohit Gandikota, Joanna Materzynska, Jaden Fiotto-Kaufman, David Bau

[Northeastern University & Massachusetts Institute of Technology]

项目地址:https://erasing.baulab.info

论文地址:https://arxiv.org/pdf/2303.07345.pdf

代码地址:https://github.com/rohitgandikota/erasing

在文本到图像扩散的最新进展的激励下,本文研究了从模型的权重中抹去特定概念的问题。虽然 "稳定扩散 "在产生明确或现实的艺术作品方面显示出良好的前景,但它也引起了人们对其滥用潜力的关注。

文章提出了一种微调方法,可以从预先训练好的扩散模型中抹去一个视觉概念,只给出风格的名称,并使用负面的指导作为老师。

将文中方法与之前去除性内容的方法进行比较,并证明其有效性,与安全潜伏扩散和删减训练的表现相当。为了评估艺术风格的去除,进行了实验,将五位现代艺术家从网络中删除,并进行了一项用户研究,以评估人类对被删除风格的感知。与以前的方法不同,该方法可以永久地从扩散模型中删除概念,而不是在推理时修改输出,因此,即使用户能够获得模型的权重,也无法规避它。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢