随着Stable Diffusion的开源,用自然语言进行图像生成也逐渐普及,许多AIGC的问题也暴露了出来,比如AI不会画手、无法理解动作关系、很难控制物体的位置等。其主要原因还是在于「输入接口」只有自然语言,无法做到对画面的精细控制。

威斯康星大学麦迪逊分校、哥伦比亚大学和微软的研究热源提出了一个全新的方法GLIGEN,以grounding输入为条件,对现有「预训练文本到图像扩散模型」的功能进行扩展。

论文链接:https://arxiv.org/pdf/2301.07093.pdf

项目主页:https://gligen.github.io/

体验链接:https://huggingface.co/spaces/gligen/demo

“以一个类似于 NLP 领域 transformer-adapter 的 parameter efficient 的思路来微调 Stable-Diffusion 模型(即固定已有模型的参数,只训练在模型里额外添加的组件),并成功使得 SD 模型可以参考 bounding box 的位置信息,来对不同实体进行生成 ”。

这篇论文里的放出了可运行的 demo,效果得到了实证。知乎上的 NLP 算法工程师 中森 在认为这篇论文论证了“已有的预训练文生图大模型的高度可拓展性,并且在开源模型上添加各种模态控制信息做继续训练的高度可行性”。https://zhuanlan.zhihu.com/p/605761756

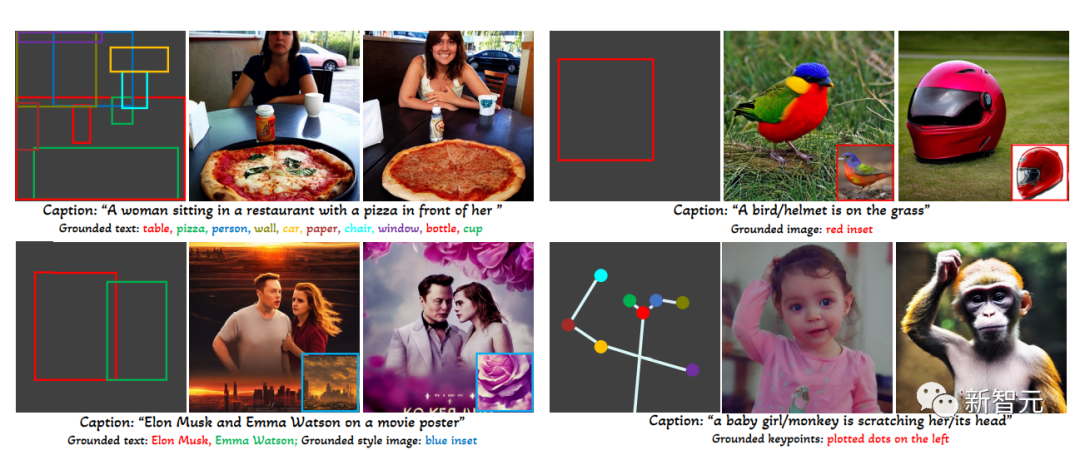

为了保留预训练模型的大量概念知识,研究人员没有选择对模型进行微调,而是通过门控机制将输入的不同grounding条件注入到新的可训练层中,以实现对开放世界图像生成的控制。目前GLIGEN支持四种输入。

1. 提出了一种新的text2img生成方法,赋予了现有text2img扩散模型新的grounding可控性;

2. 通过保留预训练的权重和学习逐渐整合新的定位层,该模型实现了开放世界的grounded text2img生成与边界框输入,即综合了训练中未观察到的新的定位概念;

3. 该模型在layout2img任务上的zero-shot性能明显优于之前的最先进水平,证明了大型预训练生成模型可以提高下游任务的性能。

(左上)文本实体+box (右上)图像实体+box

(左下)图像风格+文本+box (右下)文本实体+关键点

实验结果也显示,GLIGEN 在 COCO 和 LVIS 上的zero-shot性能大大优于目前有监督layout-to-image基线。

更多文章阅读:

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢