ChatGPT爆火让大家对于基础模型所展示的强大能力,例如思维链(Chain of Thought)等涌现能力产生了极大的兴趣,并且这种范式的转变已经从NLP领域蔓延到了整个AI领域,大家在关注这些模型训练成本昂贵、难以使用等问题的同时也对其产生的社会影响展开了广泛研究。

斯坦福基础模型研究中心发布的报告《On the Opportunities and Risks of Foundation Models》对相关问题进行了深入的分析和研究,在得到斯坦福团队的授权之后,开放城市共同体实验室完成了这份报告的翻译。

标题:基础模型的机遇与风险

作者:斯坦福大学以人为本人工智能研究院基础模型研究中心CRFM

[1] 我们采用“基础模型”来描述这些模型的未完成但是非常重要的状态,更多关于名称的讨论请参见1.1.1命名。

[2] 有趣的是,自监督学习在深度学习的早期占主导地位[Hinton 等人 2006],但随着标记数据集变得越来越大,十年来基本上被监督学习所取代。

[3] Collobert和Weston [2008]的先见之明是相关的:他们训练了一个可扩展的任务,类似于与下游任务一起进行掩蔽语言建模,而不是产生一个可以在事后适应下游任务的单一基础模型。

[4] https://blog.google/products/search/search-language-understanding-bert/

[5] https://copilot.github.com/

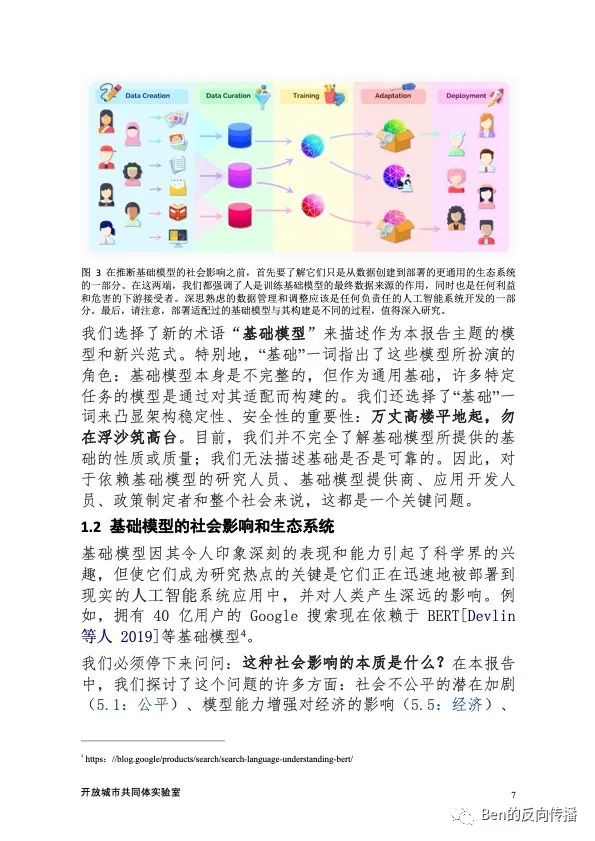

[6] 在实践中,生态系统的最后是监控机制,得到的反馈用于重新调整之前的阶段。

[7] 一个基础模型 (例如 Codex) 在训练时以另一个基础模型 (例如 GPT-3) 为起点。

[8] 参见https://www.gatesfoundation.org/about/our-role.

[9] 参见https://paperswithcode.com/rc2020

[10] 参见https://worksheets.codalab.org/

[11] https://www.eleuther.ai/

[12] https://bigscience.huggingface.co/

[13] https://hai.stanford.edu/policy/national-research-cloud

[14] 这个社区导致了 Center for Research on Foundation Models (CRFM) 的建立, 它是斯坦福大学 Human-Centered AI 研究所 (HAI) 的一项新的跨学科计划。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢