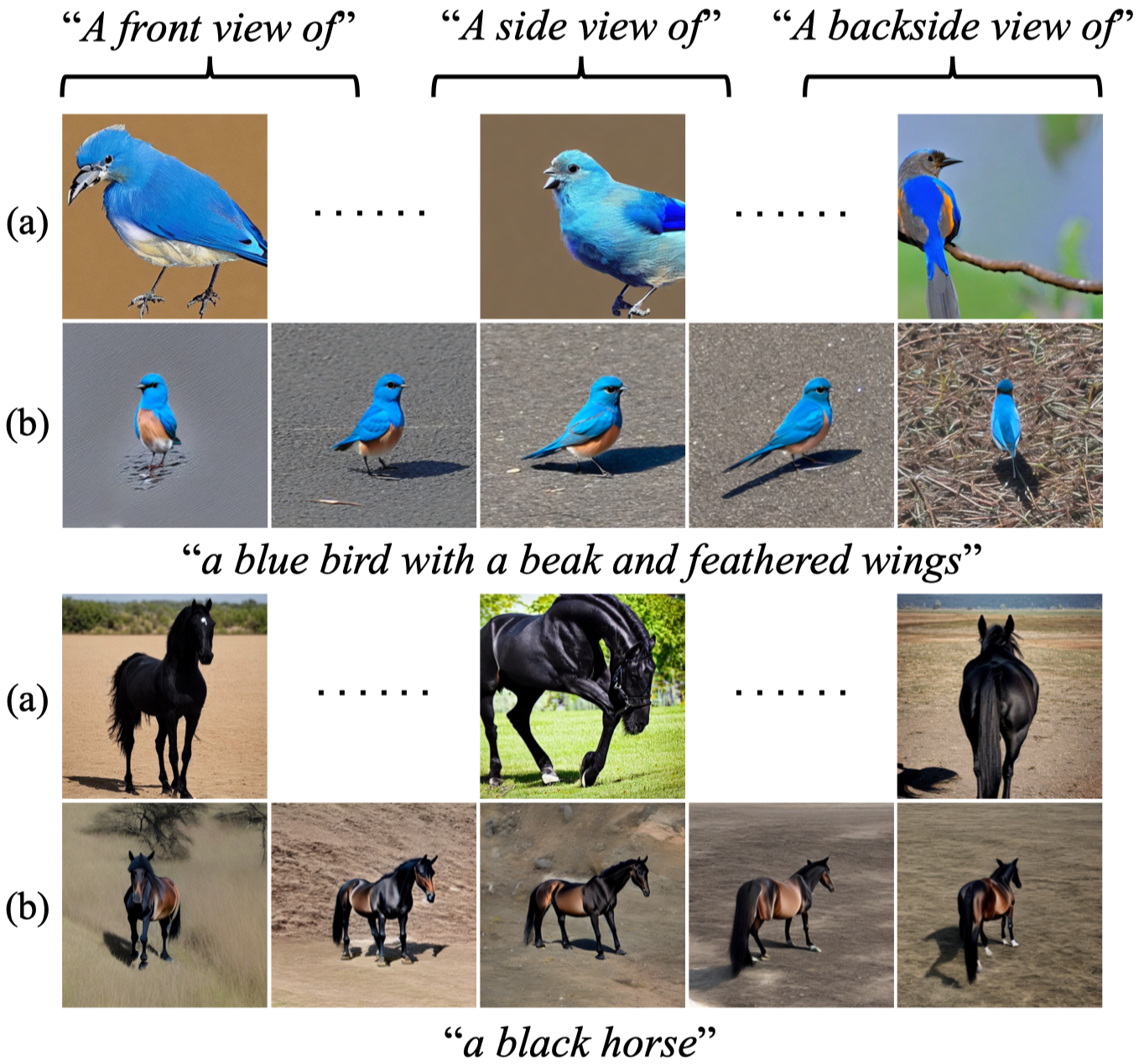

文本到3D数据的生成近年来随着扩散模型的发展取得了较大的突破,其主要的流程框架是利用预训练的文本到图像数据扩散模型以零样本学习的方式优化神经辐射场。然而,文本到图像数据的扩散模型仅对2D一致性有所建模,对于3D数据中的空间分布缺乏学习,从而造成了生成数据的不真实问题。因此,本文提出3DFuse框架,将3D空间中分布规律的一致性映射到预训练的2D扩散模型中。这一做法首先需要生成一个初步的3D数据结构,并利用多视角深度图进行扩散模型的条件生成。此外,本文提出了一个学习策略以使得2D扩散模型能够都3D空间中多视角的误差进行耦合和训练。

论文地址:https://arxiv.org/abs/2303.07937

开源代码:https://github.com/KU-CVLAB/3DFuse

项目地址:https://ku-cvlab.github.io/3DFuse/

作者: Wooseok Jang,Min-Seop Kwak, Jaehoon Ko, Hyeonsu Kim, Junho Kim, Jin-Hwa Kim, Jiyoung Lee, Seungryong Kim.

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢