作者:学生研究员 Antoine Yang 和 Google Research 感知团队研究科学家 Arsha Nagrani

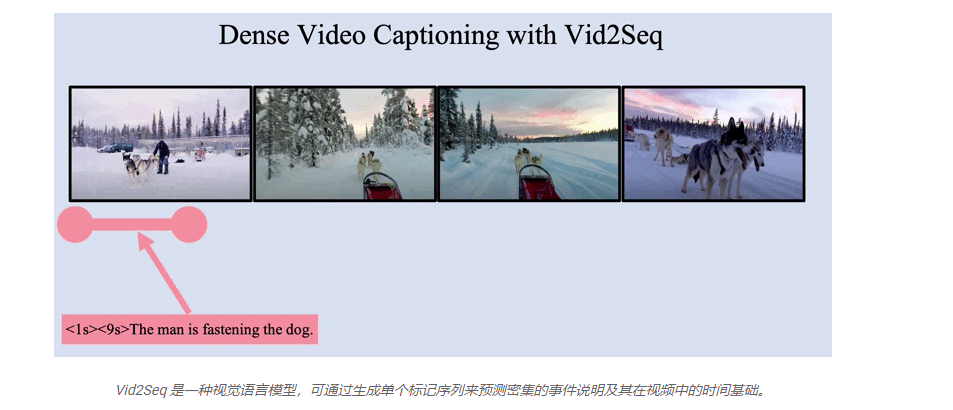

视频已经成为我们日常生活中越来越重要的一部分,跨越娱乐、教育和通信等领域。然而,理解视频的内容是一项具有挑战性的任务,因为视频通常包含在不同时间尺度发生的多个事件。例如,一个雪橇手将狗拴在狗拉雪橇上然后它们都跑掉的视频涉及一个长事件(狗拉雪橇)和一个短事件(狗被拴在雪橇上)。促进视频理解研究的一种方法是通过密集视频字幕任务,该任务包括在一分钟长的视频中对所有事件进行时间定位和描述。这不同于单图像字幕和标准视频字幕,其中包括用一个句子描述短视频。

密集视频字幕系统具有广泛的应用,例如使有视觉或听觉障碍的人可以访问视频,自动生成视频章节,或改进大型数据库中视频时刻的搜索。然而,当前的密集视频字幕方法有一些局限性——例如,它们通常包含高度专业化的特定于任务的组件,这使得将它们集成到强大的基础模型中具有挑战性。此外,他们通常专门在手动注释的数据集上进行训练,这些数据集很难获得,因此不是可扩展的解决方案。

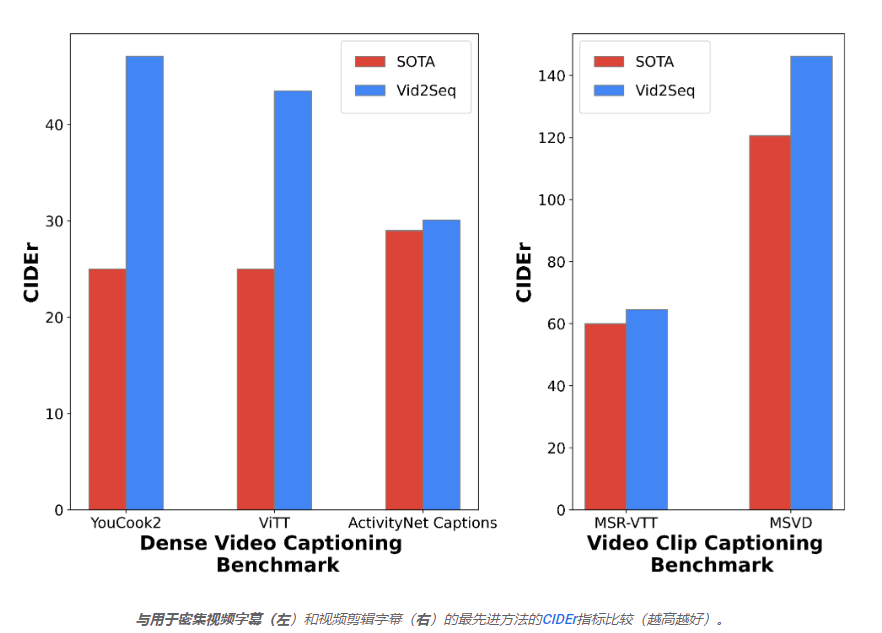

在这篇文章中,我们介绍了“ Vid2Seq:用于密集视频字幕的视觉语言模型的大规模预训练”,将出现在CVPR 2023上。Vid2Seq 架构通过特殊时间标记增强了语言模型,使其能够无缝预测同一输出序列中的事件边界和文本描述。为了预训练这个统一模型,我们通过将转录语音的句子边界重新表述为伪事件边界,并将转录的语音句子用作伪事件说明来利用未标记的叙述视频。生成的 Vid2Seq 模型在数百万个叙述视频上进行了预训练,改进了各种密集视频字幕基准(包括YouCook2)的最新技术水平、ViTT和ActivityNet 字幕。Vid2Seq 还可以很好地泛化到少镜头密集视频字幕设置、视频段落字幕任务和标准视频字幕任务。最后,我们还在这里发布了 Vid2Seq 的代码。

用于密集视频字幕的视觉语言模型

多模态变换器架构改进了各种视频任务的最新技术水平,例如动作识别。然而,要使这种架构适应在长达数分钟的视频中联合定位和字幕事件的复杂任务并不简单。为了大致了解我们如何实现这一目标,我们使用特殊时间标记(如文本标记)来增强视觉语言模型,这些时间标记表示视频中的离散时间戳,类似于空间域中的Pix2Seq 。给定视觉输入,生成的 Vid2Seq 模型既可以作为输入,也可以生成文本和时间标记序列。首先,这使 Vid2Seq 模型能够理解转录语音输入的时间信息,该输入被转换为单个标记序列。其次,这允许 Vid2Seq 联合预测密集的事件字幕,并在生成单个标记序列的 同时将它们暂时置于视频中。Vid2Seq 架构包括一个视觉编码器和一个文本编码器,它们分别对视频帧和转录的语音输入进行编码。然后将生成的编码转发到文本解码器,该解码器自回归预测密集事件字幕的输出序列及其在视频中的时间定位。该体系结构使用强大的视觉主干和强大的语言模型进行初始化。

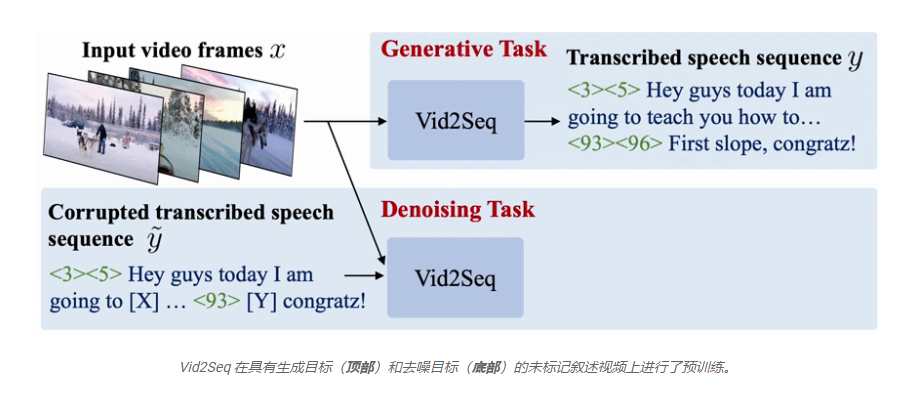

对未修剪的叙述视频进行大规模预训练

由于任务的密集性,手动收集密集视频字幕的注释特别昂贵。因此,我们使用未标记的叙述视频预训练 Vid2Seq 模型,这些视频很容易大规模获得。特别是,我们使用YT-Temporal-1B数据集,其中包括 1800 万个涵盖广泛领域的解说视频。我们使用转录的语音句子及其相应的时间戳作为监督,将其转换为单个标记序列。我们使用生成目标预训练 Vid2Seq,该目标教导解码器仅在给定视觉输入的情况下预测转录的语音序列,以及通过要求模型在给定嘈杂的转录语音序列和视觉输入的情况下预测掩码标记来鼓励多模态学习的去噪目标。特别是,通过随机屏蔽标记的跨度,将噪声添加到语音序列中。

下游密集视频字幕基准的结果

生成的预训练 Vid2Seq 模型可以通过使用教师强制的 简单最大似然目标在下游任务上进行微调(即,在给定先前的真实标记的情况下预测下一个标记)。经过微调后,Vid2Seq 在三个标准下游密集视频字幕基准( ActivityNet Captions、YouCook2和ViTT)和两个视频剪辑字幕基准(MSR-VTT、MSVD )上显着提高了技术水平。在我们的论文中,我们提供了额外的消融研究、定性结果,以及少数镜头设置和视频段落字幕任务中的结果。

结论

我们介绍了 Vid2Seq,这是一种用于密集视频字幕的新型视觉语言模型,它可以简单地将所有事件边界和字幕预测为单个标记序列。Vid2Seq 可以大规模地对未标记的叙述视频进行有效预训练,并在各种下游密集视频字幕基准测试中取得最先进的结果。从论文中了解更多信息并在此处获取代码。

致谢

这项研究由 Antoine Yang、Arsha Nagrani、Paul Hongsuck Seo、Antoine Miech、Jordi Pont-Tuset、Ivan Laptev、Josef Sivic 和 Cordelia Schmid 进行。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢