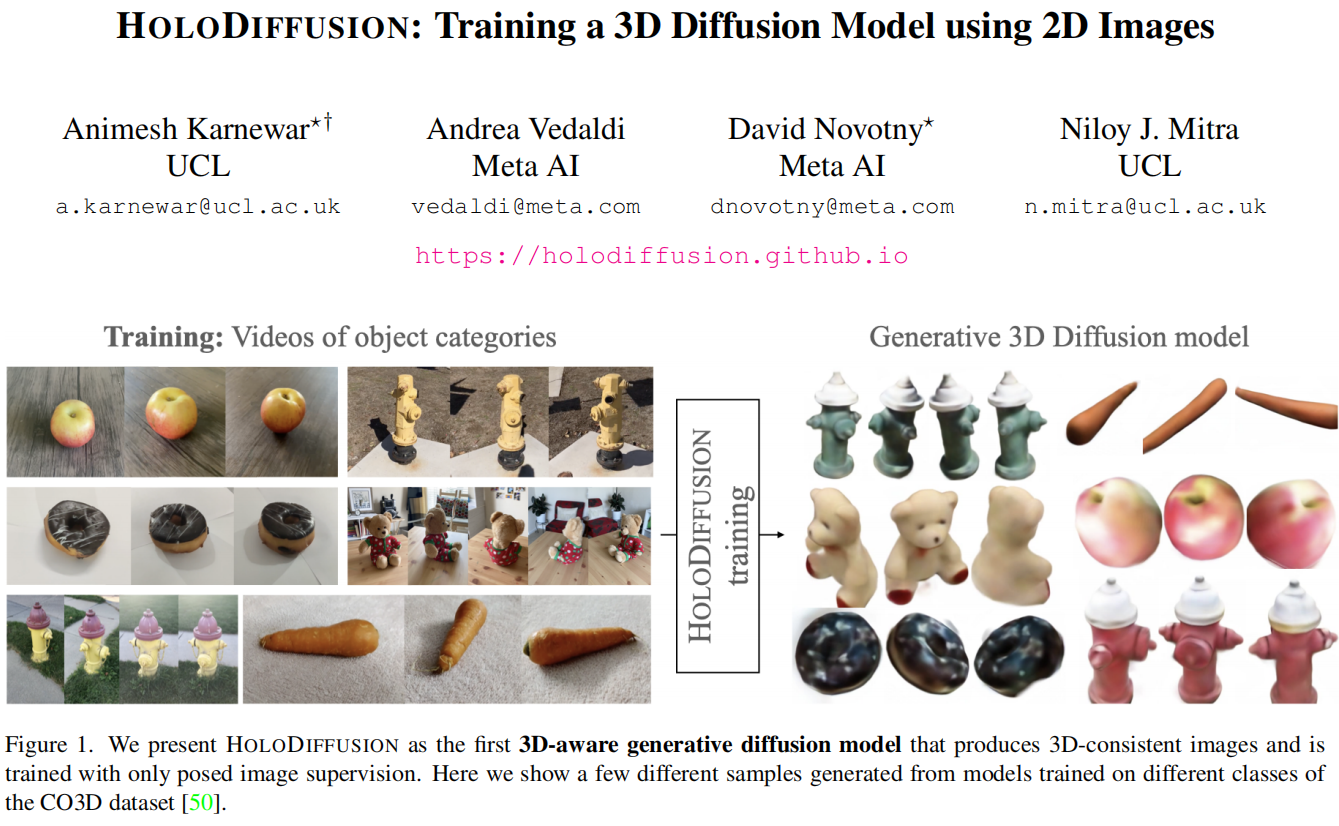

扩散模型已成为生成2D图像的最佳方法。它们的成功部分原因在于可以在稳定的学习目标下对数百万甚至数十亿张图像进行训练。然而,将这些模型扩展到3D仍然有两个困难。首先,相对于2D图像,找到大量的3D训练数据要复杂得多。其次,虽然将模型从2D网格扩展到3D的概念上很容易,但相关的内存和计算复杂性的立方增长使此过程不可行。本文通过引入一个新的扩散设置来解决第一个挑战,该设置可以使用姿势确定的2D图像进行端到端训练;并且通过提出一个图像生成模型来将模型内存与空间内存分离来解决第二个挑战。本文使用之前没有用于训练3D生成模型的CO3D数据集在真实世界数据上评估本文的方法。本文展示了本文的扩散模型具有可扩展性,可以稳健地训练,并且在样本质量和保真度方面与现有的3D生成建模方法相媲美。

标题:HOLODIFFUSION: Training a 3D Diffusion Model using 2D Images

作者:Animesh Karnewar, Andrea Vedaldi, David Novotny, Niloy Mitra

论文:https://papers.labml.ai/api/v1/redirect/pdf?paper_key=3c34f1fece9511edb95839eec3084ddd

平台:https://holodiffusion.github.io/

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢