【推荐理由】本文将一种新颖的图像标记化方案应用于Vision Transformer,其中图像的低显著性区域以低分辨率处理,将更多的模型容量路由到重要的图像区域,实现了显著的图像分类精度提高。

Vision Transformers with Mixed-Resolution Tokenization

Tomer Ronen, Omer Levy(Roberta的作者), Avram Golbert

[Tel Aviv University & Google Research]

【论文链接】https://arxiv.org/pdf/2304.00287.pdf

【项目链接】https://github.com/TomerRonen34/mixed-resolution-vit

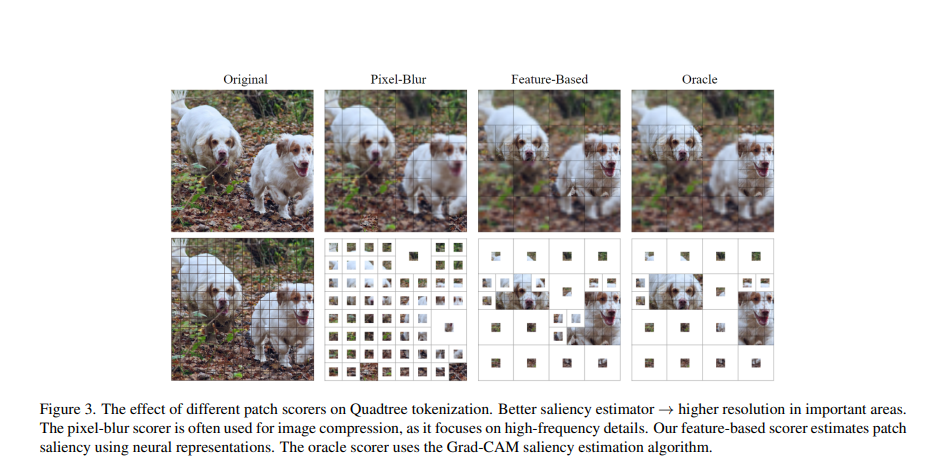

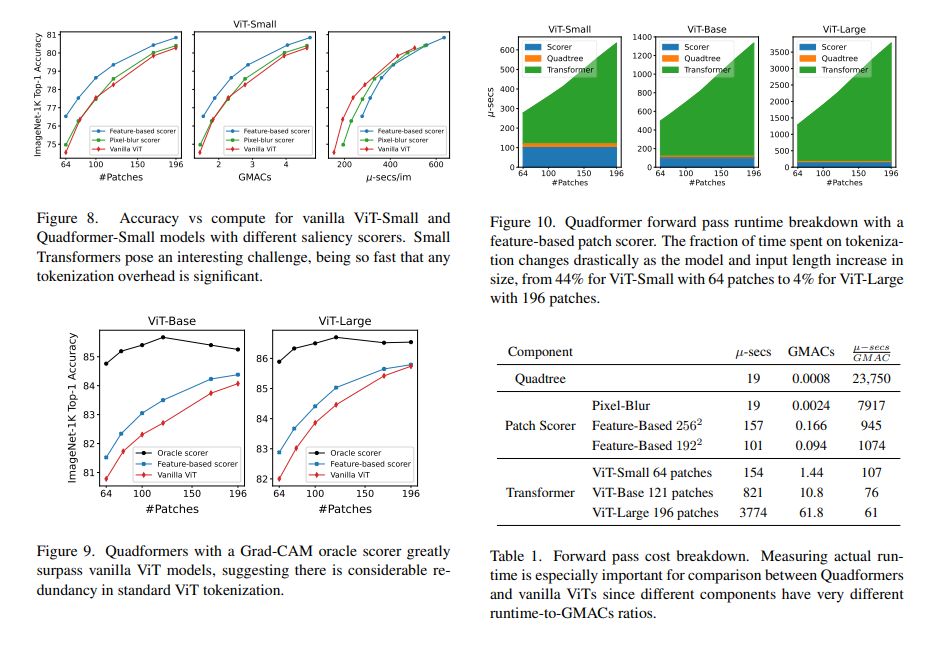

【摘要】Vision Transformer模型通过将输入图像分成一个空间规则的、相等大小的块网格来处理。相反,Transformer最初是针对自然语言序列引入的,其中每个标记代表一个子词——任意大小的原始数据块。在这项工作中,我们通过引入一种新颖的图像标记化方案来将此方法应用于Vision Transformer,用一个混合分辨率的标记序列取代标准的均匀网格,其中每个标记代表一个任意大小的块。使用Quadtree算法和一种新颖的显著性评分器,我们构建了一个mask,其中图像的低显著性区域以低分辨率处理,将更多的模型容量路由到重要的图像区域。使用与vanilla ViTs相同的架构,我们的Quadformer模型在控制计算预算时实现了显著的图像分类精度提高。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢