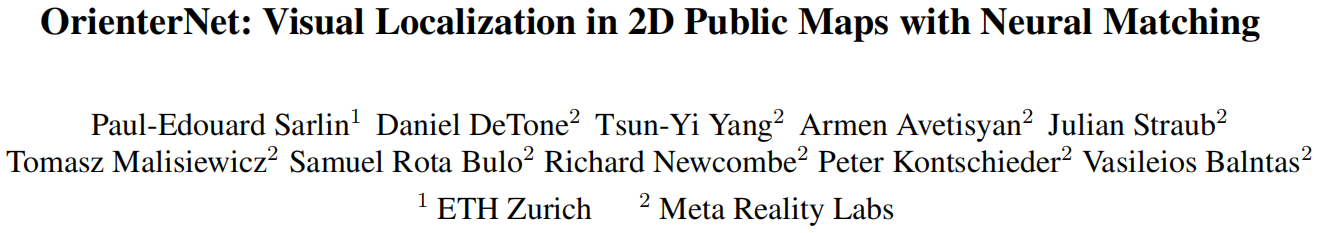

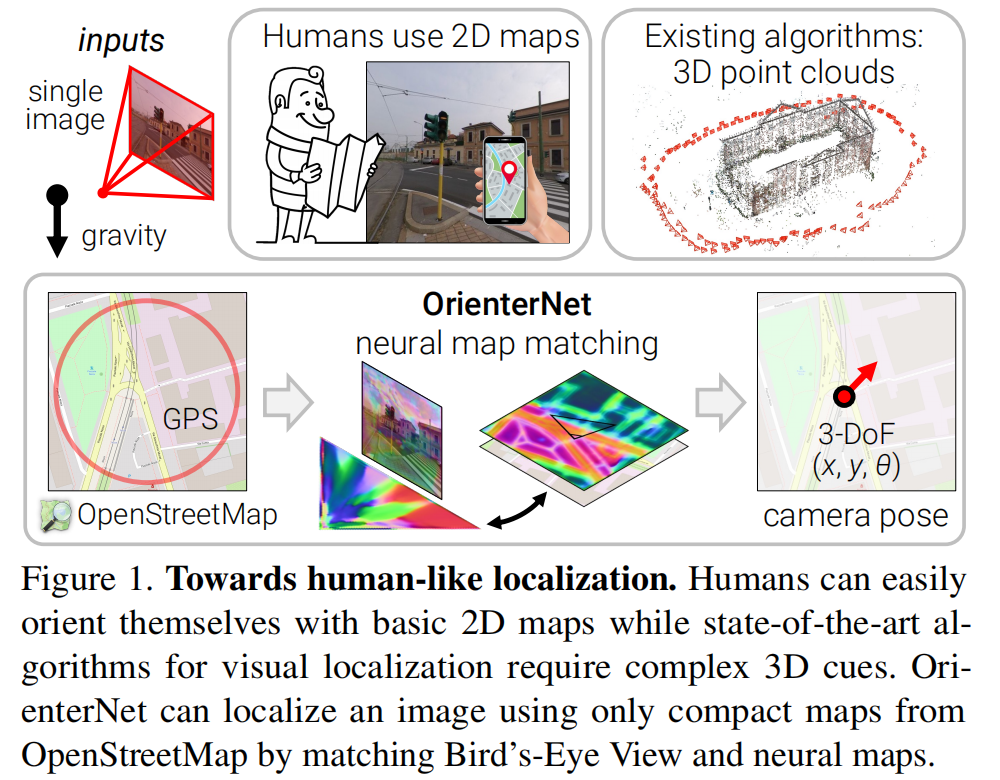

人类可以使用简单的2D地图在3D环境中定位自己。然而,现有的视觉定位算法 mostly 都依赖于昂贵的、难以建立、存储和维护的3D点云。我们通过引入 OrienterNet 填补了这一差距,它是第一个使用与人类一样的2D语义地图,能够准确地定位图像的深度神经网络,并具有亚米级的精度。OrienterNet通过将神经鸟瞰图与开放的、全球可用的OpenStreetMap地图进行匹配,估计查询图像的位置和方向,从而使任何人都可以在提供这些地图的任何地方定位。OrienterNet仅由相机姿态进行监督,但学习了以端到端的方式执行语义匹配的各种地图元素。为了实现这一点,我们介绍了一个大型的众包数据集,涵盖了从车、自行车和行人不同视角拍摄的12个城市的图像。OrienterNet可以推广到新的数据集,并推动机器人和AR场景的最新技术。代码和训练好的模型将公开发布。

总结:

本文提出了一种利用神经网络进行2D地图上视觉定位的方法——OrienterNet。该方法通过将地图上的局部信息转化为图像,并使用深度神经网络进行匹配和定位。此外,本文还提出了一种基于图优化的后处理方法来进一步提高定位的准确性。在多个公共数据集上进行的实验表明,OrienterNet在2D地图上实现了高速、高精度的定位,并比现有方法表现更好。

标题:OrienterNet: Visual Localization in 2D Public Maps with Neural Matching

作者:Paul-Edouard Sarlin, Daniel DeTone, Tsun-Yi Yang, Armen Avetisyan, Julian Straub, Tomasz Malisiewicz, Samuel Rota Bulo, Richard Newcombe, Peter Kontschieder, Vasileios Balntas

评论

沙发等你来抢