GPT-4等基础模型推动了人工智能的快速改进。然而,最强大的模型是封闭式商业模型或只是部分开放模型。RedPajama是一个创建一组领先的、完全开源模型的项目。今天,我们很高兴地宣布该项目的第一步已经完成:复制超过1.2万亿个令牌的LLaMA培训数据集。

当今最有能力的基金会模型被关闭在商业API后面,这限制了研究、定制及其与敏感数据的使用。如果开放社区能够缩小开放和封闭模型之间的质量差距,完全开源模型有望消除这些限制。最近,这方面取得了很大进展。在许多方面,人工智能正在经历其Linux时刻。稳定的扩散表明,开源不仅可以与DALL-E等商业产品的质量相媲美,还可以从世界各地社区的广泛参与中获得令人难以置信的创造力。随着最近发布的LLaMA、Alpaca、Vicuna和Koala等半开放模型,以及Pythia、OpenChatKit、Open Assistant和Dolly等全开放模型,围绕大型语言模型开始了类似的运动。

我们正在推出RedPajama,努力制作一个可复制的、完全开放的、领先的语言模型。RedPajama是Together、Ontocord.ai、ETH DS3Lab、Stanford CRFM、Hazy Research和MILA Québec AI Institute之间的合作。RedPajama有三个关键组成部分:

-

培训前数据,既需要高质量又具有广泛的覆盖范围

-

基于这些数据进行大规模训练的基本模型

-

指令调优数据和模型,改进了基本模型,使其可用和安全

今天,我们发布了第一个组件,训练前数据。

“RedPajama基础数据集是按照LLaMA论文中描述的配方创建的1.2万亿个令牌完全开放数据集。”

我们的出发点是LLaMA,它是领先的开放基础模型套件,原因有二:首先,LLaMA接受了非常大的(1.2万亿个令牌)数据集的培训,该数据集经过仔细过滤以获得质量。其次,70亿参数LLaMA模型的训练时间要长得多,远远超出了Chincilla最优点,以确保该模型尺寸的最佳质量。70亿参数模型对开放社区特别有价值,因为它可以在各种GPU上运行,包括许多消费级GPU。然而,LLaMA及其所有衍生物(包括羊驼、维库纳和考拉)仅用于非商业研究目的。我们的目标是创建LLaMA的完全开源复制,可用于商业应用,并为研究提供更透明的管道。

RedPajama基础数据集

完整的RedPajama 1.2万亿令牌数据集和更小、更消耗的随机样本可以通过Hugging Face下载。完整的数据集在磁盘上解压缩了~5TB,下载压缩了~3TB。

RedPajama-Data-1T由七个数据片组成:

-

CommonCrawl:五个CommonCrawl转储,使用CCNet管道处理,并通过几个质量过滤器过滤,包括为类似维基百科的页面选择的线性分类器。

-

C4:标准C4数据集

-

GitHub:GitHub数据,按许可证和质量过滤

-

arXiv:去除样板的科学文章

-

书籍:开放书籍的语料库,因内容相似性而重复

-

维基百科:维基百科页面的子集,删除样板

-

StackExchange:StackExchange下流行网站的子集,删除样板

对于每个数据切片,我们都会进行仔细的数据预处理和过滤,并调整质量过滤器,以大致匹配Meta AI在LLaMA论文中报告的令牌数量:

| 红帕贾马 | LLaMA* | |

|---|---|---|

| 通用爬行 | 878亿 | 8520亿 |

| C4 | 175亿 | 1900亿 |

| GitHub | 59亿 | 1000亿 |

| 图书 | 26亿 | 250亿 |

| ArXiv | 280亿 | 330亿 |

| 维基百科 | 24亿 | 250亿 |

| StackExchange | 20亿 | 27亿 |

| 总数 | 1.2万亿 | 1.25万亿 |

*从https://arxiv.org/abs/2302.13971中的表1中估计

我们正在Github上公开提供所有数据预处理和质量过滤器。任何人都可以遵循数据准备配方并复制RedPajama-Data-1T。

交互式分析RedPajama基础数据集

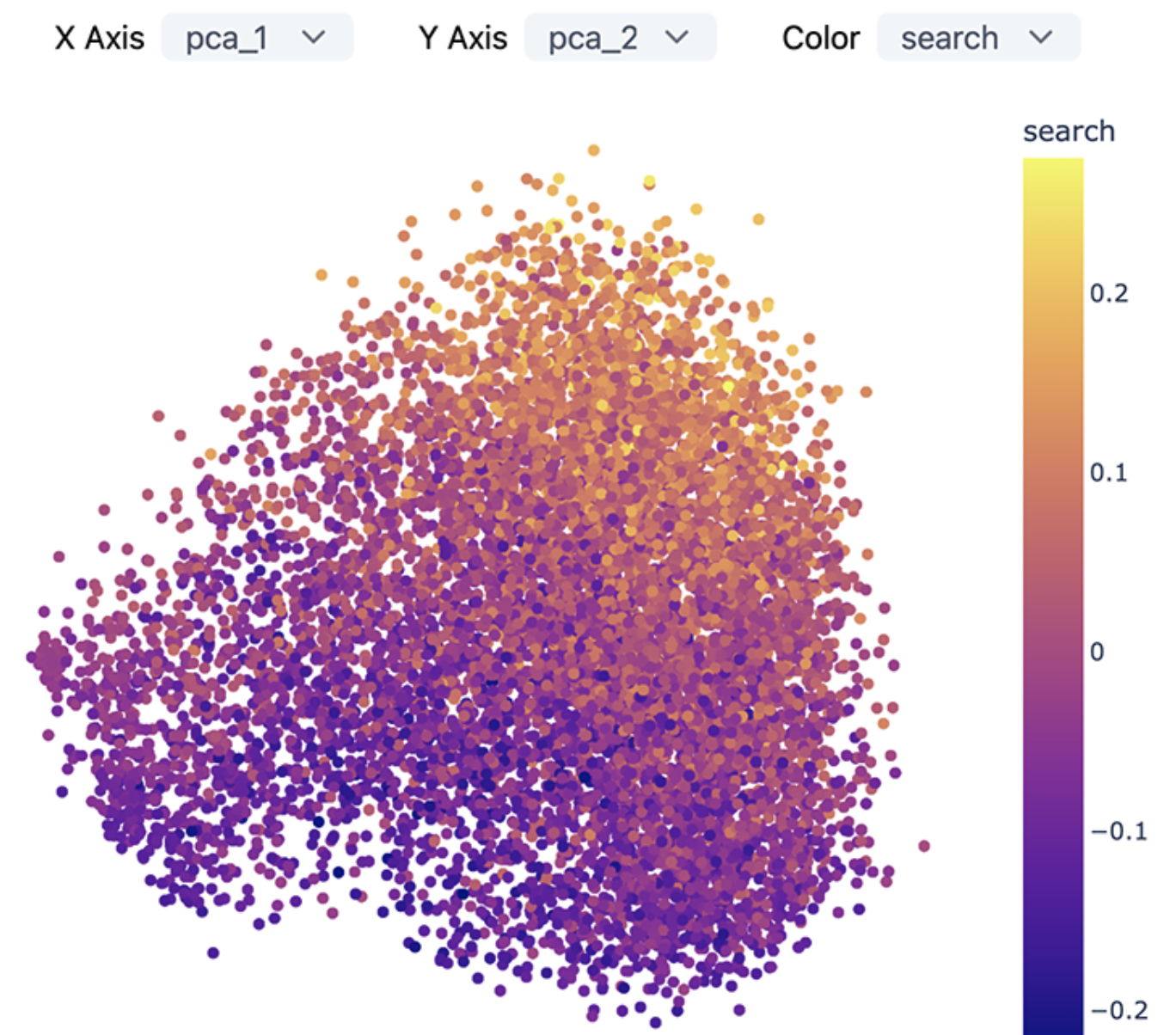

与Meerkat项目合作,我们正在发布Meerkat仪表板和嵌入,用于探索语料库的Github子集。下图显示了仪表板的预览。

您可以在Github上找到有关如何安装和使用仪表板的说明。

下一页:模型、说明和OpenChatKit

在复制了训练前数据后,下一步是训练一个强大的基础模型。作为INCITE计划的一部分,在橡树岭领导力计算设施(OLCF)的支持下,我们正在培训一整套模型,第一批模型将在未来几周内推出。

有了强大的基础模型,我们很高兴能指导调整模型。羊驼展示了指令调优的力量——只需50K高质量、多样化的指令,它就能解锁显著改进的能力。通过OpenChatKit,我们收到了数十万个高质量的自然用户指令,这些指令将用于发布RedPajama模型的指令调整版本。

致谢

我们感谢不断增长的开源人工智能社区所做的工作,这些工作使这个项目成为可能。

这包括:

-

构建RedPajama数据集的参与者包括Ontocord.ai、MILA-魁北克人工智能研究所、ETH DS3Lab、蒙特利尔大学、斯坦福基金会模型研究中心(CRFM)、斯坦福朦雳研究小组和LAION。

-

Meta AI——他们在LLaMA上的鼓舞人心的工作显示了构建强大语言模型的具体路径,它是我们数据集复制的原始来源。

-

EleutherAI——这个项目是在EleutherAI伟大团队的背后建立的——包括他们为培训GPT-NeoX提供的源代码。

-

INCITE程序提供了计算机时间奖。这项研究还使用了橡树岭领导计算设施(OLCF)的资源,该设施是根据DE-AC05-00OR22725合同支持的能源部科学用户设施办公室。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢