Evaluating Verifiability in Generative Search Engines

关于作者:Nelson F. Liu、Tianyi Zhang 和 Percy Liang 分别来自美国加州大学伯克利分校和斯坦福大学。他们都是自然语言处理领域的专家,曾在 ACL、EMNLP、NAACL 等顶级会议上发表过多篇论文,其中 Percy Liang 还获得过 MacArthur Fellowship 等多个奖项。

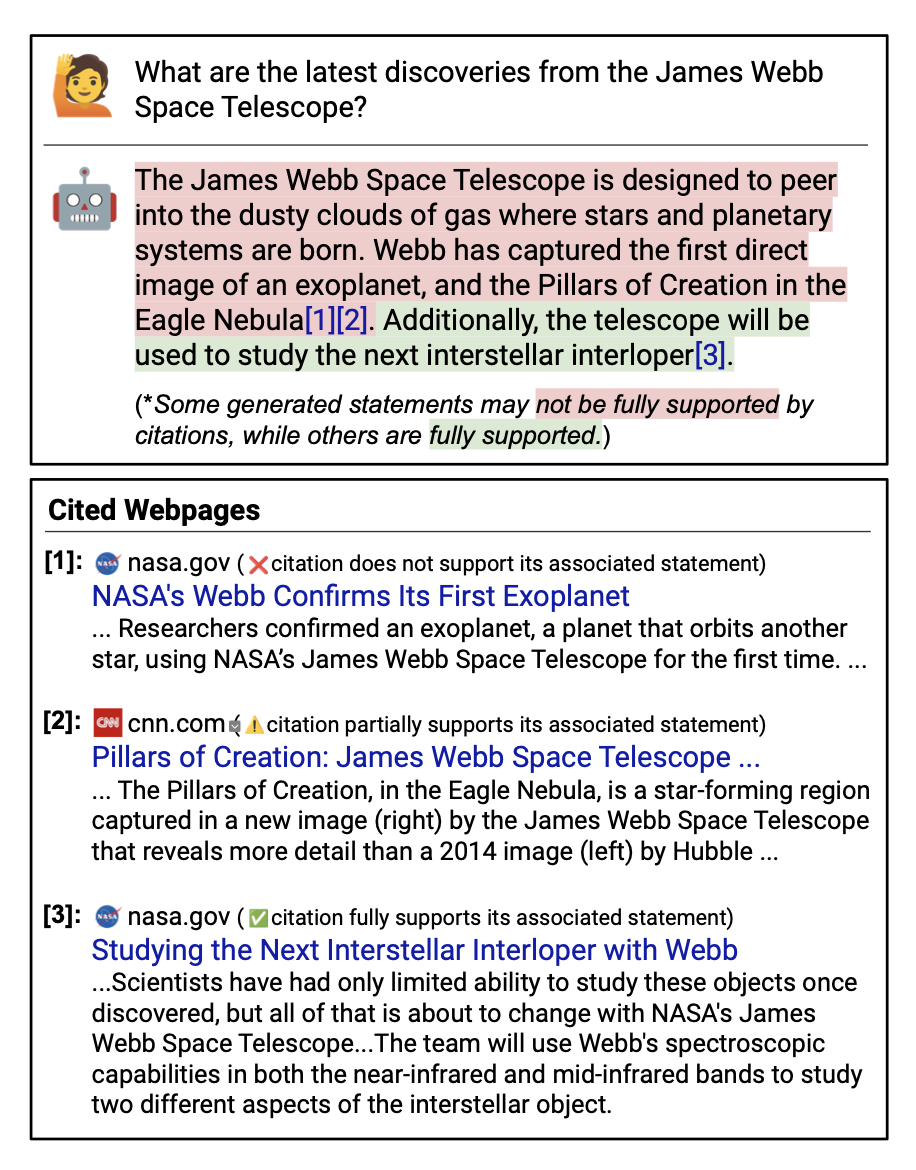

解决问题:本篇论文旨在评估生成式搜索引擎的可验证性问题,即系统是否全面地引用了相关资料,且引用的准确性是否高。这是一个新问题,因为目前还没有研究关注到这个问题。

关键思路:本文通过人类评估的方法,对四种流行的生成式搜索引擎进行了审查,评估了它们在不同来源的查询中的表现。结果发现,现有的生成式搜索引擎的回答流畅且信息丰富,但经常包含不支持的陈述和错误的引用。因此,本文提出了可验证性的问题,并通过人类评估的方法进行了实验,为开发更可靠的生成式搜索引擎提供了启示。

其他亮点:本文的实验设计了多种来源的查询,包括历史 Google 用户查询和 Reddit 上动态收集的开放式问题等,使实验结果更具有代表性。此外,本文还公开了实验数据集,为相关研究提供了参考。

相关研究:

-

"Towards Verifiable Multi-hop Question Answering: A Challenge Dataset and Baselines",作者为 Xinya Du 等,来自纽约大学和微软研究院;

-

"Verifiable Explanation Generation for Natural Language Inference",作者为 Yixin Nie 等,来自加州大学圣地亚哥分校。

论文摘要:本文的研究对象是生成式搜索引擎,这种搜索引擎可以直接生成回答用户问题的结果,并附带引用。一个值得信赖的生成式搜索引擎的前提特征是可验证性,即系统应该全面引用(高引用召回率;所有陈述都应该有引用支持)和准确引用(高引用精度;每个引用都应该支持其相应的陈述)。作者们对四个流行的生成式搜索引擎(Bing Chat、NeevaAI、perplexity.ai和YouChat)进行了人工评估,对来自各种来源(例如历史上的Google用户查询、Reddit上动态收集的开放性问题等)的各种查询进行了审查。

研究发现,现有的生成式搜索引擎的回答流畅且看起来信息量丰富,但是经常包含不支持的陈述和不准确的引用:平均而言,仅有51.5%的生成句子被完全引用支持,仅有74.5%的引用支持其相应的句子。我们认为,这些结果对于可能作为信息寻求用户的主要工具的系统来说,是令人担忧的,特别是考虑到它们的信任外观。我们希望我们的研究结果能够进一步推动值得信赖的生成式搜索引擎的发展,并帮助研究人员和用户更好地了解现有商业系统的缺陷。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢