每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」,本期 Hugging News 有哪些有趣的消息,快来看看吧!

Hugging Chat 来啦!

我们认为需要有一个 ChatGPT 的开源替代品,让好的机器学习大众化,因此,我们推出了 HuggingChat,欢迎你的使用!这个聊天机器人使用了德国非营利组织 LAION.ai 的 Open Assistant 模型。这是一个V.0的版本,但是我们正在努力快速迭代界面和安全机制以支持下一个快速改进的开源模型。

使用 Hugging Chat: hf.co/chat

以及,邀请各位关注 Hugging Face 的小红书账号:

Hugging Face 中文博客正式发布

4 月 20 日(上周),我们成功举办了 Hugging Face 在国内的首次线下活动,邀请了 JAX/Diffusers 社区冲刺的参赛选手以及社区成员们共同交流和探讨了 ControlNet、JAX、Diffusers、Cloud TPU 等技术内容,有 7 支来自北京的参赛队伍代表也来到台前向参会者分享他们的参赛作品,令人印象深刻。

截止彼时,Hugging Face 的中国社区已经成立了五个月,我们也非常高兴的看到 Hugging Face 相关的中文内容在各个平台都广受好评,因此,我们在这次特别的线下活动上正式发布了我们的 Hugging Face 中文博客,欢迎通过 hf.co/blog/zh 来查看。

官宣文章(英文): https://hf.co/blog/chinese-language-blog 官宣文章(中文):https://hf.co/blog/zh/chinese-language-blog

由于公众号文章限制,未来的文章请读者们点击阅读原文到中文博客里体验更完整的文章内容。

社区活动

组队学习:ChatGPT 从入门到应用

我们正联合 Datawhale 团队组织 AIGC 主题学习活动「ChatGPT 从入门到应用」,欢迎大家参加!

开源库更新

Diffusers 0.16 正式发布

0.16.0 版本支持了 DeepFloyd 的 IF 文生图模型和 ControlNet 1.1,IF 的灵感来自 Google 的 Imagen,使用了 SOTA 开源文生图模型,具有高度的真实感和语言理解能力。

查看全部更新内容: https://github.com/huggingface/diffusers/releases/tag/v0.16.0

对了,我们还更新了我们 Diffusers 的文档页面,欢迎来看看: https://hf.co/docs/diffusers/index

PEFT 现已支持 Multi-Adapter 的训练和推理

🤗 PEFT 包含了参数高效的微调方法,用于训练大型预训练模型。通过 PEFT,你可以将不同的 LoRA 权重相结合来做微调和推理。

你还可以通过这个教程了解更多: https://github.com/huggingface/peft/blob/main/docs/source/task_guides/dreambooth_lora.mdx

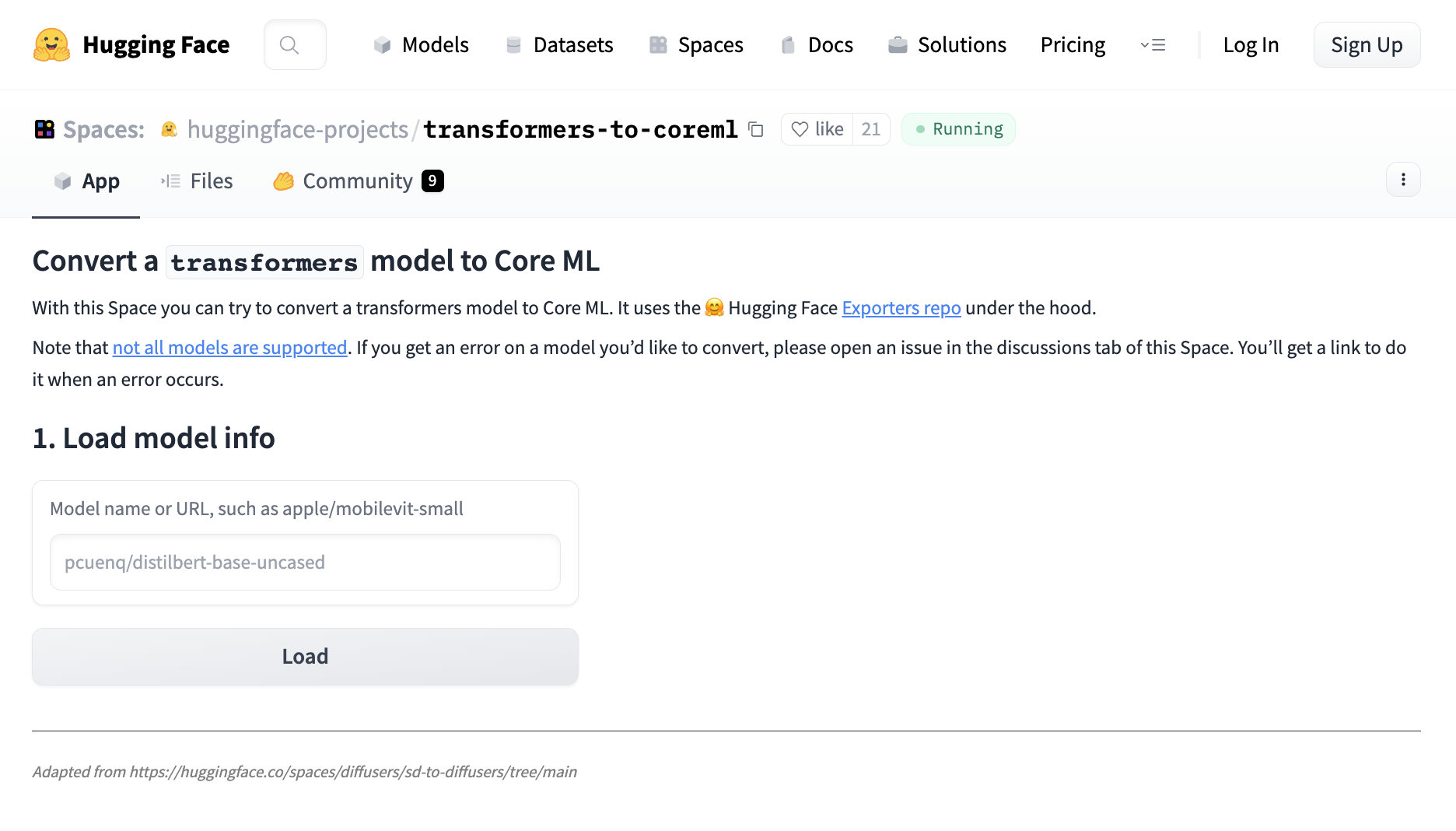

将 transformers 模型转换为 🍎Core ML

将你的 transformers 模型转换为 Core ML,以支持在 iPhone 和 Mac 电脑上运行模型推理!

快来体验吧: https://hf.co/spaces/huggingface-projects/transformers-to-coreml

内容更新

RLHF 实践教程: 训练 LLaMA 模型回答 Stack Exchange 上的问题

我们发布了一篇实践教程类型的博文,教你使用强化学习以及 RLHF 的方法,通过结合有监督微调、奖励/偏好建模和强化学习来训练一个名为 StackLLaMA 的模型来回答 Stack Exchange 上的问题。在 RLHF 过程中,需要从已有的能力模型出发,通过 fine-tuning 来改善模型响应和使用方式的一致性。为了训练庞大的模型,需要采用 Parameter-Efficient Fine-Tuning (PEFT) 技术和数据并行处理等策略。最终在人工反馈下进行强化学习,并通过奖励模型建模评分,以完成模型的训练。

查看博客文章: https://hf.co/blog/stackllama

如何降低模型带来的道德和社会风险问题

Hugging Face 的使命是推动好的机器学习大众化,我们也在研究如何支持机器学习社区的工作,帮助识别危害和防止可能的危害发生。我们正在开发工具并推出一些保障措施,如“不适合所有受众”标签等,我们也推出了一些流程来保证模型和数据的限制、共享和其他机制。

阅读我们的 Hugging Face AI 伦理简报 #3 了解更多。

以上就是本期 Hugging News,预祝各位社区成员们有个愉快的五一假期,我们节后见!

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢