Learning to Reason and Memorize with Self-Notes

通过让模型进行自我记录(taking self-notes)的方式,解决大型语言模型在有限上下文记忆和多步推理方面的问题

本论文试图解决大型语言模型在有限上下文记忆和多步推理方面的问题。作者提出了一种简单的方法,通过允许模型进行自我笔记来解决这两个问题。这种方法可以让模型在阅读上下文的同时,随时离开输入上下文以明确思考,从而扩展其记忆并实现多步推理。

要点:

-

动机:大型语言模型在处理较长或较复杂的输入时,常常会出现上下文记忆不足和多步推理困难的问题。本文提出了一种通过让模型进行自我记录的方式来解决这些问题的方法。 -

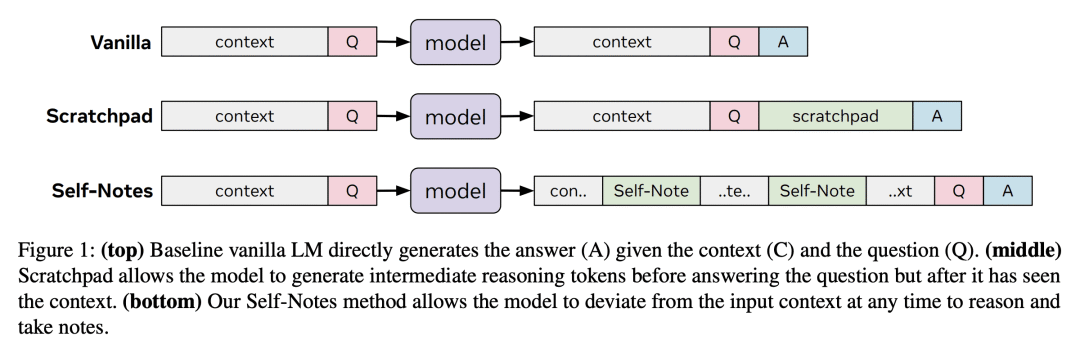

方法:提出一种允许模型在任意时间进行自我记录的方法,这种方法可以让模型在阅读上下文的同时进行信息回忆和推理,从而扩展其记忆并实现多步推理。 -

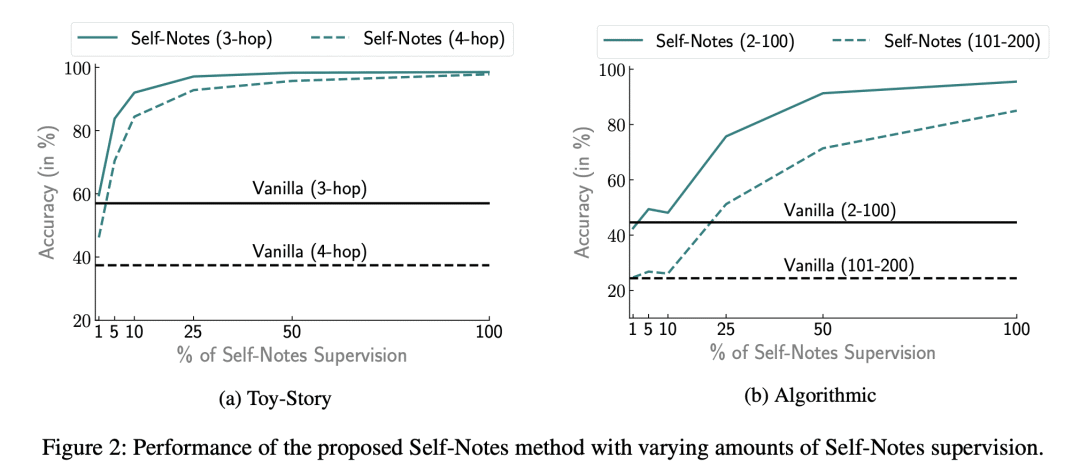

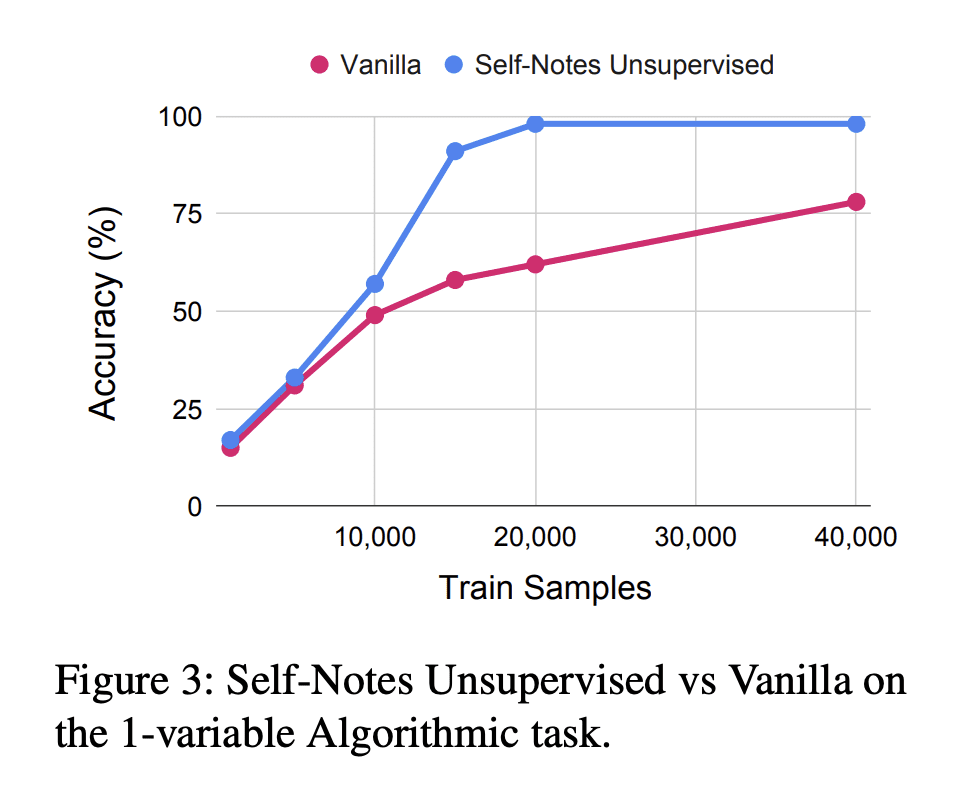

优势:可以帮助语言模型更好地处理长序列或复杂任务,且不需要太多的监督信号。

https://arxiv.org/abs/2305.00833

关键思路:

与最近的草稿板方法不同,本论文中的模型可以随时偏离输入上下文以明确思考。这种方法允许模型在阅读上下文的同时回忆信息并进行推理,从而扩展其记忆并实现多步推理。相比当前领域的研究状况,这篇论文的思路在于通过自我笔记的方式来解决有限上下文记忆和多步推理的问题。

其他亮点:

本论文的实验结果表明,该方法可以成功地推广到更长和更复杂的实例,并通过在推理时进行自我笔记的方式来解决这些实例。作者使用了多个任务来验证该方法的有效性。本论文的代码已经开源,值得进一步研究。

关于作者:

本论文的主要作者是Jack lanchantin、Shubham Toshniwal 、Jason Weston、Arthur Szlam、Sainbayar Sukhbaatar

Jason-weston:Jason是纽约Facebook的研究科学家,也是纽约大学的客座研究教授。Jason还被列为AMiner第16位最有影响力的机器学习学者,也是《科学》中计算机科学前50名作者之一。

在之前的代表作中,Jason Weston曾经提出了一种基于记忆的神经图灵机模型,Arthur Szlam曾经提出了一种基于记忆的神经网络模型,Sainbayar Sukhbaatar曾经提出了一种基于记忆的递归神经网络模型。

相关研究:

"Improving Multi-Step Reasoning with Self-Supervised Dense Graph-to-Sequence Learning",作者:Xiaodong Liu, Chenguang Zhu, Jianfeng Gao,机构:Microsoft Research

- "Memory Augmented Transformer for Multi-hop Question Answering",作者:Zihang Dai, Zhilin Yang, Yiming Yang,机构:Carnegie Mellon University

- "Multi-hop Reading Comprehension through Question Decomposition and Rescoring",作者:Yichen Gong, Samuel R. Bowman,机构:New York University

论文摘要:

我们提出了一种解决限制上下文记忆和多步推理问题的简单方法,即允许模型使用自我笔记。与最近的草稿本方法不同,模型可以随时偏离输入上下文,以明确的方式进行思考。这使得模型能够在阅读上下文时即时地回忆信息并进行推理,从而扩展其记忆并实现多步推理。我们在多个任务上的实验表明,我们的方法可以通过在推理时进行自我笔记来成功地推广到更长和更复杂的实例。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢