InferLLM 是一个非常轻量的 LLM 模型推理框架,主要参考和借鉴了 llama.cpp 工程,llama.cpp 几乎所有核心代码和 kernel 都放在一两个文件中,并且使用了大量的宏,阅读和修改起来都很不方便,对开发者有一定的门槛。InferLLM 主要有以下特点:

- 结构简单,方便上手开发和学习,把框架部分和 Kernel 部分进行了解耦

- 运行高效,将 llama.cpp 中大多数的 kernel 都进行了移植

- 定义了专门的 KVstorage 类型,方便缓存和管理

- 可以兼容多种模型格式(目前只支持 alpaca 中文和英文的 int4 模型)

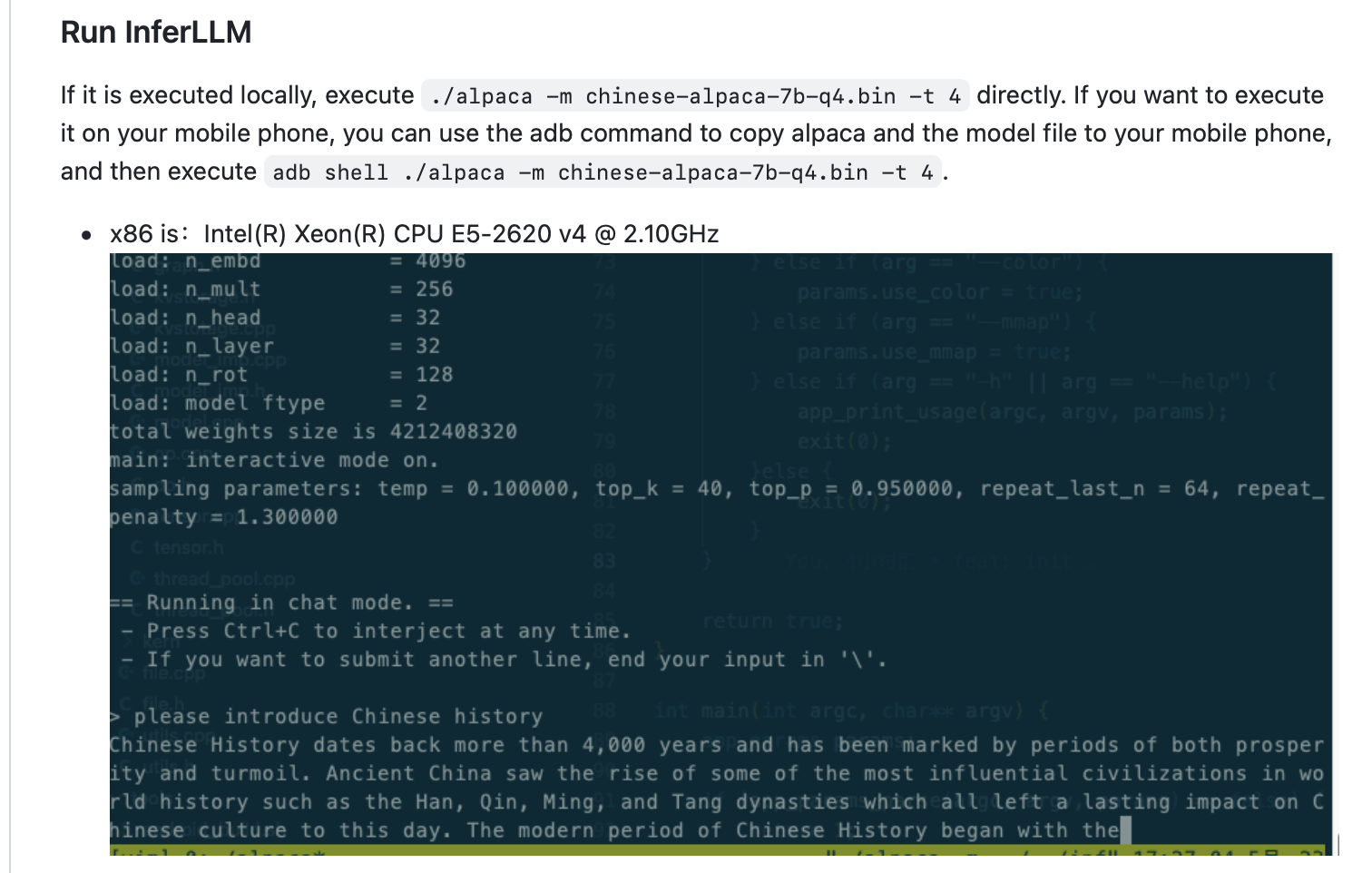

- 目前只支持 CPU,主要是 Arm 和 x86 平台,可以在手机上部署,速度在可以接受的范围

InferLLM 是一个简单高效的 LLM CPU 推理框架,可以本地部署 LLM 中的量化模型。

论文地址:https://github.com/MegEngine/InferLLM

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢