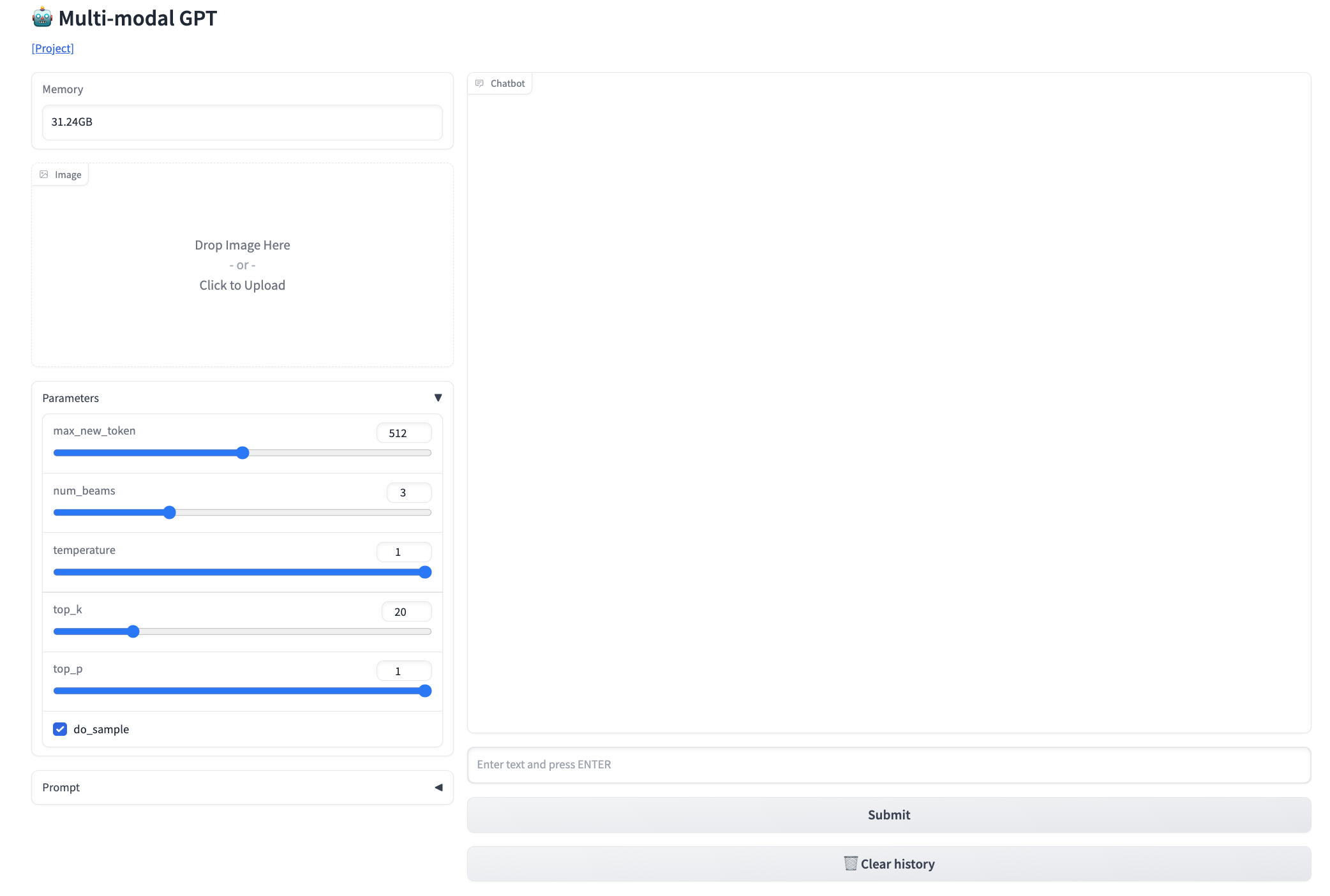

我们提出了一个名为MultiModal-GPT的愿景和语言模型,与人类进行多轮对话。MultiModal-GPT可以遵循人类的各种指令,例如生成详细的标题,计算感兴趣的对象数量,以及回答用户的一般问题。MultiModal-GPT从OpenFlamingo进行了参数高效微调,在语言模型的交叉注意力部分和自我注意力部分中都添加了低级适配器(LoRA)。

我们首先构建带有视觉和语言数据的指令模板,用于多模式指令调整,以使模型理解并遵循人类指令。我们发现训练数据的质量对对话表现至关重要,其中很少包含简短答案的数据可以导致模型快速响应任何指示。

为了进一步提高与MultiModal-GPT的人类聊天的能力,我们利用仅语言的指令跟踪数据来联合训练MultiModal-GPT。使用\emph{same}教学模板对纯语言和视觉语言教学的联合培训有效地提高了对话效果。各种演示展示了MultiModal-GPT与人类持续对话的能力。

作者:

论文地址:https://github.com/open-mmlab/Multimodal-GPT/blob/main/README_zh-CN.md

演示地址:https://mmgpt.openmmlab.org.cn/

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢