Not All Languages Are Created Equal in LLMs: Improving Multilingual Capability by Cross-Lingual-Thought Prompting

Haoyang Huang, Tianyi Tang, Dongdong Zhang, Wayne Xin Zhao, Ting Song, Yan Xia, Furu Wei

[Microsoft Research Asia & Renmin University of China]

通过跨语言思维提示来提高LMM的多语言能力

要点:

-

动机:大型语言模型(LLM)在多语言环境下表现出令人印象深刻的多语能力,但它们在不同语言之间的性能差异很大。 -

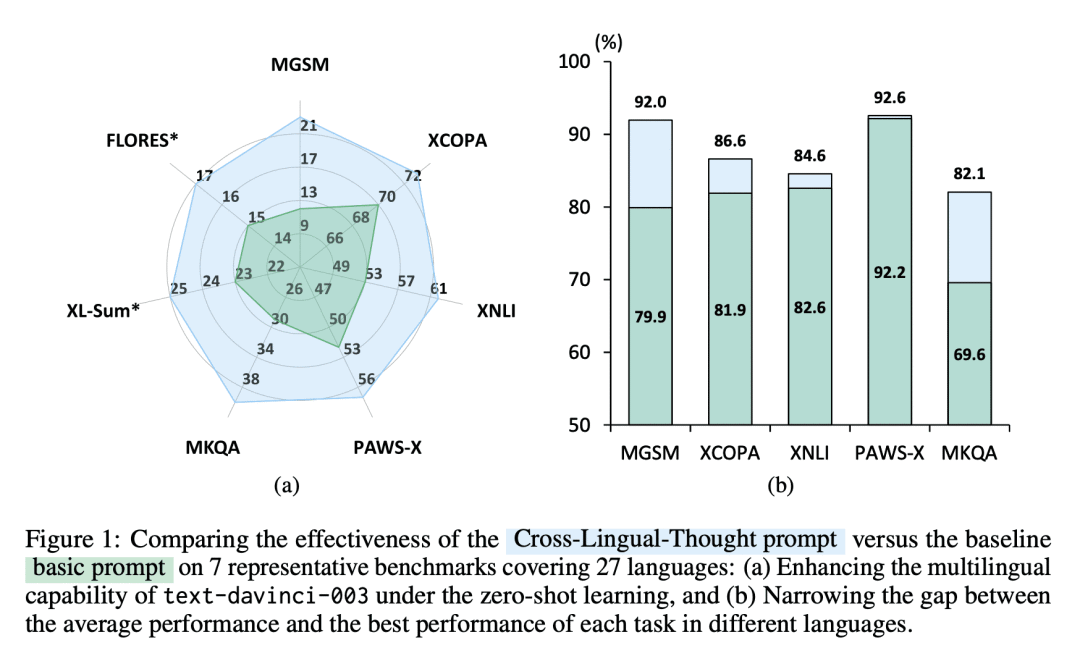

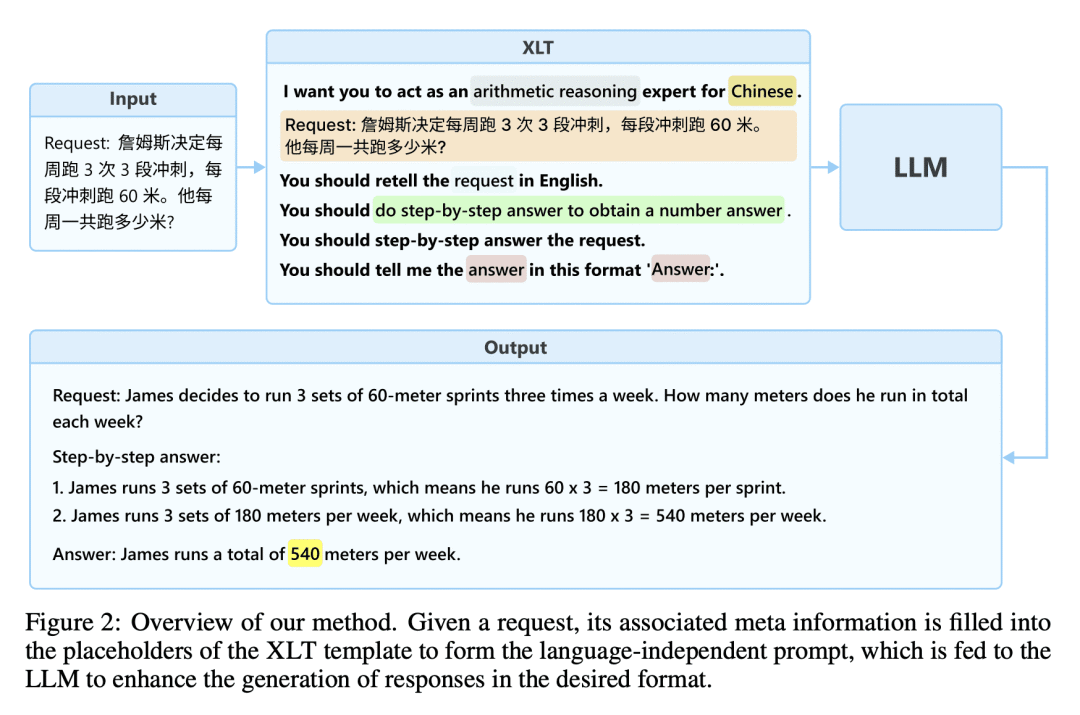

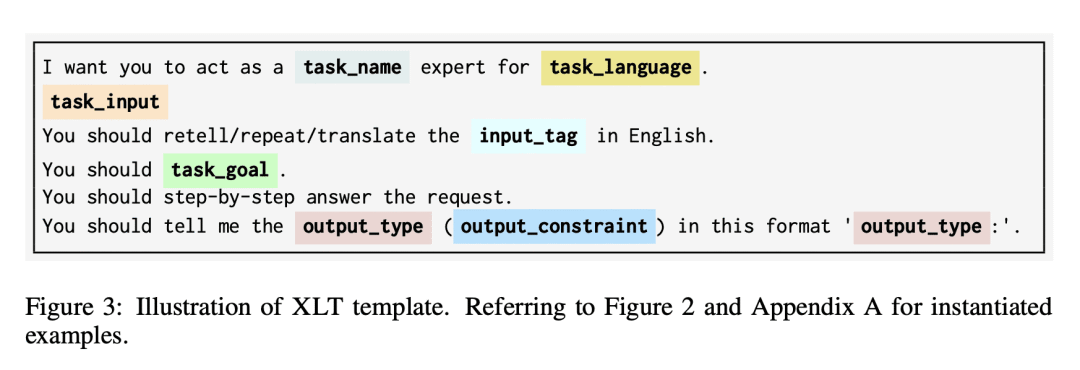

方法:引入一种简单而有效的方法,称为跨语言思维提示(XLT),以系统地提升LLM的多语能力。XLT是一个通用的模板提示,通过激发跨语言和逻辑推理能力,提高各种语言上的任务性能。优势:XLT显著提升了各种多语任务的性能,并在不同语言的每个任务的平均表现和最佳表现之间显著缩小了差距。尤其在算术推理和开放域问答任务中,XLT带来了超过10个百分点的平均改进。

通过跨语言思维提示(XLT)方法,系统地提升大型语言模型(LLM)在多语环境下的性能,缩小了不同语言之间的差距。

https://arxiv.org/abs/2305.07004

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢