《How to run Llama 13B with a 6GB graphics card》

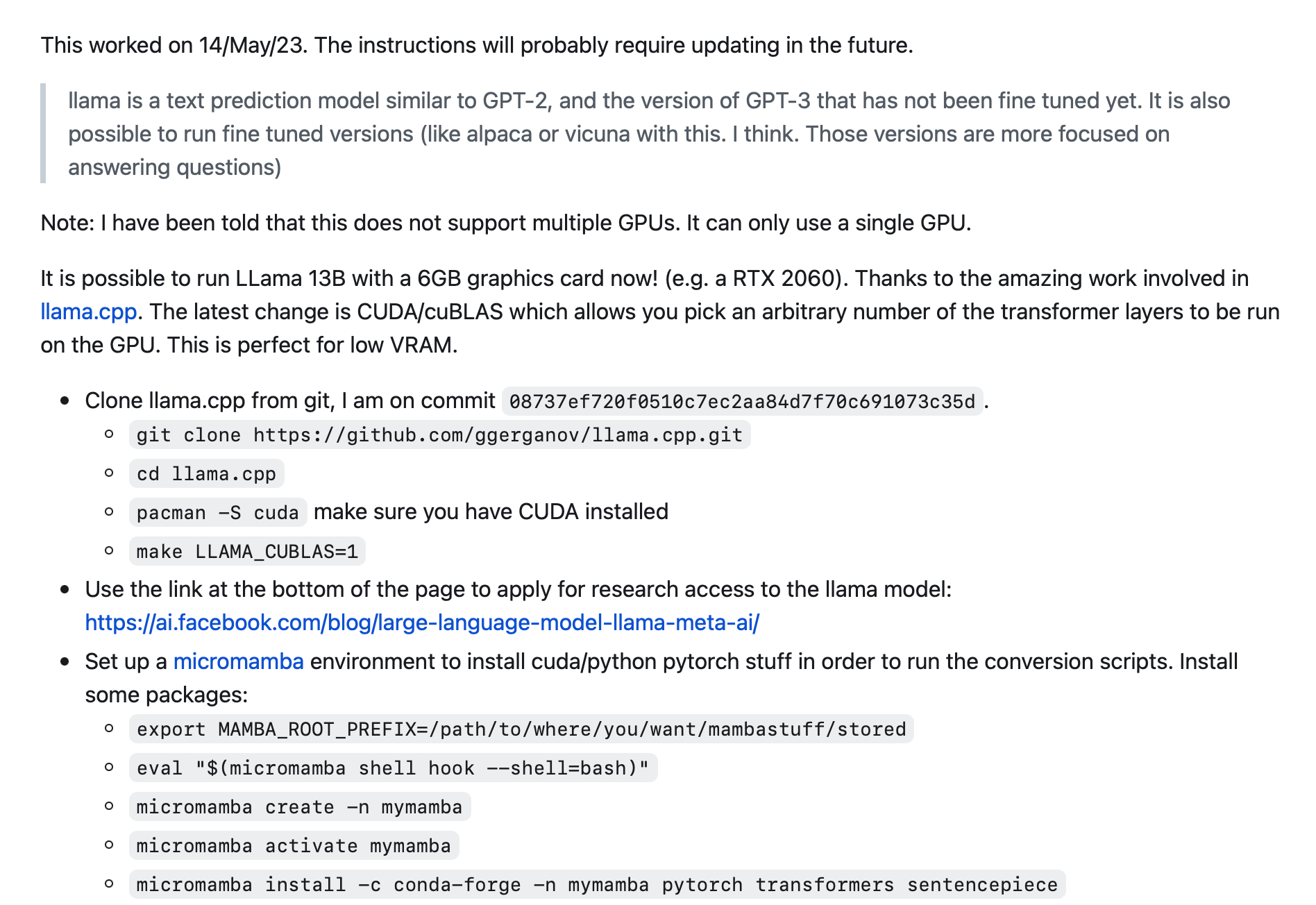

关于如何在6GB显卡上运行LLama 13B模型的教程,包括从git克隆llama.cpp,安装CUDA,设置micromamba环境,安装必要的包,执行转换过程,并生成一个提示文件等步骤。

该过程在6GB显卡上大约使用了5.5GB的显存。如果显存更大,可以将-ngl 18增加到-ngl 24甚至全部40层llama 13B模型,这样运行速度会更快

GitHub: https://gist.github.com/rain-1/8cc12b4b334052a21af8029aa9c4fafc

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢