Small Models are Valuable Plug-ins for Large Language Models

Microsoft & University of California, San Diego

提出Super In-Context Learning(SuperICL)方法,通过将大型语言模型与本地微调的小型模型结合使用,提高了在有监督任务上的性能,并解决了上下文学习的不稳定性问题。

-

动机:大型语言模型(LLM)的权重通常不可公开获取,而且庞大的模型难以使用常见硬件进行调优。相比之下,上下文学习(ICL)只能使用少量有监督示例。因此,需要一种替代方法,以提高在有监督任务上的性能。 -

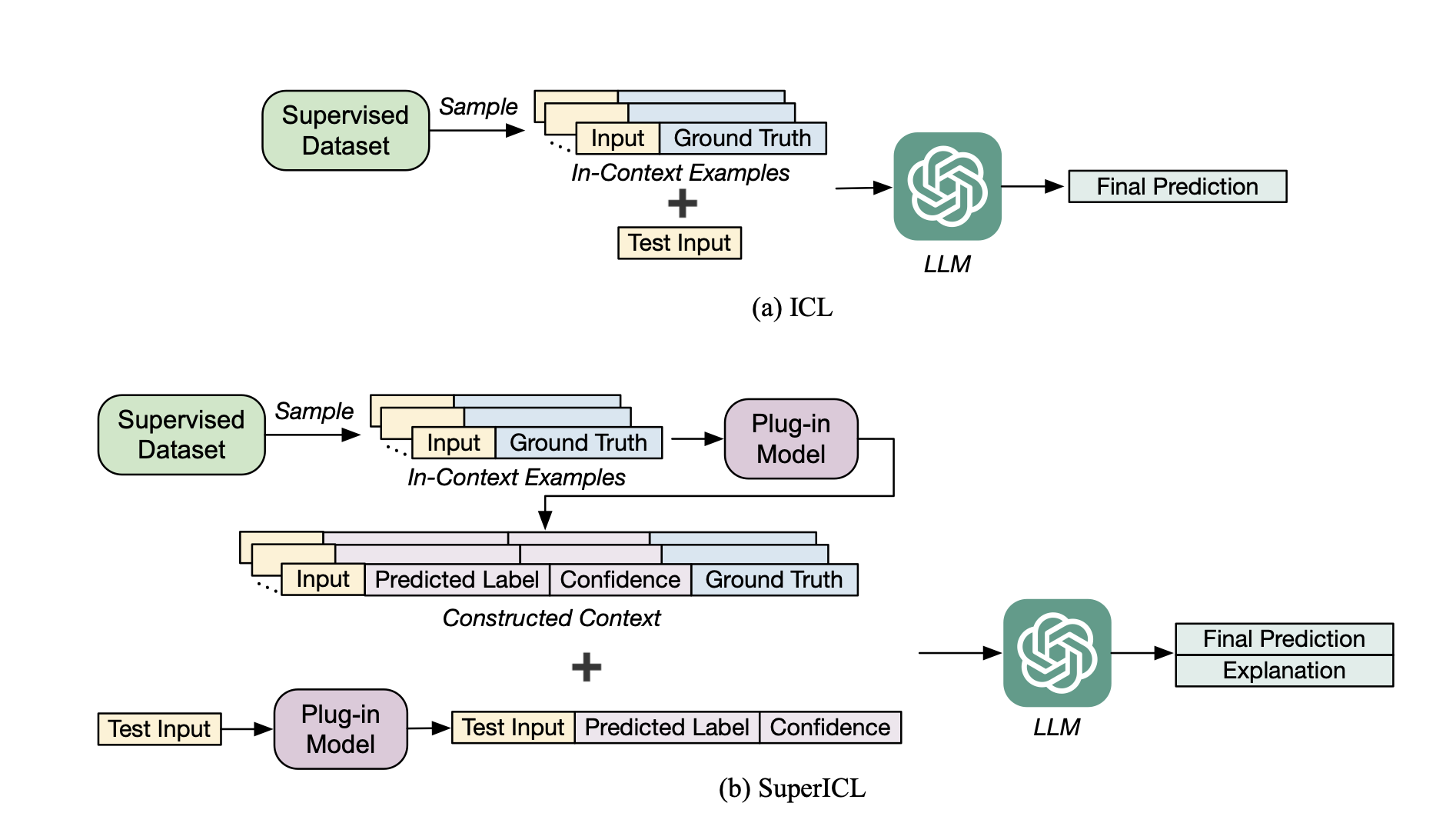

方法:提出Super In-Context Learning(SuperICL)方法,允许将黑盒LLM与本地微调的小型模型结合使用,从而在有监督任务上实现更好的性能。 -

优势:SuperICL方法超过了最先进的微调模型,解决了上下文学习的不稳定性问题,并增强了小型模型的能力,例如多语言性和可解释性。

本篇论文旨在解决大型语言模型在使用大规模监督数据进行有效调整时的挑战。作者提出了Super In-Context Learning(SuperICL)的方法,使黑盒大型语言模型可以与本地微调的小型模型一起使用,从而在受监督任务上获得更优异的性能。

关键思路:SuperICL方法的关键思路是使用本地微调的小型模型来作为大型语言模型的插件,从而提高性能。相比当前领域的研究,SuperICL方法的新意在于它可以在不使用大量监督数据的情况下,提高大型语言模型的性能。

其他亮点:本文的实验结果表明,SuperICL方法可以提高性能,甚至超过了目前最先进的微调模型。此外,SuperICL方法还可以增强小型模型的多语言性和可解释性。作者还开源了代码,使得这个方法可以被更广泛地使用和研究。

关于作者:Canwen Xu, Yichong Xu, Shuohang Wang, Yang Liu, Chenguang Zhu, Julian McAuley

论文摘要:小型模型是大型语言模型的有价值的插件,GPT-3和GPT-4,非常强大,但它们的权重通常不公开,并且它们庞大的大小使得这些模型难以使用普通硬件进行调整。因此,有效地使用大规模监督数据来调整这些模型可能具有挑战性。作为替代方案,由于上下文长度限制,In-Context Learning(ICL)只能使用少量监督示例。在本文中,我们提出了Super In-Context Learning(SuperICL),它允许黑盒LLMs与本地微调的较小模型配合工作,从而在监督任务上实现更优越的性能。我们的实验表明,SuperICL可以提高性能,超越最先进的微调模型,同时解决上下文学习的不稳定性问题。此外,SuperICL可以增强较小模型的功能,例如多语言性和可解释性。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢