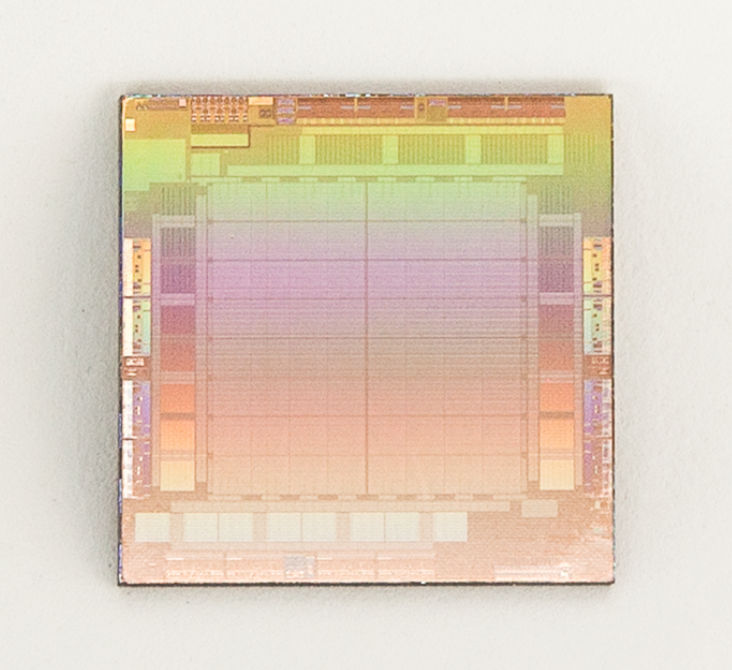

5 月 18 日,Meta 披露了旗下数据中心项目支持 AI 工作的细节,提到已经打造一款定制芯片,Meta将新芯片称为Meta Training and Inference Accelerator,简称MTIA,并将其描述为用于加速人工智能培训和推理工作负载的芯片“家族”的一部分。(“推理”是指运行经过训练的模型。)MTIA是一种ASIC,一种将不同电路组合在一个电路板上的芯片,允许对其进行编程,以同时执行一项或多项任务。

用于加快生成式 AI 模型的训练。这是 Meta 首次推出 AI 定制芯片。Meta 称,MTIA 是加快 AI 训练和推理工作负载的芯片「家族」的一部分,这意味着后续 Meta 还将开发、推出更多芯片产品。

MTIA 全称为 Meta 训练和推理加速器。所谓推理是指运行经过训练的模型。MTIA 是一种 ASIC,也就是将不同电路集成在一块板上的芯片,可以将它进行编程,执行一项或多项任务。

Meta 介绍,MTIA 采用开源芯片架构 RISC-V,它的功耗仅有 25 瓦,远低于英伟达等主流芯片厂商的产品功耗。

Meta的软件工程师Joel Cohurn介绍新芯片时称,Meta最初用图形处理单元(GPU)执行推理任务,发现GPU不太适合这种工作。用GPU固然可以大幅优化软件,但对真实模型的效率很低,现实配置时难度大、成本高。所以Meta需要MTIA。

Meta承认,MTIA芯片在处理高复杂度AI模型时遇到了问题,但指出,它比竞品芯片能更有效地处理中低复杂度的模型。

Meta表示,芯片在内存和网络领域的工作还未完成,随着AI模型发展,这些工作会出现瓶颈。目前,MTIA 的重点放在Meta应用家族的推理,而不是训练。不过Meta 强调,MTIA“大大”提高了单位瓦特的推荐负载运行效率,让公司能运行加强版的、更尖端的AI工作负载。

Meta本周四并未披露配置新芯片的时间表,也未说明具体有什么计划开发可能训练模型的芯片。

Meta同时介绍,计划针对以AI为核心的网络和冷却系统,重新设计其数据中心,今年内,首个相关数据中心的设施将破土动工。Meta的员工演示时称,新设计的成本将降低31%,而且建造速度是公司目前数据中心的两倍。

Meta还介绍了旗下的一种AI驱动系统,它可帮助Meta的工程师编写电脑代码。Meta的AI助力代码工具名为CodeCompose,目前没有对外公开。公司团队内部用它获取Python 和其他语言的代码建议。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢