保持记忆力还是健忘?深入探究语言模型的知识记忆机制

标题:Retentive or Forgetful? Diving into the Knowledge Memorizing Mechanism of Language Models

链接:https://arxiv.org/abs/2305.09144

作者:Boxi Cao, Qiaoyu Tang, Hongyu Lin, Xianpei Han, Jiawei Chen, Tianshu Wang, Le Sun

单位:中国信息处理实验室,中国科学院软件研究所计算机科学国家重点实验室,中国科学院大学

摘要:

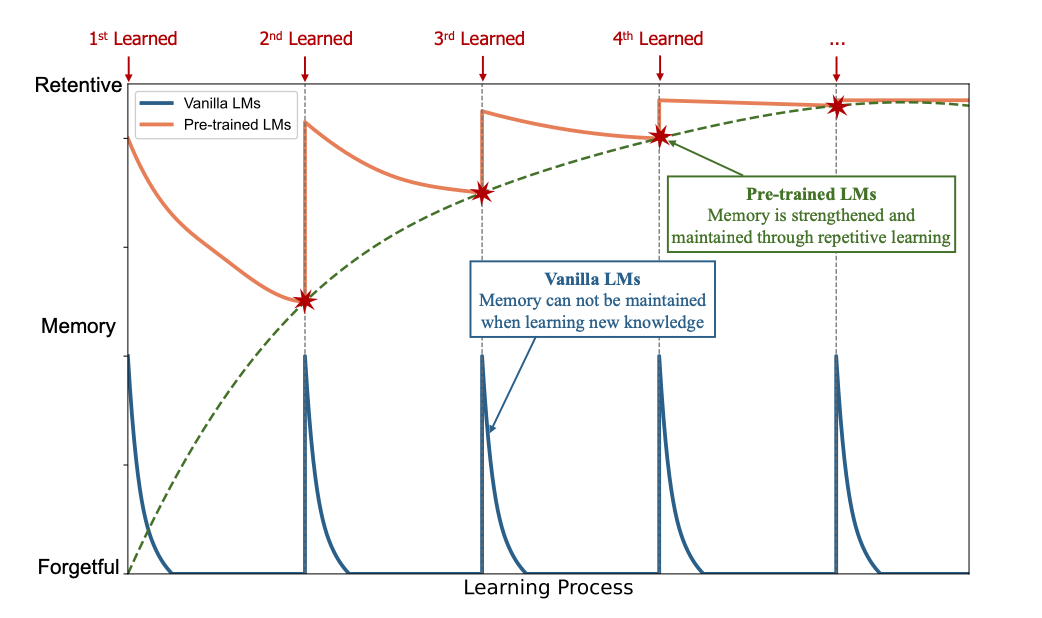

记忆是最基本的认知功能之一,作为世界知识和活动片段的存储库。近年来,大规模预训练语言模型展现出了非凡的记忆能力。相反,没有经过预训练的普通神经网络长期以来被观察到存在灾难性遗忘问题。为了研究这种保留与遗忘的矛盾现象,并了解语言模型的记忆机制,本文通过控制目标知识类型、学习策略和学习计划进行了全面的实验。

本文发现:

1)普通语言模型易受遗忘;

2)预训练可以使语言模型具有保留能力;

3)知识相关性和多样性显著影响记忆形成。这些结论有助于理解预训练语言模型的能力,并为设计和评估语言模型的新学习和推理算法提供了启示。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢