Scaling Speech Technology to 1,000+ Languages

https://research.facebook.com/publications/scaling-speech-technology-to-1000-languages/

文章地址:

https://ai.facebook.com/blog/multilingual-model-speech-recognition/

Github

https://github.com/facebookresearch/fairseq/tree/main/examples/mms

Meta 构建了一个支持 1100 种语言的文本转语音系统。当前文本转语音模型的训练数据通常是来自单个说话人的语音语料。MMS 数据的一个局限性是许多语言都只有少量说话人,甚至往往只有一个说话人。但是,在构建文本转语音系统时,这却成了一个优势,于是 Meta 就顺便造了一个支持 1100 多种语言的 TTS 系统。

方法

收集数千种语言的音频数据是我们面临的第一个挑战,因为现有的最大语音数据集最多覆盖100种语言。为了克服它,我们转向了宗教文本,如圣经,这些文本已被翻译成许多不同的语言,其翻译已被广泛研究用于基于文本的语言翻译研究。这些翻译有公开的以不同语言阅读这些文本的人的录音。作为该项目的一部分,我们创建了1100多种语言的新约阅读数据集,平均每种语言提供32小时的数据。

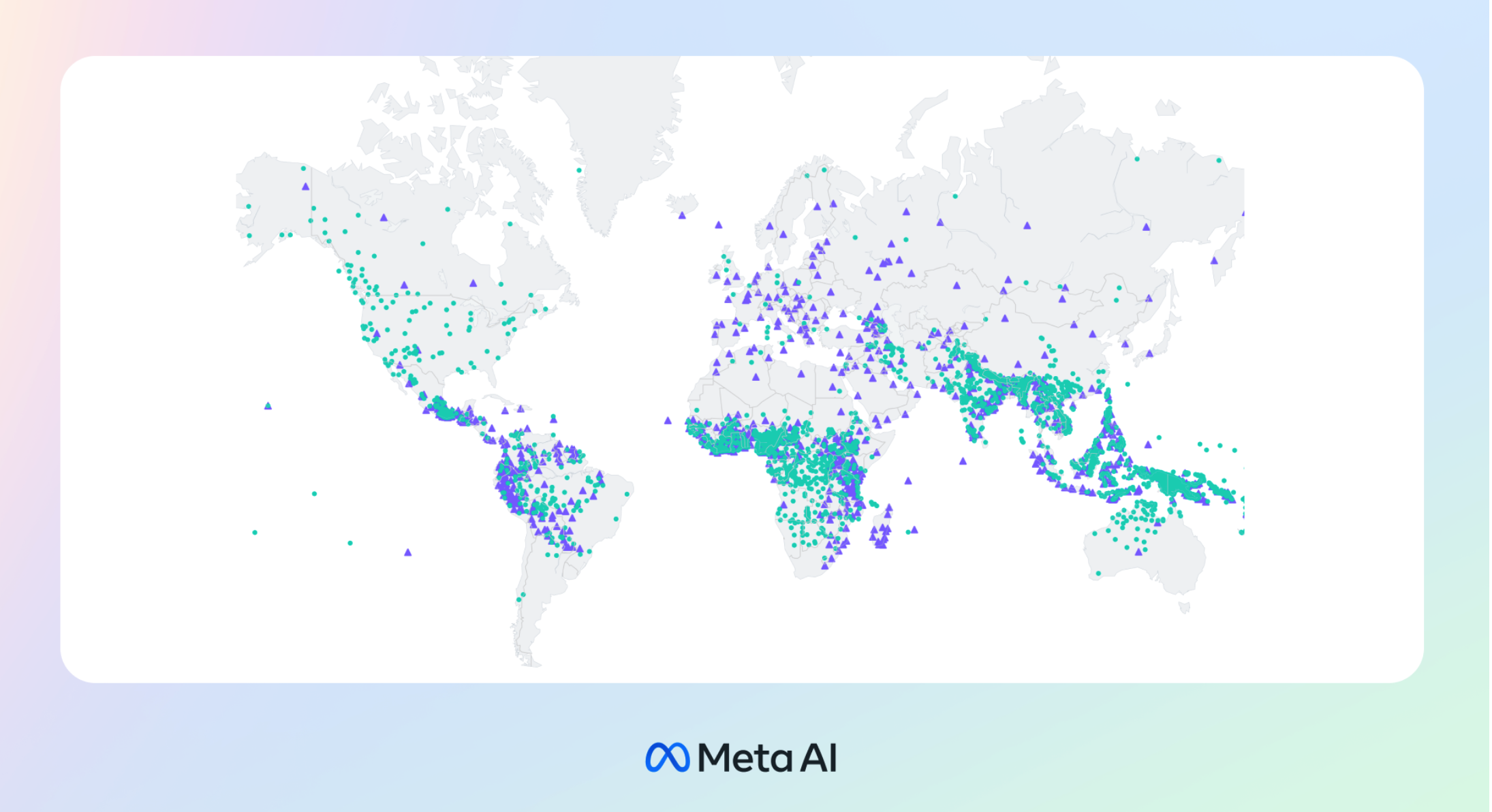

通过考虑其他各种基督教宗教读物的无标签录音,我们将可用语言的数量增加到4000多种。虽然这些数据来自特定领域,并且经常被男性演讲者阅读,但我们的分析表明,我们的模型在男性和女性声音方面表现同样好。虽然录音的内容是宗教性的,但我们的分析表明,这不会过度偏袒模型以产生更多的宗教语言。我们认为这是因为我们使用连接时间分类方法,与用于语音识别的大型语言模型(LLM)或序列到序列模型相比,该方法的约束力要大得多。

我们预处理了数据,以提高质量,并使其可用于我们的机器学习算法。为此,我们在100多种语言的现有数据上训练了一个对齐模型,并将该模型与高效的强制对齐算法一起使用,该算法可以处理大约20分钟或更长时间的记录。我们应用了此过程的多轮,并根据模型准确性执行了最终的交叉验证过滤步骤,以删除可能错位的数据。为了使其他研究人员能够创建新的语音数据集,我们将对齐算法添加到PyTorch中,并发布了对齐模型。

每门语言32小时的数据不足以训练传统的监督语音识别模型。这就是为什么我们建立在wav2vec 2.0上,这是我们之前在自我监督语音表示学习方面的工作,这大大减少了训练良好系统所需的标记数据量。具体来说,我们用1400多种语言的大约50万小时的语音数据训练了自我监督模型——这几乎是之前任何已知工作语言的五倍。然后对生成的模型进行微调,以适应特定的语音任务,例如多语言语音识别或语言识别。

结果

为了更好地了解在大规模多语言语音数据上训练的模型表现如何,我们在现有的基准数据集(如FLEURS)上对其进行了评估。

我们使用1B参数wav2vec 2.0模型在1100多种语言上训练了多语言语音识别模型。随着语言数量的增加,性能确实下降了,但只是非常轻微:从61种语言移动到1107种语言,字符错误率仅增加了约0.4%,但语言覆盖率增加了18倍以上。

当每个系统支持的语言数量从61种增加到1107种时,经过大规模多语言语音数据训练的多语言语音识别系统的61种FLEURS语言的错误率。更高的错误率表示性能较低。

在与OpenAI的Whisper的同类比较中,我们发现,在Massively Multilingual Speech数据上训练的模型实现了单词错误率的一半,但Massively Multilingual Speech涵盖了11倍的语言。这表明,与当前最好的语音模型相比,我们的模型可以表现得非常好。

我们的结果让我们感到鼓舞,但与所有新的人工智能技术一样,我们的模型并不完美。例如,语音转文本模型可能会错误地转录选定的单词或短语。根据输出,这可能会导致冒犯性和/或不准确的语言。我们仍然认为,整个人工智能社区的合作对于人工智能技术的负责任发展至关重要。

迈向支持数千种语言的单一语音模式

世界上许多语言都面临消失的危险,当前语音识别和语音生成技术的局限性只会加速这一趋势。我们设想了一个技术产生相反效果的世界,鼓励人们保持他们的语言活力,因为他们可以通过用他们喜欢的语言获得信息并使用技术。

大规模多语言演讲项目朝着这个方向迈出了重要的一步。在未来,我们希望增加语言覆盖率,以支持更多的语言,并解决处理方言的挑战,这对现有的语音技术来说往往是困难的。我们的目标是让人们更容易地以他们喜欢的语言访问信息和使用设备。语音技术还有许多具体的用例——例如VR/AR技术——可以用一个人的首选语言——到可以理解每个人声音的消息服务。

我们还设想了一个未来,一个模型可以解决所有语言的多个语音任务。虽然我们训练了语音识别、语音合成和语言识别的单独模型,但我们相信,在未来,单个模型将能够完成所有这些任务和更多任务,从而带来更好的整体性能。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢